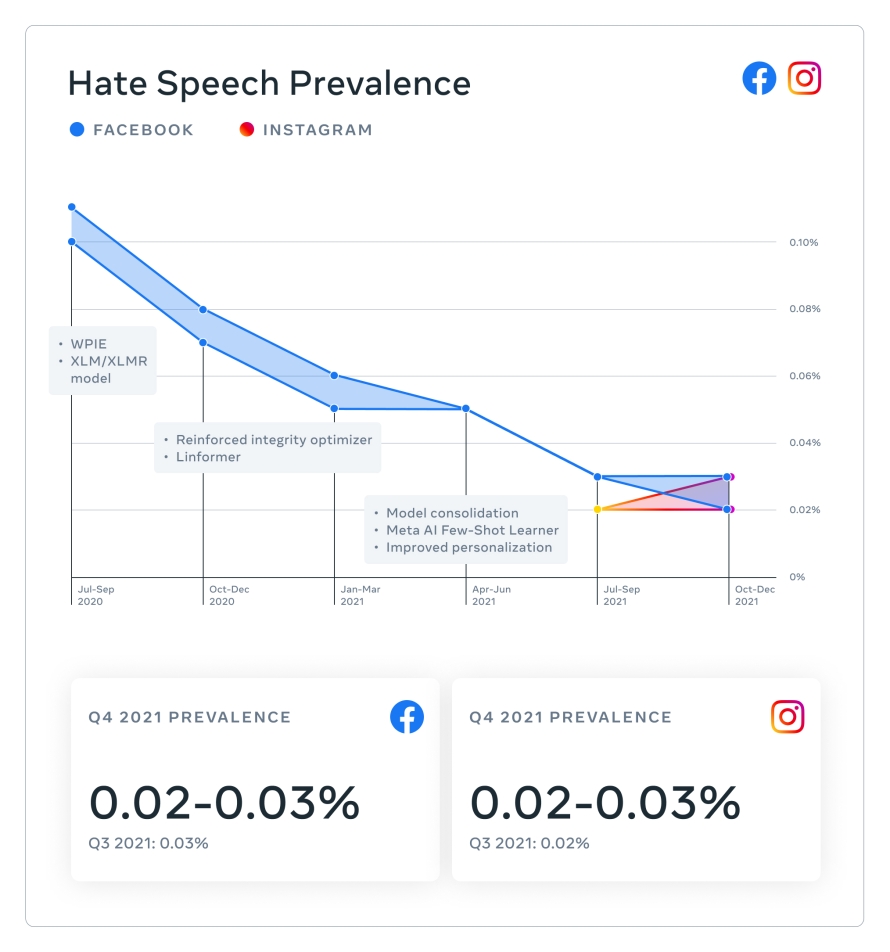

- La prevalencia de contenido dañino en Facebook e Instagram se mantuvo relativamente constante y disminuyó en algunas áreas, del tercer trimestre al cuarto trimestre, en parte debido a mejoras y ampliaciones en nuestras tecnologías de detección proactiva.

Hoy publicamos nuestro Informe de Cumplimiento de Normas Comunitarias correspondiente al cuarto trimestre de 2021, con métricas sobre cómo aplicamos nuestras políticas entre octubre de 2021 y diciembre de 2021 en 14 áreas de políticas en Facebook y 12 en Instagram.

También, estamos compartiendo:

- El Informe de Contenido Ampliamente Visualizado, correspondiente al cuarto trimestre de 2021

- El reporte trimestral del Consejo Asesor de Contenido para el cuarto trimestre de 2021

- Una publicación en nuestro blog de diseño sobre nuestros esfuerzos sobre diseño de integridad para prevenir el mal uso de nuestras tecnologías y promover la aplicación efectiva y justa de nuestras políticas

Todos estos informes están disponibles en el Centro de Transparencia.

Aspectos destacados del informe

La prevalencia de contenido dañino en Facebook e Instagram se mantuvo relativamente constante, y disminuyó en algunas áreas, del tercer al cuarto trimestre, lo que significa que la gran mayoría del contenido que los usuarios encuentran generalmente no infringe nuestras políticas.

Continuamos viendo números constantes en el contenido sobre el que tomamos acciones en muchas áreas.

En Facebook, en el cuarto trimestre tomamos medidas sobre:

- 4 millones de piezas de contenido relacionado con drogas, un aumento respecto a las 2,7 millones en el tercer trimestre de 2021, debido a las mejoras realizadas en nuestras tecnologías de detección proactiva.

- 1,5 millones de piezas de contenido relacionado con armas de fuego, un aumento respecto a las 1,1 millones en el tercer trimestre, debido a tecnologías de detección proactiva mejoradas y ampliadas.

- 1.200 millones de piezas de contenido de spam, un aumento respecto a las 777 millones registradas en el tercer trimestre, debido a una gran cantidad de contenido eliminado en diciembre.

En Instagram, en el cuarto trimestre, tomamos medidas sobre:

- 905.000 piezas de contenido relacionadas con terrorismo, un aumento respecto a las 685.000 piezas de contenido del tercer trimestre, debido a las mejoras realizadas en nuestras tecnologías de detección proactiva.

- 195.000 piezas de contenido relacionado con armas de fuego, un aumento respecto a las 154.000 del tercer trimestre, debido a tecnologías de detección proactiva mejoradas y ampliadas.

En el informe del tercer trimestre, por primera vez comenzamos a reportar las métricas de prevalencia sobre intimidación y el acoso. En el cuarto trimestre, la prevalencia del acoso y la intimidación en Instagram se mantuvo relativamente constante, de 0,05-0,06 %. En Facebook, la prevalencia de la intimidación y el acoso fue de 0,11 a 0,12 % en el cuarto trimestre, por debajo de 0,14 al 0,16 % reportado en el tercer trimestre. La reducción en la prevalencia se debió, en parte, a las actualizaciones de políticas que consideran el lenguaje que, sin contexto adicional, podría considerarse ofensivo, pero que en realidad se usa de manera familiar o en broma entre amigos.

Nuestra mejora constante en la reducción de contenido dañino

Nuestra mejora constante se puede atribuir a un enfoque holístico, incluidas nuestras políticas, la tecnología que nos ayuda a que se cumplan, la parte operativa de la moderación de contenido global y un proceso de diseño de productos que se centra en la seguridad y la integridad.

Con los avances en las tecnologías de IA, como nuestro sistema de aprendizaje de pocos disparos y el cambio a la IA generalizada, hemos podido tomar medidas sobre el contenido dañino con mayor rapidez.

Nuestros equipos de diseño de productos juegan un papel importante en nuestro esfuerzo por reducir el contenido dañino. Al diseñar cuidadosamente nuestros productos de redes sociales, podemos promover una mayor seguridad mientras brindamos a las personas contexto, control y espacio para expresarse. Por ejemplo, cuando se aplican, pantallas y etiquetas informativas brindan más contexto y limitan la exposición de las personas a información errónea o contenido gráfico. Lee más sobre nuestro proceso de diseño de integridad.

El otoño pasado, lanzamos el Estado de la cuenta en Instagram, que ayuda a las personas a comprender por qué se eliminó un contenido y qué políticas infringió. Sabemos que este nivel de transparencia es importante porque ayuda a las personas a comprender mejor nuestras políticas y también ayuda a nuestros sistemas al darnos indicaciones cuando nos hemos equivocado. Después de este lanzamiento, vimos un aumento del contenido restaurado en Instagram en varias áreas de políticas, incluidas la violencia y la incitación, la incitación al odio, la intimidación y el acoso, así como desnudos y actividad sexual de adultos.

Siempre estamos tratando de identificar las políticas que podemos estar aplicando de manera insuficiente o excesiva para mejorar. Por ejemplo, en 2020, durante el Mes de Concientización sobre el Cáncer de Mama, hubo un incremento de contenido relacionado con el cáncer de mama en Instagram, incluidas imágenes que contenían desnudos que eran de naturaleza médica. Si bien estas no violan nuestras políticas, muchas fueron incorrectamente removidas por nuestros sistemas. Nuestra comunidad nos dijo que necesitábamos mejorar la forma en que aplicamos las políticas sobre este tipo de contenido. La Junta de Supervisión también escuchó un caso relacionado con los síntomas del cáncer de mama y la desnudez y nos pidió que mejoráramos nuestra precisión en la aplicación de normas.

Desde entonces, hemos estado trabajando para mejorar la precisión en la aplicación de nuestras políticas sobre el contenido de salud, incluido el relacionado con el cáncer de mama y las cirugías. Definimos y aclaramos nuestra excepción para la desnudez médica entrenando nuestros sistemas de IA para reconocer mejor los torsos expuestos con cicatrices de mastectomía y aumentando el contenido marcado como desnudez médica para revisión humana, para mejorar aún más la precisión de nuestras acciones. También, enviamos contenido con palabras clave de uso frecuente para revisión humana. Finalmente, entrenamos a nuestros sistemas para reconocer mejor las imágenes benignas y no infractoras y evitar la aplicación excesiva de nuestras normas en el futuro. Como resultado, vimos una aplicación significativamente menor durante el Mes de Concientización sobre el Cáncer de Mama del año pasado, lo que permitió a nuestra comunidad compartir contenido abiertamente.

Integridad y transparencia de cara al futuro

Buscamos constantemente nuevas formas de mejorar nuestra transparencia y preservar la integridad de nuestras plataformas. Durante muchos años, hemos publicado informes de transparencia semestrales, que incluyen el número de restricciones de contenido que hacemos cuando se informa que el contenido infringe la ley local pero no infringe nuestras Normas Comunitarias. Ahora, hemos decidido contribuir a Lumen, un proyecto de investigación independiente que lleva a cabo el Centro Berkman Klein para Internet y Sociedad de Harvard, que estudia cartas de cese y desistimiento de gobiernos y actores privados respecto al contenido en línea. Nos unimos a Project Lumen porque nos permite responsabilizar a los gobiernos, los tribunales, los reguladores y a nosotros mismos por el contenido que solicitan que se elimine según la ley local. Esperamos ampliar nuestra participación en Lumen con el tiempo.

Continuaremos nuestro progreso para hacer cumplir nuestras políticas en 2022. Siempre estamos trabajando para mejorar, ser transparentes y compartir datos relevantes.