Hoy, por primera vez, incluimos la prevalencia del discurso de odio en Facebook como parte de nuestro Informe trimestral de Cumplimiento de nuestras Normas Comunitarias.

La manera en la que medimos la prevalencia del discurso de odio

La prevalencia estima el porcentaje de veces que las personas ven contenido infractor en nuestra plataforma. Calculamos la prevalencia del discurso de odio seleccionando una muestra de contenido visto en Facebook y marcando la cantidad que viola nuestras políticas de discurso de odio. Considerando que la incitación al odio depende del idioma y el contexto cultural, enviamos estas muestras representativas a revisores de contenido de diferentes regiones. Con base en esta metodología, estimamos que la prevalencia del discurso de odio desde julio de 2020 hasta septiembre de 2020 fue de 0,10% a 0,11%. En otras palabras, de cada 10.000 visualizaciones de contenido en Facebook, de 10 a 11 incluían discurso de odio.

Específicamente, medimos cuánto contenido dañino puede verse en Facebook e Instagram dado a que la mayoría de las veces el contenido no se distribuye de manera uniforme. Una pieza de contenido podría volverse viral y ser vista por muchas personas en muy poco tiempo, mientras que otra podría estar en Internet durante mucho tiempo y solo pocas personas podrían verla.

Evaluamos la efectividad de la aplicación de nuestras políticas tratando de mantener la prevalencia del discurso de odio lo más baja posible en nuestra plataforma, al mismo tiempo que minimizamos los errores en el contenido que eliminamos.

Definición y tratamiento de los matices del discurso de odio

Definir el discurso del odio no es simple, ya que hay muchas opiniones diferentes sobre lo que constituye. Los matices, la historia, el idioma, la religión y las cambiantes normas culturales son factores importantes a considerar al definir nuestras políticas.

Basándonos en los aportes de diversos expertos y líderes a nivel mundial, definimos el discurso de odio como todo lo que ataca directamente a las personas en función de características protegidas, como raza, etnia, nacionalidad de origen, afiliación religiosa, orientación sexual, sexo, género, identidad de género o discapacidad o enfermedad grave.

En los últimos años, hemos ampliado nuestras políticas para brindar mayor protección a las personas ante diferentes tipos de abuso. Hemos tomado medidas para combatir el nacionalismo y separatismo blanco; presentamos nuevas normas sobre contenidos que llaman a la violencia contra migrantes; prohibimos la negación del holocausto, y actualizamos nuestras políticas para tener en cuenta ciertos tipos de incitación implícita al odio, como el contenido que describe la cara negra o estereotipos sobre los judíos que aluden a que controlan el mundo.

Nuestro objetivo es eliminar el discurso de odio cada vez que nos percatamos de ello, pero sabemos que aún nos queda mucho por hacer. El lenguaje sigue evolucionando y una palabra que ayer no era un insulto puede convertirse en uno el día de mañana. Esto significa que la aplicación de nuestras políticas de contenido es un equilibrio delicado entre asegurarnos de actuar sobre el discurso del odio y evitar eliminar otras formas de discurso que están permitidas. Es por eso que damos prioridad al contenido más crítico para que nuestro equipo lo revise en función de factores como la viralidad, la gravedad del daño y la probabilidad de infracción.

El papel de los reportes de usuario

Cuando se trata de la aplicación de nuestras políticas, utilizamos una combinación de reportes de usuarios y tecnología para encontrar discursos de odio en Facebook e Instagram. Cada semana, personas de todo el mundo nos informan sobre millones de piezas de contenido que creen podrían estar violando nuestras políticas. Estos reportes se revisan en más de 50 idiomas y nos brindan información sobre lo que sucede en nuestra plataforma para que podamos seguir perfeccionando nuestras políticas. También nos esforzamos por mejorar nuestras herramientas de reporte para que a las personas les resulte más fácil denunciar contenido que pudiera infringir nuestras políticas, pero esto tiene limitaciones. Por ejemplo, en zonas con menor alfabetización digital, las personas pueden tener poco conocimiento sobre las opciones que tienen para realizar un reporte. Las personas también suelen informar de contenido que no les gusta o con el que no están de acuerdo, pero que no infringe nuestras políticas. Por ejemplo, los usuarios pueden reportar sobre contenido de equipos deportivos rivales o spoilers de programas de televisión. Además, es posible que un contenido sea visto por muchas personas antes de ser reportado, por lo que no podemos confiar únicamente en los reportes de los usuarios.

Usamos inteligencia artificial para ayudar a priorizar el contenido para revisión, de modo que nuestros revisores puedan enfocarse en el contenido que representa el mayor daño y dedicar más tiempo a capacitar y medir la calidad de nuestros sistemas automatizados.

El papel de las herramientas y los sistemas de IA

Hemos desarrollado herramientas y sistemas de inteligencia artificial para detectar y eliminar de forma proactiva el discurso de odio a gran escala. Debido a que el discurso del odio es tan contextual, la detección de IA requiere de una capacidad para revisar publicaciones de manera integral, con contexto y en varios idiomas.

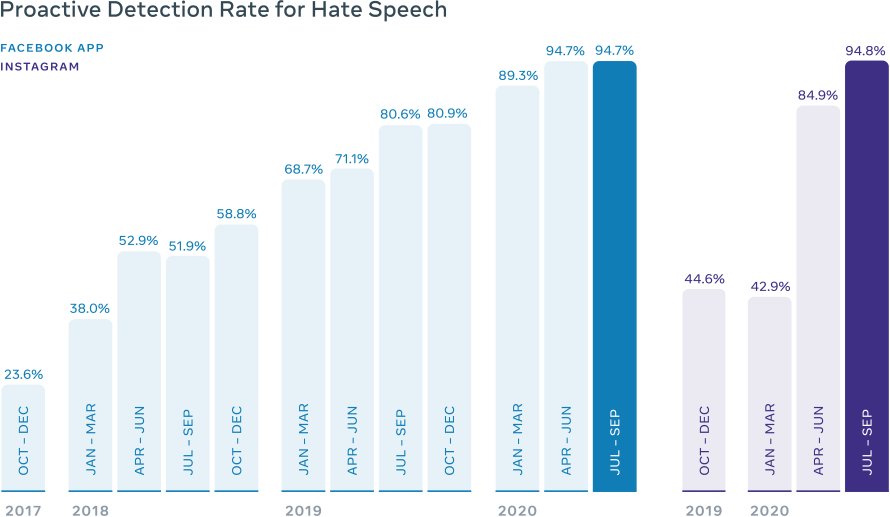

Con el tiempo, los avances en las tecnologías de inteligencia artificial nos han permitido eliminar una mayor cantidad de contenido de discurso de odio de Facebook y encontrarlo más del mismo antes de que los usuarios lo denuncien. Cuando comenzamos a informar nuestras métricas de incitación al odio, en el cuarto trimestre de 2017, nuestra tasa de detección proactiva fue de 23,6%. Esto significa que del discurso de odio que eliminamos, 23,6% se encontró antes de que un usuario nos lo denunciara. La mayoría restante fue eliminada después de que los usuarios lo reportaran. Hoy, detectamos proactivamente cerca de 95% de discurso de odio que removemos. Ya sea que lo detectemos proactivamente o sea reportado por los usuarios, a menudo usamos IA para actuar en casos sencillos y priorizar los más difíciles para nuestros revisores, en donde se debe de considerar el contexto y los matices.

Hemos invertido millones de dólares en recursos humanos y tecnología para aplicar estas reglas y contamos con más de 35.000 personas especializadas en seguridad dentro de Facebook. Conforme el lenguaje evoluciona con el tiempo, continuaremos revisando nuestras políticas para que reflejen las tendencias sociales cambiantes. Pero, creemos que las decisiones sobre la libertad de expresión y seguridad no deberían ser hechas únicamente por Facebook, por lo que continuaremos consultando expertos externos para diseñar nuestras políticas y tácticas para aplicarlas. Para decisiones de contenido difíciles y relevantes, ahora podemos remitir casos al Consejo Asesor de Contenido para su revisión independiente y decisiones vinculantes.

Con el uso de la prevalencia, los reportes de usuarios e IA, trabajamos para hacer de Facebook e Instagram lugares inclusivos y seguros para todos los que los usan.