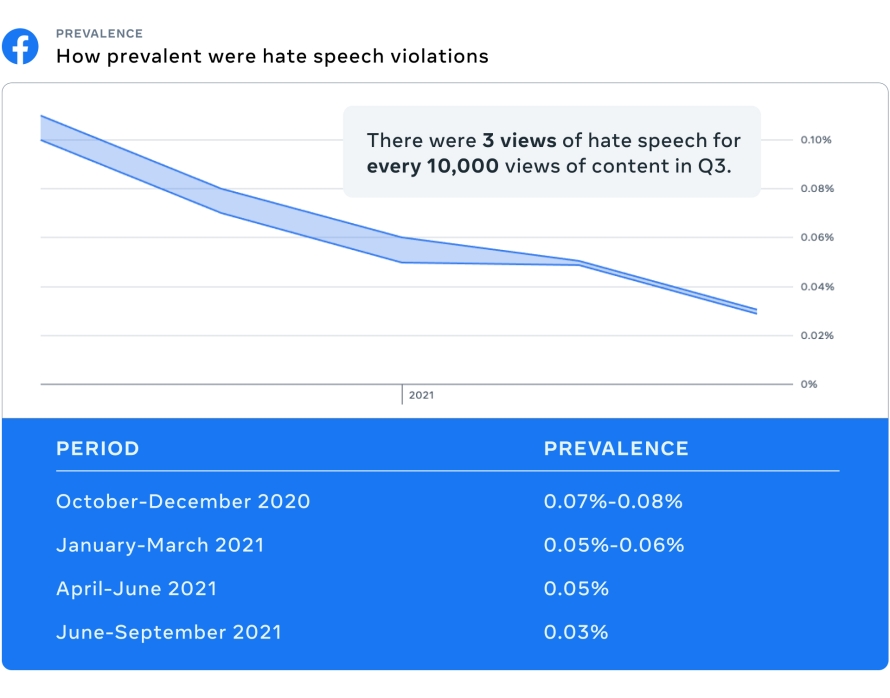

- A prevalência do discurso de ódio no Facebook continuou a diminuir pelo quarto trimestre consecutivo. Reduzimos em mais da metade a prevalência no ano passado, por meio de melhorias em nossa tecnologia e com mudanças que fizemos para reduzir o conteúdo problemático no Feed de Notícias.

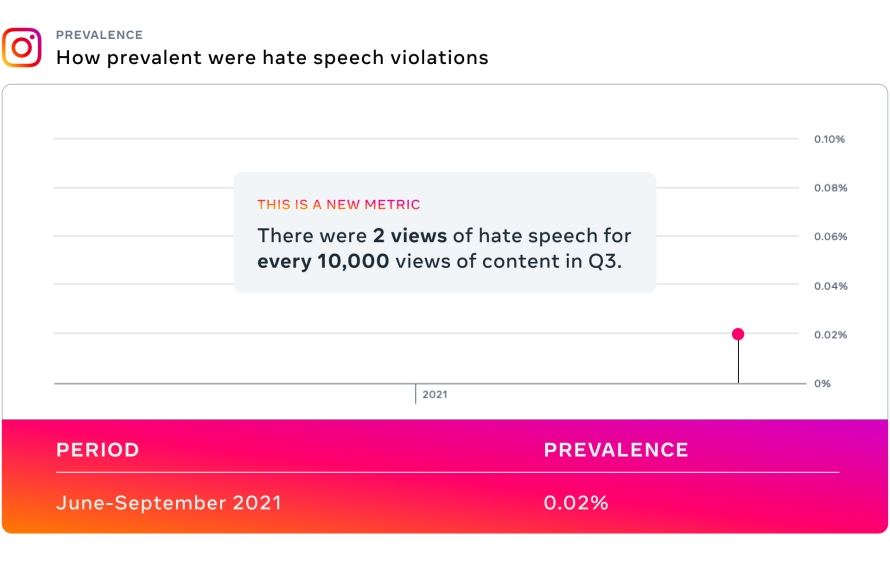

- Pela primeira vez, estamos compartilhando métricas de prevalência de bullying e assédio no Facebook e no Instagram, métricas de prevalência de discurso de ódio no Instagram e todas as métricas de violência e incitação.

- Para validar se nossas métricas estão sendo analisadas e reportadas corretamente, passaremos por uma auditoria pela EY no quarto trimestre deste ano, e os resultados serão divulgados na primavera de 2022.

Hoje, estamos publicando o nosso Relatório de Aplicação dos Padrões da Comunidade relativos ao terceiro trimestre de 2021. Este relatório fornece métricas sobre como aplicamos nossas políticas entre os meses de julho de 2021 e setembro de 2021. Com as novas adições, agora temos métricas em 14 diferentes políticas no Facebook e 12 no Instagram.

Também estamos compartilhando:

- O Relatório de conteúdo amplamente visualizado e o guia complementar para o terceiro trimestre de 2021

- O Relatório Trimestral do Oversight Board para o segundo e terceiro trimestres de 2021.

- Nossos outros relatórios de transparência para o primeiro semestre de 2021:

Em julho, compartilhamos nossa primeira atualização trimestral do Comitê de Supervisão, cobrindo o primeiro trimestre de 2021. Nessa atualização, estamos relatando os detalhes dos casos que encaminhamos ao Comitê, e atualizações sobre as nossas respostas às recomendações feitas junto com suas decisões nos casos. No futuro, incluiremos essas atualizações junto do Relatório de Aplicação dos Padrões da Comunidade.

Todos esses relatórios estão disponíveis na Central de Transparência.

Destaques do relatório

A prevalência de discurso de ódio no Facebook continuou a diminuir pelo quarto trimestre consecutivo. No terceiro trimestre, representou 0,03%, ou 3 visualizações de discurso de ódio a cada 10.000 visualizações de conteúdo, ante 0,05%, ou 5 visualizações de discurso de ódio a cada 10.000 visualizações de conteúdo no 2º trimestre. Continuamos observando uma redução na incitação ao ódio devido às melhorias em nossa tecnologia e às mudanças de classificação que personalizam o conteúdo no Feed de Notícias e reduzem o conteúdo problemático.

A prevalência de discurso de ódio no Instagram foi de 0,02% no terceiro trimestre, e esta é a primeira vez que reportamos esse número.

No terceiro trimestre, a prevalência de violência e incitação no Facebook foi de 0,04% – 0,05%, ou 4 a 5 visualizações a cada 10.000 visualizações de conteúdo, e foi de 0,02%, ou 2 visualizações a cada 10.000 visualizações de conteúdo, no Instagram. Removemos 13,6 milhões de conteúdos do Facebook por violar nossa política de violência e incitação, e detectamos, de forma proativa, 96,7% desse conteúdo antes que alguém denunciasse para nós. No Instagram, removemos 3,3 milhões de conteúdos com uma taxa de detecção proativa de 96,4%. . Há uma série de conteúdos que podemos remover de acordo com nossa política de violência e incitação, na qual alguém pode defender a violência ou fazer uma declaração com intenção violenta. De acordo com esta política, removeremos as instruções sobre como fazer ou usar armas, se houver evidências de que o objetivo é ferir gravemente as pessoas. Devido à natureza potencialmente prejudicial do conteúdo que tenta incitar a violência, indexamos em excesso a segurança e removemos esse conteúdo, mesmo que não esteja claro se o conteúdo é uma brincadeira. Isso pode variar de algo sério, como instruções sobre como usar armas para causar ferimentos, até uma piada em que um amigo diz ao outro: “Eu vou te matar!” Nos casos em que é necessário, também trabalhamos com as autoridades policiais quando acreditamos que existe um risco genuíno de danos físicos ou ameaças diretas à segurança pública.

No terceiro trimestre, a prevalência de conteúdo de bullying e assédio foi de 0,14% – 0,15% , ou 14 a 15 visualizações deste tipo de conteúdo a cada 10.000 visualizações no Facebook e 0,05 – 0,06% ou 5 a 6 visualizações a cada 10.000 visualizações no Instagram. Removemos 9,2 milhões de conteúdos de bullying e assédio no Facebook, com uma taxa proativa de 59,4%. E removemos 7,8 milhões de peças de conteúdo de bullying e assédio no Instagram com uma taxa proativa de 83,2%. O bullying e o assédio são desafios únicos, e uma das questões mais complexas a serem abordadas, porque o contexto é crítico. Você pode ler mais sobre nossa abordagem e esforços para reduzir a prevalência de bullying e assédio aqui.

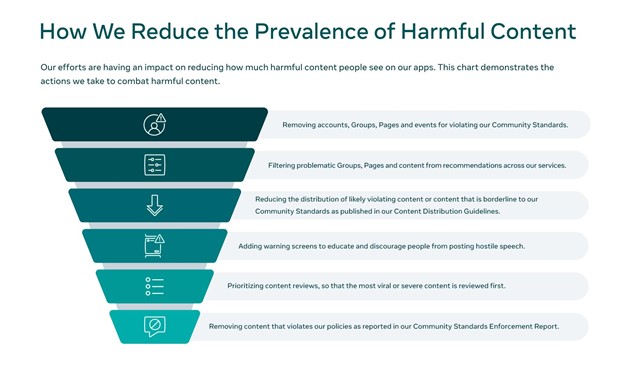

Como reduzimos o conteúdo prejudicial que as pessoas veem em nossos aplicativos

Dimensionamos a aplicação das nossas políticas para revisar milhões de conteúdos em todo o mundo, todos os dias, e cada vez mais usamos nossa tecnologia para ajudar a detectar e priorizar o conteúdo que precisa ser revisado. Temos equipes globais de revisão que conferem conteúdos em mais de 70 idiomas e tecnologia de IA para discursos de ódio em mais de 50 idiomas, e continuamos a desenvolver tecnologias como RIO, WPIE e XLM-R que podem nos ajudar a identificar conteúdo prejudicial com mais rapidez, em todos os idiomas e tipos de conteúdo (ou seja, texto, imagem, etc.). Esses esforços e nosso foco contínuo na pesquisa de IA ajudam nossa tecnologia a avançar rapidamente para manter nossas plataformas seguras. Para países que estão enfrentando ou estão em risco de conflito,realizamos investimentos plurianuais para formar equipes que trabalhem com as comunidades locais, que desenvolvam políticas, melhorem nossas tecnologias e respondam aos desenvolvimentos do mundo real.

Reduzimos a prevalência de conteúdo violador de várias maneiras, incluindo melhorias na detecção e aplicação, reduzindo o conteúdo problemático no Feed de Notícias e a distribuição de prováveis conteúdos violadores. Essas táticas nos permitiram reduzir a prevalência do discurso de ódio em mais da metade no Facebook só no ano passado, e estamos usando essas mesmas táticas em áreas de políticas como violência e incitação e bullying e assédio. Para lidar melhor com o discurso de ódio, bullying, assédio, violência e incitação – todos os quais exigem compreensão da linguagem, contexto e normas culturais – implementamos um novo sistema de inteligência artificial que consolida os aprendizados dos três tópicos para melhor abordar cada área de violação.

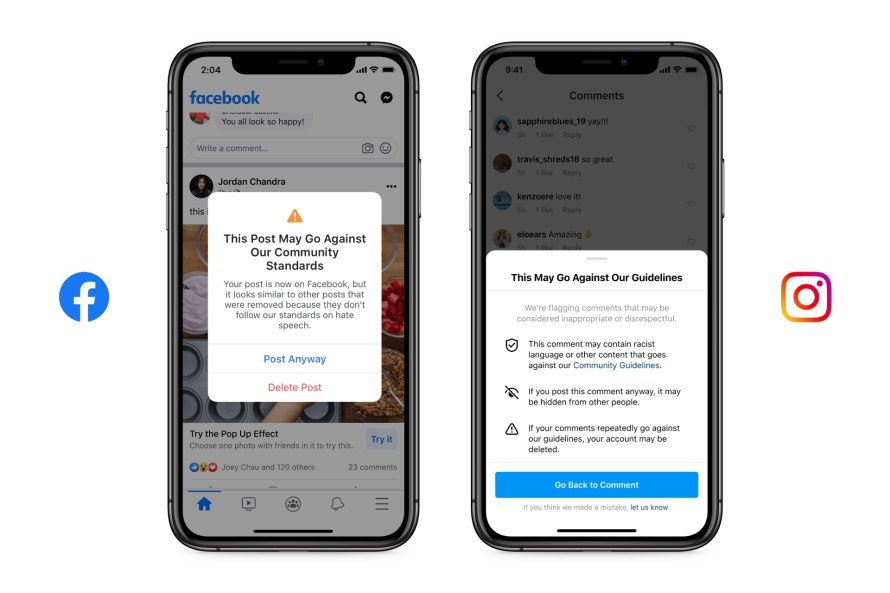

Também estamos usando telas de aviso para educar e desencorajar as pessoas a postar algo que possa incluir discurso hostil, como bullying e assédio, violando nossos Padrões ou Diretrizes da Comunidade. As telas aparecem depois que alguém realiza uma postagem ou um comentário explicando que o conteúdo pode violar nossas regras e pode ser ocultado ou apresentar distribuição reduzida. A postagem repetida deste conteúdo pode resultar na desativação ou exclusão de uma conta.

Olhando para o futuro

O abuso em nossos produtos não é estático – e nem a forma como realizamos nosso trabalho de integridade. Estamos constantemente trabalhando para melhorar. Continuamos a evoluir a forma como abordamos a integridade, unindo equipes de integridade e de produto no Facebook, Instagram, Messenger, WhatsApp com as equipes que construirão o metaverso nos próximos anos. As equipes de produto lidam com questões de integridade como parte da construção e lançamento de novos produtos, e isso inclui a construção do metaverso.

Também continuamos comprometidos com a pesquisa, e acabamos de lançar um programa de acesso antecipado de Facebook Open Research and Transparency (FORT) do Facebook para uma API projetada para pesquisadores acadêmicos, para dar-lhes mais acesso aos dados em nossas plataformas de forma segura.

Sabemos que nunca seremos perfeitos na detecção de cada conteúdo problemático. Mas estamos sempre trabalhando para melhorar, compartilhar dados mais significativos e continuar a tomar decisões com base em em pesquisas.