マイク・シュローファー(Mike Schroepfer)

2019年5月1日(米国時間)に開催されたFacebookの開発者カンファレンスF8 2019の2日目は、人工知能(AI)、拡張現実(AR)/仮想現実(VR)の分野における長期的な投資に焦点を当てました。基調講演では、Facebook最高技術責任者(CTO)のマイク・シュローファー(Mike Schroepfer)が、Facebookが提供する全てのサービス・製品におけるさまざまな課題に対処する為に使用しているAIツールについて話しました。

シュローファーの登壇に続き、Facebook AIチームのマノハール・プーリ(Manohar Paluri)、ホアキン・キンテーロ・カンデラ(Joaquin Quinonero Candela)、製品デザインのマーガレット・スチュワート(Margaret Stewart)、およびAR/VR部門のレイド・オバンメヒンティ(Lade Obamehinti)、リンジー・ヤング(Lindsay Young)、ロナルド・マレット(Ronald Mallet)らが講演を行いました。

人工知能(AI)

マノハール・プーリ(Manohar Paluri)

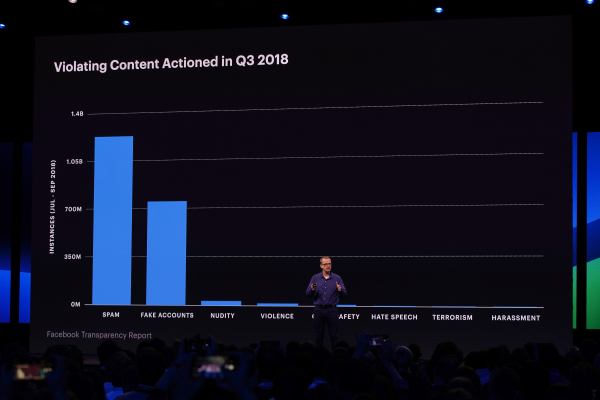

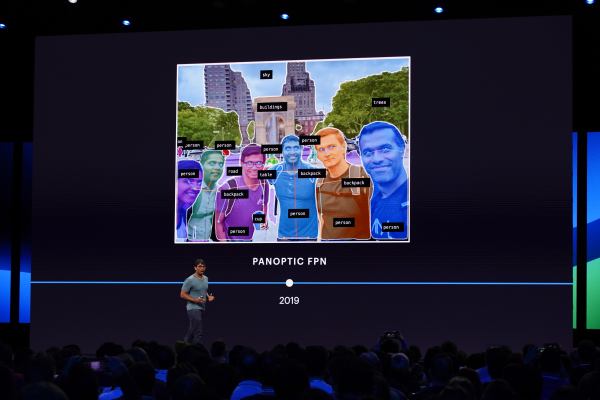

Facebookでは幅広い製品にAIを活用しており、近年は コミュニティ規定 に違反するコンテンツを検出する取り組みにも利用されています。問題のあるコンテンツをより多く検出できるように、人的介入を最小限にし、AIシステムが独自にコンテンツを判断できるように開発を進めています。 これまでに大きな進歩を遂げてきましたが、未だ初期段階であり開発途上であると認識しています。自然言語処理( NLP – Natural Language Processing )により、デジタル共通言語の翻訳を容易にし、より多くの言語にわたって有害なコンテンツを見つけ出すことができます。そしてオブジェクト認識の新たな手法である Panoptic FPN により、AI システムが写真の背景からコンテキストを理解できるようになりました。ビジュアル信号とオーディオ信号を組み合わせたトレーニングモデルは、さらなる改善に繋がります。

Panoptic FPNにより写真背景からコンテキストを理解

自然言語処理に関する取り組みは重要ですが、多くの技術は一般的な言語に対して最大限に機能します。その為、トレーニングに十分なサンプルを持たない多くの言語をサポートする方法が必要です。自己学習により、人的に新しい言語のデータセットを表示することなく、新しい言語のモデルをトレーニングすることができ、それぞれの文章を翻訳することなくポリシー違反などを含む関連コンテンツをより理解することができます。これらの技術は、すべての分類でこれまでよりも多くの言語間で、問題のあるコンテンツを検知することを確実にするものです。

ホアキン・キンテーロ・カンデラ(Joaquin Quinonero Candela)

AIは、私たちが提供するプラットフォームの安全性を保つのに役立ちますが、時にバイアスがかかるなど、リスクを伴うことも理解しています。AIは人々を差別するものではなく、人々を保護する為のものであることを保証するために、製品開発のあらゆる段階において、公平性を保つ最善の方法を実践しています。

AIモデルがデータセット上やトレーニングに人的介入を含む場合には、固有の表現リスクが存在します。データセットが、一定の制限、欠陥、または他の問題を含んでいる場合、生み出されるモデルの働き方は対象となる人によって異なる可能性があります。このリスクを管理するために、 包括的AIの新たなプロセス を開発しました。このプロセスは、研究者やプログラマーがデータセット設計や製品性能の測定、新しいシステムの試験をする際、包括的にサポートするためのガイドラインとなります。視覚で、肌の色や年齢、性別を認識し、音声では、方言や年齢、性別が認識されます。包括的なAIプロセスは、現在、Facebookの多くの製品チーム���わたって使用されており、新しい機能の開発に組み込まれています。

マーガレット・スチュワート(Margaret Stewart)

本日発表のAIに関するアップデートや進捗は、 AI blog (英語)をご確認ください。

拡張現実(AR)/仮想現実(VR)

レイド・オバンメヒンティ(Lade Obamehinti)

包括的AIプロセスを使用している分野の1つが、拡張現実(AR)です。 Spark AR のエンジニアは、このプロセスを使用することで、彼らが開発するソフトウェアに組み込まれるARエフェクトの品質を高めています。例えば、あるARエフェクトは、手の動きに反応する為、肌の色を含む様々なトレーニングデータがあらゆる照明条件下において、システム上でカメラに認識されるようになっています。同様に、Oculusのエンジニアも、方言や年齢、性別などの代表的なデータを、仮想現実(VR)の音声コマンドに使用しています。

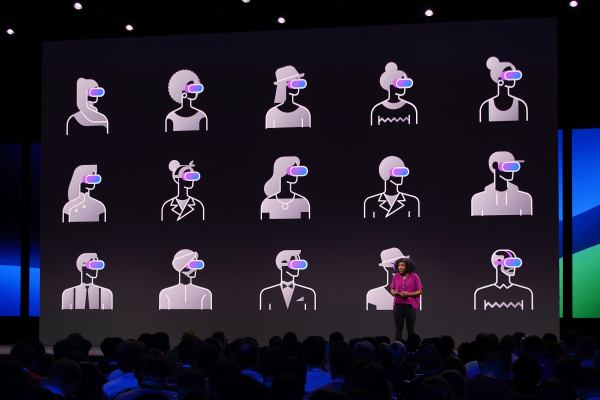

Facebookでは、テクノロジーが人を除外しないように、そして人と人を身近にする為にテクノロジーを活用できるようにしています。VRによって、将来的には物理的な距離を問わず、人々が交流し、VR空間内で集まることができると予測しています。しかしそのためには、VR空間内で完璧なプレゼンス(実際にそこにいるという感覚)を人々が感じられることが大切です。それを実現するには、動作、顔の表情、会話で生まれる自然な声のトーンなど、人間を忠実に再現したアバターが必要です。

以前、これまでよりもはるかに本人に近く、リアルタイムでの対話を可能にする コーデック・アバター(Codec Avatars) を紹介しました。しかし、本物のコミュニケーションの実現には、全身の動きを必要とします。そのため、限られたセンサーからのデータで3Dアバターを再現する、適応性のある物理ベースのモデルを開発しています。人間の生体構造を再現し、個人の外観や独自の動きを自動的に適応させることができる階層的アプローチを使用しています。モデルを内外から設計し、仮想スケルトンを開発、次いで、筋構造や肌、および衣服などを階層的に適応しました。その結果作成できたアバターは、筋肉の動きから服の着こなしまでを忠実に再現しています。この研究結果を製品に反映させるにはまだ時間を要しますが、良い方向に向かっていると言えます。

ロナルド・マレット(Ronald Mallet)

ARと同様に、人々に包括的かつ安全なVRを提供したいと考えています。そこで、ヘッドセットの利用者や開発者などすべての人に向けた行動規範など、互いを尊重し合った文化やつながりを促進する予防システムを構築しました。また、ガイドラインに違反している利用者を報告したりブロックするためのツールなどの対応システムも構築しました。

「Spaces」、「Venues」、「Rooms」など、自社のソーシャルVRアプリをリリースした際に、体験の中核となる設計に安全性を取り入れました。オリエンテーション動画では、VR空間にいる多数の人々とより快適に対話できるように設計された機能を紹介しています。例えば、パーソナルスペース安全確保機能は、自身が許可する範囲内に人や物体が近づくのを防ぐ機能です。仮にアバターの一人が別のアバターのパーソナルスペースに入ると、両者のアバターはお互いに見えなくなります。また、良好な空間を保ち、不適切な行動を報告すべく、ライブモデレータも設置しています。

リンジー・ヤング(Lindsay Young)

本日発表したツールやプロセスはすべて、今後の展開に向けた取り組みであり、世界中の人々に意見や機会をもたらすとともに、人と人とのつながりを支援するものです。

1日目の発表の詳細については、こちらのNewsroomポストを、本日の発表についての詳細は、 開発者ブログ (英語)、 AIブログ (英語)、 エンジニアブログ (英語)、 Oculusブログ (英語)、 Instagramプレスセンター (英語)でご覧いただけます。また、「F8」2018 全ての基調講演のビデオは Facebook for Developers からご覧いただけます。F8の基調講演は Facebook for Developersページ よりご覧ください。