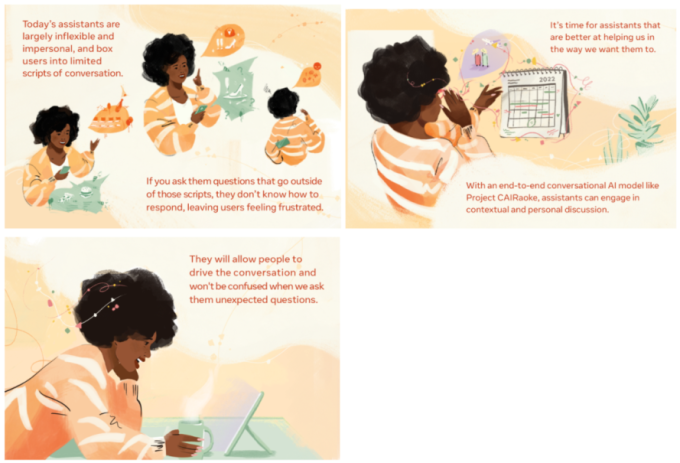

Pouvoir interagir avec un assistant virtuel intelligent dans un langage naturel et conversationnel, de la même manière que nous interagissons avec des personnes réelles, nous faciliterait la vie de bien des manières. Seulement, les assistants virtuels d’aujourd’hui ne sont souvent pas à la hauteur, que nous échangions à l’oral ou par écrit. Ils sont très vite déconcertés par des demandes du quotidien, telles que « Mets en sourdine toutes les notifications aujourd’hui, sauf si c’est ma mère qui appelle », ou encore « Est-ce que je peux louer la salle des fêtes pour organiser une soirée ? », sans parler de tâches comme « Organise des vacances à la plage pour notre famille pour le week-end du 4 juillet à un prix raisonnable ».

Il est donc grand temps d’améliorer l’IA conversationnelle.

Pour cela, nous avons le plaisir d’annoncer le projet CAIRaoke, par le biais duquel nous avons développé un modèle de bout en bout basé sur un réseau de neurones capable d’alimenter des conversations beaucoup plus personnelles et contextuelles que les systèmes utilisés jusqu’à présent. Nous utilisons déjà ce modèle issu du projet CAIRaoke dans l’un de nos produits, Portal, et nous visons à l’intégrer à des dispositifs de réalité augmentée et de réalité virtuelle afin de permettre prochainement des interactions immersives et multimodales avec des assistants virtuels.

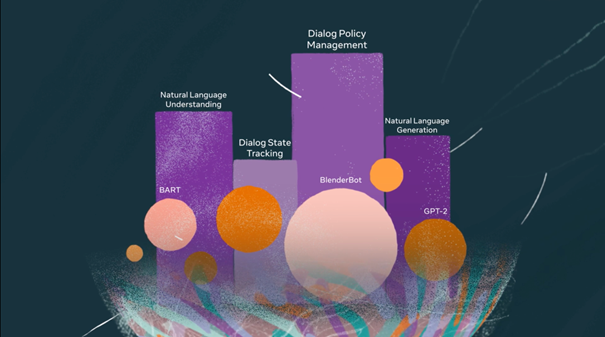

Le plus grand obstacle à une meilleure IA conversationnelle est, selon nous, l’architecture sur laquelle se basent les assistants virtuels d’aujourd’hui, même les plus avancés. En effet, bien que ces systèmes fournissent un service unique, ils reposent, en réalité, sur quatre composants distincts : la compréhension du langage naturel (natural language understanding, NLU), le suivi de l’état du dialogue (dialog state tracking, DST), la gestion des politiques de dialogue (dialog policy, DP) et la génération de langage naturel (natural language generation, NLG). Ces systèmes d’IA distincts doivent ensuite être reliés entre eux. Cela les rend difficiles à optimiser, peu adaptables à des tâches nouvelles ou inconnues et très dépendants d’ensembles de données étiquetés qui requièrent beaucoup de travail.

C’est l’une des raisons pour lesquelles aujourd’hui, les assistants virtuels qui alimentent la plupart des appareils, proposent des options limitées, oublient le contexte de la conversation et suivent principalement des dialogues prédéfinis. Par exemple, si, après avoir demandé la météo du jour à votre assistant virtuel, vous lui demandez quelque chose de simple mais d’inattendu, comme « Est-ce qu’il fait plus chaud que la semaine dernière ? », celui-ci sera complètement perdu.

Les modèles créés dans le cadre du projet CAIRaoke vous permettront de discuter avec vos assistants conversationnels de façon totalement naturelle. Vous pourrez ainsi vous référer à quelque chose qui a été dit plus tôt dans la conversation, changer complètement de sujet ou parler de choses qui dépendent d’un contexte complexe et nuancé. Vous pourrez également interagir avec eux de différentes manières, par exemple à l’aide de gestes.

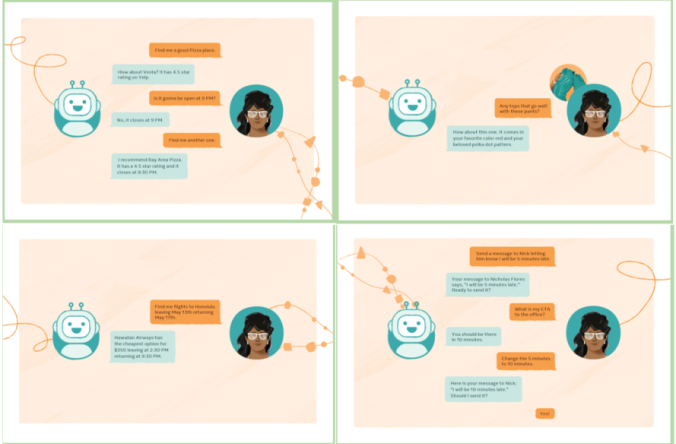

Nous avons commencé à utiliser ce modèle sur Portal, l’appareil d’appels vidéo de Meta, afin de faciliter la création et la gestion des rappels. Par exemple, vous pouvez rapidement clarifier une demande comme celle-ci sans avoir à vous répéter :

👩 : Définis un rappel pour 6h30.

: Le matin ou le soir ?

👩 : Le soir, et intitule-le « acheter des œufs »

: D’accord, un rappel pour acheter des œufs a été défini pour 18h30 demain.

Même s’il ne s’agit que du premier test, nous avons des raisons de croire que ce modèle est bien plus efficace que les approches standard. Sur Portal, en comparant notre approche classique à notre nouvelle approche, nous avons observé une amélioration importante de l’évaluation des rappels. Cette amélioration est mesurée par le taux de réussite de la réalisation d’un ensemble d’objectifs de rappels, tout en maintenant le même nombre de tours.

Mais il ne s’agit que de la première étape pour tirer pleinement parti de cette nouvelle technologie. Nous pensons que les progrès réalisés grâce au projet CAIRaoke permettront une communication plus riche entre les personnes et l’IA. Ce sera un outil essentiel pour le développement du métavers. Un jour, un assistant alimenté par le projet CAIRaoke pourra être intégré à des lunettes de réalité augmentée et remplir de nouvelles fonctions très utiles. Et si par exemple, vous lui demandiez : « Qu’est-ce qui va avec ce pantalon ? », il vous répondrait : « Voici un T-shirt dans votre couleur préférée, le rouge » et vous montrerait la photo d’un article qu’il a trouvé pour vous. Et si vous lui disiez : « Je l’aime bien, mais les rayures sont trop larges », il vous montrerait un modèle à rayures fines à la place.

À l’avenir, nous espérons que des millions de personnes dans le monde pourront tirer parti des modèles issus de ce projet dans des situations du quotidien comme celle décrite ci-dessus.

Développer une IA conversationnelle vraiment interactive

Pour faire progresser l’IA conversationnelle, il est important de comprendre toute l’étendue du problème. De nombreuses personnes pensent qu’avec les innovations récentes en compréhension du langage naturel, comme BART et GPT-3, le défi de comprendre et de générer un texte humain a été surmonté. Nous n’en sommes pas encore là : analysons séparément, par exemple, l’IA pour la compréhension et l’IA pour l’interaction. L’IA pour la compréhension a été largement étudiée et développée dans l’ensemble du secteur. Elle est utilisée pour extraire le sens de plusieurs modalités d’entrée, comme la reconnaissance automatique de la parole, la classification des images et la compréhension du langage naturel. L’IA pour l’interaction, quant à elle, repose sur la façon dont nous utilisons notre compréhension du monde pour interagir avec d’autres personnes à l’aide de la technologie. Il peut s’agir de l’envoi d’un SMS, d’une commande vocale, d’un retour haptique, de l’affichage d’une image, d’une vidéo, d’un avatar ou d’une combinaison de tout cela.

Les équipes de recherche et d’ingénierie du secteur s’accordent à dire que pour être efficaces, les systèmes conversationnels doivent disposer d’une base de compréhension solide alimentée par des modèles d’IA. Mais beaucoup pensent que l’interaction est un problème d’ingénierie plutôt qu’un problème d’IA. Par conséquent, un spécialiste en ingénierie qui connaît l’état du monde peut créer une logique complexe pour gérer l’interaction requise. L’approche d’ingénierie permet de comprendre facilement le fonctionnement du système et de débuguer rapidement la logique si nécessaire. Mais cela engendre une IA conversationnelle moins puissante, l’une des principales raisons pour lesquelles votre assistant virtuel ne vous permet pas de planifier vos vacances facilement, par exemple.

Une nouvelle approche unifiée

Dans ces exemples de dialogues, nous mettons en avant les principales compétences que nous voulons donner aux assistants : fournir des connaissances précises et à jour sur le monde réel et travailler de façon multimodale (dans ce cas, à travers la vision et la parole), dans plusieurs domaines (envoyer un message ou estimer votre heure d’arrivée) et en vous permettant d’orienter la conversation plutôt que de devoir suivre un modèle de conversation rigide.

L’approche traditionnelle concernant les assistants virtuels intelligents nécessite quatre ensembles d’entrées et de sorties, un par composant (compréhension du langage naturel, suivi de l’état du dialogue, gestion des politiques de dialogue et génération de langage naturel). Et des normes doivent être définies pour les entrées et les sorties de chaque composant. Par exemple, pour la compréhension du langage naturel, un système d’IA conversationnel traditionnel nécessite des ontologies définies (par exemple, plusieurs intentions et entités).

Le modèle du projet CAIRaoke utilise, lui, un réseau de neurones, et n’impose aucun flux conversationnel. En utilisant ce modèle, nous n’avons donc besoin que d’un seul ensemble de données d’entraînement.

Le projet CAIRaoke réduit les efforts requis pour ajouter un nouveau domaine. Dans l’ancienne approche, le développement d’un nouveau domaine oblige à créer et à corriger chaque module un par un avant de pouvoir entraîner le suivant de manière fiable. En d’autres termes, l’entraînement aux politiques de dialogue ne peut pas être effectué efficacement si la compréhension du langage naturel et le suivi de l’état du dialogue changent constamment. Des changements au niveau d’un composant peuvent perturber les autres, ce qui obligerait à entraîner à nouveau tous les modules suivants. Cette interdépendance ralentit la progression dans les modules suivants. Notre technique de bout en bout supprime cette dépendance aux modules précédents, ce qui accélère la vitesse de développement et d’entraînement et nous permet d’affiner d’autres modèles en utilisant moins d’efforts et de données.

Dans notre nouvelle approche, les dialogues sont beaucoup plus puissants, car ils sont capables de prendre des décisions en analysant toutes les informations disponibles en un seul et même endroit. Auparavant, même une petite erreur au niveau de l’un des composants pouvait se propager à d’autres composants de manière inattendue, et ce problème était difficile à résoudre. Par exemple, les assistants virtuels actuels basés sur des règles sont explicitement programmés pour rechercher des mots ou des phrases spécifiques (comme « après-midi »), alors que le projet CAIRaoke tire parti de modèles de langage pré-entraînés avancés qui comprennent mieux le contexte et peuvent reconnaître différentes façons de dire la même chose.

Enfin, le projet CAIRaoke allie la technologie qui sous-tend le bot conversationnel le plus récent de Meta, BlenderBot 2.0, à des dialogues axés sur les tâches. Les assistants virtuels développés à l’aide de notre modèle pourraient donc utiliser un langage empathique, transmettre des informations trouvées sur Internet en temps réel et avoir une personnalité cohérente.

Lorsque les systèmes génèrent un langage naturel, il est essentiel de tenir compte des défis potentiels en matière de sécurité et de confidentialité. La plupart des systèmes de génération de langage naturel d’aujourd’hui sont prédéfinis, afin que les équipes chargées de la modération du contenu puissent s’assurer que les assistants virtuels ne répondent pas de façon indésirable. Mais lorsque l’assistant virtuel est en contact direct avec une personne réelle, il existe un risque d’erreurs et d’interactions potentiellement blessantes, comme cela a déjà pu être constaté par le passé.

Notez que nous avons intégré des protections à BlenderBot afin de réduire ces cas de réponses blessantes. Nous tenons également compte de la confidentialité lors de la conception de ces technologies. Par exemple, avec les Ray-Ban Stories et Portal, l’utilisation des commandes vocales est facultative, vous pouvez donc afficher et supprimer les transcriptions de vos commandes vocales, et vous avez toujours la possibilité de désactiver leur stockage.

Pour atténuer le risque de réponses indésirables, la première étape du projet CAIRaoke était de générer à la fois des actions de dialogue et un langage naturel. À court terme, nous générons des actions de dialogue et nous nous appuyons sur un système de génération de langage naturel testé et très limité pour fournir la réponse attendue. À long terme, nous exposerons les phrases générées après avoir assuré l’intégrité de bout en bout de notre modèle.

Un autre problème que rencontrent également d’autres types de systèmes de traitement automatique du langage naturel est ce qu’on appelle l’hallucination, c’est-à-dire lorsqu’un modèle transmet des informations incorrectes avec assurance. Un véritable défi pour les techniques de bout en bout, car les modèles peuvent être incités à introduire ou à modifier des entités dans le dialogue en fonction des données d’entraînement. Par exemple, si vous demandez à votre assistant virtuel de vous rappeler d’appeler Monica, il pourrait configurer un rappel pour appeler Monique, car Monica est un prénom moins courant. Nous avons utilisé plusieurs techniques d’augmentation des données et réseaux d’attention pour renforcer le projet CAIRaoke, en tirant parti de ce que nous avons appris de BlenderBot 2.0 pour réduire les hallucinations.

Utiliser la voix pour de nombreuses tâches quotidiennes

Bien que notre mise en œuvre à court terme du modèle du projet CAIRaoke s’applique aux rappels sur Portal, nous espérons pouvoir bientôt l’utiliser dans de nombreux autres domaines, notamment afin de personnaliser les expériences d’achat, de permettre aux assistants virtuels de maintenir le contexte au fil des discussions et de donner au public le pouvoir d’orienter la conversation.

Nous pensons également que cette innovation sera particulièrement utile pour développer des fonctionnalités de dialogue basées sur l’IA pour la réalité augmentée. Dans un avenir plus ou moins proche, les personnes utiliseront régulièrement l’assistant vocal de leurs lunettes de réalité augmentée, comme elles le font aujourd’hui avec leurs enceintes intelligentes, leurs montres et d’autres appareils. Nous nous efforçons donc de réduire la taille des modèles de bout en bout comme celui-ci afin de les adapter à l’appareil, car ces modèles intégrés offrent des avantages supplémentaires en matière de sécurité, de confidentialité et de performance. Nous travaillons également à rendre le modèle plus facile à débuguer, ce qui représente un véritable défi, car dans ce nouveau cadre, les informations figurent dans l’espace d’intégration, alors que dans le modèle traditionnel, elles sont explicites. Pour concrétiser notre vision du projet CAIRaoke, nous devons également l’adapter à de nombreuses langues et trouver des moyens de rendre le modèle efficace pour des milliards de personnes.

Dans quelques années, la technologie du projet CAIRaoke pourra être la base de l’interaction nouvelle génération entre les personnes et les appareils. Sur des appareils tels que les casques de réalité virtuelle et les lunettes de réalité augmentée, nous nous attendons à ce que ce type de communication devienne la principale méthode de navigation et d’interaction, tout comme les écrans tactiles ont remplacé les claviers sur les smartphones. Notre modèle actuel est une innovation importante, mais nous avons encore beaucoup de travail pour concrétiser cette vision. Nous sommes très enthousiastes devant les progrès que nous avons réalisés jusqu’à présent et avons hâte de relever tous les défis à venir.