Guy Rosen, VP Integrity, Facebook

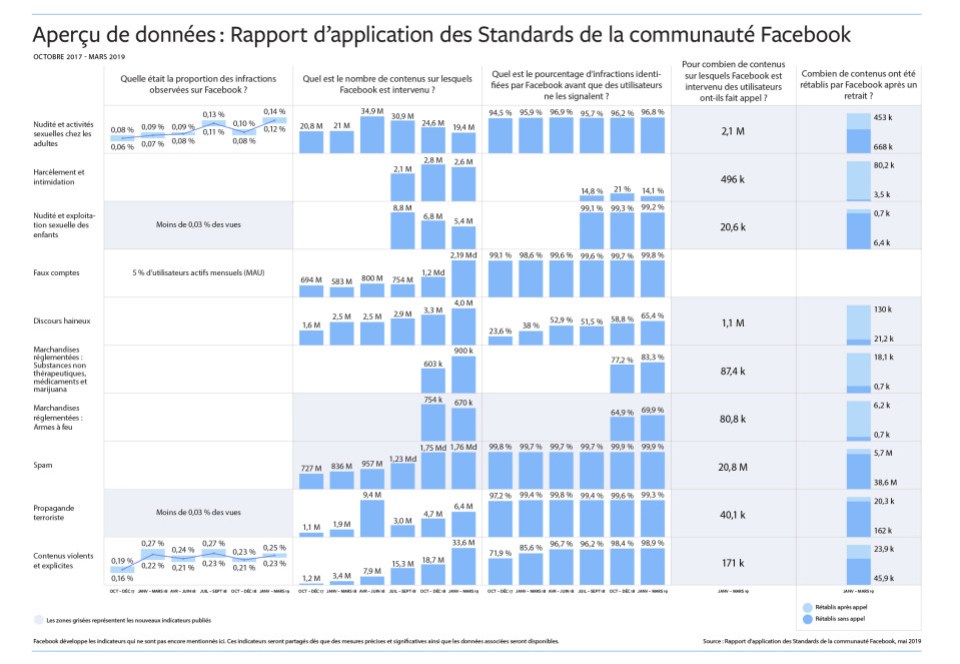

Nous publions aujourd’hui notre troisième rapport sur l’application de nos Standards de la communauté, qui couvre le quatrième trimestre 2018 et le premier trimestre 2019. Le présent rapport comprend quelques données supplémentaires :

Les nouveautés de cette troisième édition

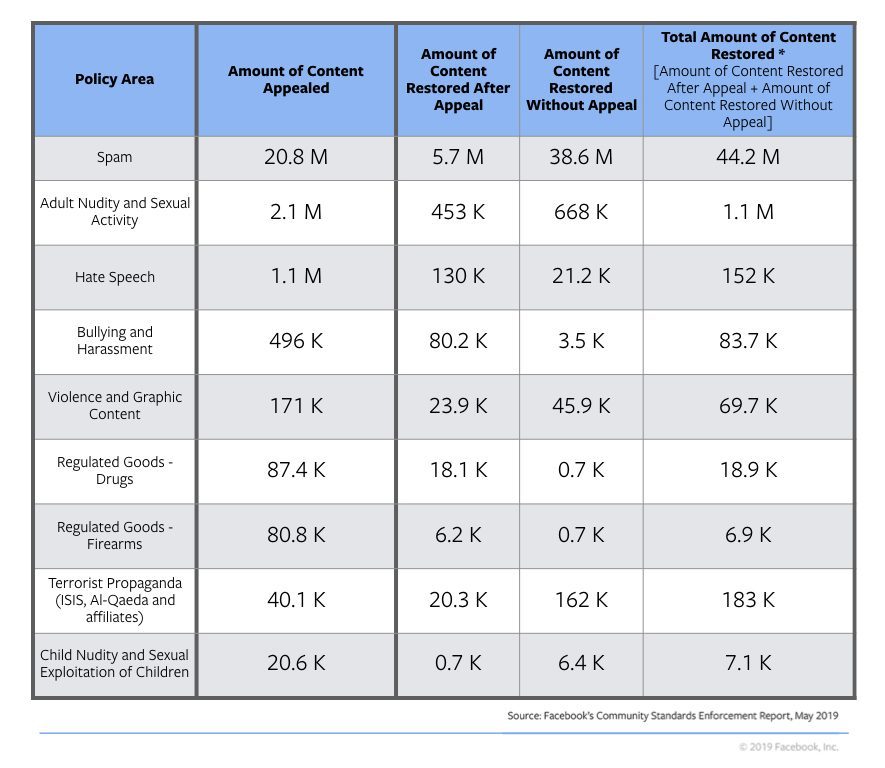

- Données sur les recours et les contenus rétablis : Pour la première fois, nous incluons le nombre de contenus ayant fait l’objet d’un recours et le nombre de ceux ayant été rétablis.

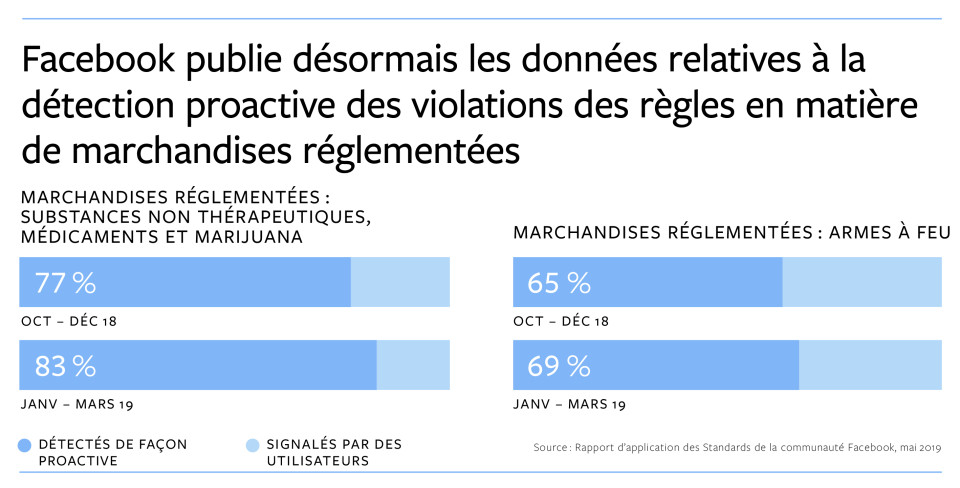

- Données sur les marchandises réglementées : En plus des huit catégories de règles abordées dans la deuxième édition du rapport (novembre 2018), nous apportons désormais des informations détaillées sur les retraits des tentatives de vente illicite de marchandises réglementées, spécifiquement les armes à feu et les substances non thérapeutiques, médicaments et marijuana.

Au total, nous incluons désormais des indicateurs pour neuf catégories de règles issues nos Standards de la communauté : nudité et activité sexuelle des adultes, intimidation et harcèlement, nudité et exploitation sexuelle d’enfants, faux comptes, discours haineux, marchandises réglementées, spams, propagande terroriste, et contenus violents et explicites.

Comment comprendre ces chiffres

Les principaux indicateurs de notre rapport, qui permettent le suivi de l’évolution de l’application de nos Standards de la communauté, sont les suivants :

Prévalence : la fréquence à laquelle un contenu qui enfreint nos Standards de la communauté a été vu. Nous nous soucions surtout de la fréquence à laquelle un contenu qui enfreint nos règles est réellement vu par quelqu’un. Alors que les contenus pour lesquels des mesures ont été prises correspondent au nombre d’éléments que nous avons supprimés, la prévalence correspond à ceux que nous n’avons pas encore identifiés et qui pourraient être vus. Pour mesurer la prévalence, nous échantillonnons périodiquement les contenus vus sur Facebook, puis nous les examinons pour savoir quel pourcentage de contenus va à l’encontre de nos Standards de la communauté.

La prévalence est actuellement disponible pour la nudité et l’activité sexuelle des adultes, les contenus violents et explicites et les faux comptes.

- Nous avons estimé que pour 10 000 contenus vus sur Facebook, 11 à 14 vues concernaient un contenu allant à l’encontre de nos règles en matière de nudité et d’activité sexuelle des adultes.

- Nous avons estimé que pour 10 000 contenus vus sur Facebook, 25 vues concernaient un contenu allant à l’encontre de nos règles en matière de contenus violents et explicites.

- En ce qui concerne les faux comptes, nous avons estimé que 5 % des comptes actifs mensuels sont des faux.

Dans ce rapport, nous partageons également pour la première fois un indicateur de prévalence pour la propagande terroriste et la nudité et l’exploitation sexuelle d’enfants. La prévalence dans ces deux catégories est trop faible pour être mesurée à l’aide de nos mécanismes standards, mais nous sommes en mesure d’estimer qu’au premier trimestre 2019, pour 10 000 contenus vus sur Facebook, moins de trois allaient à l’encontre de nos règles en la matière.

Nous continuons de développer des indicateurs de prévalence pour les catégories de règles comprises dans ce rapport. Vous pouvez en apprendre davantage sur la façon dont nous mesurons la prévalence ici.

Contenus pour lesquels des mesures ont été prises : quantité de contenus sur lesquels nous avons agi parce qu’ils allaient à l’encontre de nos Standards de la communauté. Nos actions comprennent la suppression du contenu, l’ajout d’un filtre d’avertissement ou encore la désactivation des comptes. Cet indicateur reflète la quantité de contenus publiés allant à l’encontre de nos règles, et dans quelle mesure nous pouvons les identifier.

En ce qui concerne les faux comptes, le nombre de comptes pour lesquels nous avons pris des mesures a augmenté en raison d’attaques automatisées d’acteurs malveillants qui tentent de créer un grand nombre de comptes en même temps. Nous avons ainsi désactivé 1,2 milliards de comptes au quatrième trimestre 2018 et 2,19 milliards au premier trimestre 2019. La plupart de ces comptes ont été bloqués quelques minutes après leur création, avant même qu’ils puissent être utilisés pour causer des préjudices, et ont été retirés si rapidement qu’ils n’ont jamais été considérés comme actifs. Nous continuerons de trouver d’autres moyens pour contrer ces tentatives qui violent nos règles. Notre Vice-Président Analytics, Alex Schultz, fournit plus de détails sur la manière dont nous traitons le sujet des faux comptes dans notre blog Hard Questions.

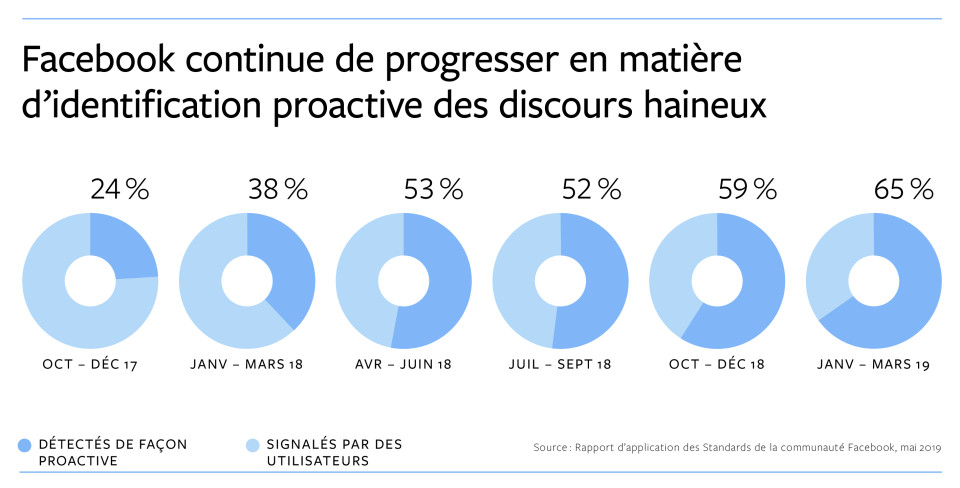

Taux de proactivité : le taux de contenus pour lesquels nous avons pris des mesures, avant même que quelqu’un ne nous les signale, grâce à la détection effectuée par nos systèmes. Cet indicateur reflète l’efficacité de l’intelligence artificielle dans une catégorie donnée de règles.

Dans six des catégories de règles comprises dans le présent rapport, nous avons détecté proactivement plus de 95 % des contenus pour lesquels nous avons pris des mesures, c’est-à-dire avant que quelqu’un ne nous les signale.

En ce qui concerne les discours haineux, nous détectons proactivement désormais 65 % des contenus que nous supprimons, contre 24 % il y a un peu plus d’un an, lorsque nous avons partagé nos efforts pour la première fois. Au premier trimestre 2019, nous avons supprimé 4 millions de publications comprenant un discours haineux, et nous continuons d’investir dans cette technologie et d’étendre nos capacités à détecter ce type de contenus dans différentes langues et régions.

Nouveautés du présent rapport : Recours et corrections de nos erreurs

Lorsque nous prenons des mesures à l’égard d’un contenu, nous en informons la personne qui l’a publié et, dans la plupart des cas, nous lui offrons la possibilité de nous dire si elle pense que nous avons commis une erreur. Dans la troisième édition de notre rapport, nous commençons à publier des données sur la quantité de contenus ayant fait l’objet d’un recours et sur la quantité de contenu ayant été rétablis.

L’application de nos règles n’est pas parfaite et, dès que nous identifions une erreur, nous nous efforçons de la corriger. C’est pourquoi nous incluons la quantité de contenus ayant été rétablis après avoir fait l’objet d’un recours, et la quantité de contenus que nous avons rétablis par nous-mêmes, même si le contenu n’a pas fait directement fait l’objet d’un recours. Nous pouvons rétablir un contenu sans qu’un recours ait été déposé pour plusieurs raisons, y compris :

- Lorsque nous avons fait une erreur en supprimant plusieurs publications du même contenu, nous pouvons utiliser le recours d’une personne contre notre décision pour rétablir toutes les publications.

- Parfois, nous identifions une erreur dans notre analyse et rétablissons le contenu avant que la personne l’ayant publié ne fasse appel.

- À d’autres moments, en particulier dans les cas de spams, lorsque nous supprimons des publications contenant des liens que nous identifions comme malveillants, nous pouvons rétablir ces publications si nous apprenons que ces liens ne sont plus dangereux.

Nous incluons ces informations pour le premier trimestre 2019 dans le rapport pour chaque catégorie de règles, à l’exception des faux comptes :

La quantité de contenus ayant fait l’objet d’un recours au cours d’un trimestre ne peut pas être directement comparée à la quantité de contenus rétablis au cours de ce trimestre, dans la mesure où les contenus rétablis au cours du premier trimestre 2019 peuvent avoir fait l’objet d’un recours au quatrième trimestre 2018. De la même manière, la quantité de contenus ayant fait l’objet d’un recours au premier trimestre 2019 pourrait avoir fait l’objet de mesures au quatrième trimestre 2018.

* Veuillez noter que la quantité de contenus rétablis suite à un recours et sans recours peut ne pas correspondre exactement à la quantité totale de contenus rétablis en raison des arrondis.

Pour en savoir plus sur le fonctionnement du processus permettant de déposer un recours cliquez ici.

Nouveautés du présent rapport : données sur les marchandises réglementées

Nous disposons depuis longtemps de règles contre la vente illicite d’armes à feu et de substances non thérapeutiques, de médicaments et de marijuana. Pendant des années, nous avons utilisé différentes approches pour faire appliquer notre politique, dont : l’examen des profils, des Pages, des groupes, des hashtags et des comptes associés aux contenus en infraction que nous avons déjà supprimés ; le blocage et le filtrage de centaines de termes associés à la vente de substances non thérapeutiques, de médicaments et de marijuana ; et le travail en collaboration avec des experts pour rester au courant des dernières tactiques que les malfaiteurs utilisent pour masquer leur activité, comme les nouveaux noms utilisés pour les substances non thérapeutiques, médicaments et marijuana.

Au cours de l’été 2018, nous avons commencé à utiliser l’intelligence artificielle pour identifier les contenus allant à l’encontre de nos politiques en matière de marchandises réglementées. Nous avons ainsi pu prendre des mesures sur une plus grande quantité de contenus et, dans la majorité des cas, avant même que ceux-ci nous soient signalés. Au premier trimestre 2019, nous avons pris des mesures à l’égard d’environ 900 000 contenus au sujet de la vente de substances non thérapeutiques, de médicaments et de marijuana, 83,3 % ayant été détectés de façon proactive. Au cours de la même période, nous avons pris des mesures à l’égard d’environ 670 000 contenus au sujet de la vente d’armes à feu, 69,9 % ayant été détectés de façon proactive.

En détectant les publications en infraction de façon plus proactive, cette technologie permet à notre équipe de se concentrer sur la détection des nouvelles méthodes par lesquelles les malfaiteurs tentent de tromper nos systèmes.

Notre engagement en matière de transparence

Depuis un an, nous avons pris un certain nombre de mesures pour être plus transparent dans notre façon d’élaborer nos Standards de la communauté et de mesurer nos efforts pour les appliquer. En ce qui concerne nos règles, nous avons commencé à partager les comptes rendus de notre réunion bimensuelle, à l’occasion de laquelle nous déterminons les mises à jour de nos Standards de la communauté. Nous publions désormais également un journal des changements chaque mois sur le site web de nos Standards de la communauté, afin que tout le monde puisse voir exactement à quels niveaux nous avons apporté des modifications à nos standards. De plus, dans le cadre de nos efforts pour soutenir la recherche, nous accordons des subventions à 19 projets de recherche dans le monde entier pour étudier nos règles et la façon dont les contenus en ligne influencent les événements hors ligne.

Les examens externes indépendants et les contributions externes font partie intégrante de la façon dont nous nous améliorons. Dans cet esprit, nous avons mis en place le Data Transparency Advisory Group (DTAG), afin de proposer une évaluation indépendante et publique de la pertinence et de l’exactitude des indicateurs que nous partageons dans notre rapport sur l’application de nos Standards de la communauté. Cet organisme indépendant, composé d’experts internationaux en statistiques, criminologie et gouvernance, évalue notre méthodologie. Nous avons fourni au DTAG des informations détaillées et confidentielles sur nos processus d’application et nos méthodologies de mesure et, cette semaine, ce dernier a publié son évaluation indépendante. Dans son évaluation, le DTAG indique que notre rapport sur l’application de nos Standards de la communauté est un exercice de transparence important et que notre approche et notre méthodologie sont à la fois solides et raisonnables. Le DTAG souligne également d’autres catégories dans lesquelles nous pourrions être plus transparents afin d’accroître notre responsabilisation et notre réceptivité envers les personnes qui utilisent notre plate-forme. Ces informations importantes nous guideront dans la réalisation de nos futurs projets.

Nous continuerons d’apporter plus de transparence à notre travail et d’inclure plus d’informations concernant nos efforts afin que tout le monde puisse voir nos progrès et nous indiquer les mesures que nous devons prendre pour progresser davantage.