La deuxième journée du F8 s’est focalisée sur les investissements à long terme que nous faisons dans les domaines de l’IA et de la réalité augmentée et virtuelle (AR/VR). Dans son discours d’ouverture, Mike Schroepfer, Chief Technology Officer, a parlé des outils d’intelligence artificielle que nous utilisons pour relever de nombreux défis à travers l’ensemble de nos produits, ainsi que les raisons pour lesquelles il est optimiste quant au futur.

Schroepfer a ensuite donné la parole à Manohar Paluri et Joaquin Quinonero Candela, de l’équipe Facebook IA, à Margaret Stewart, de l’équipe en charge de la conception des produits, et à Lade Obamehinti, Lindsay Young et Ronald Mallet, de l’équipe de réalité augmentée et de réalité virtuelle.

Intelligence artificielle

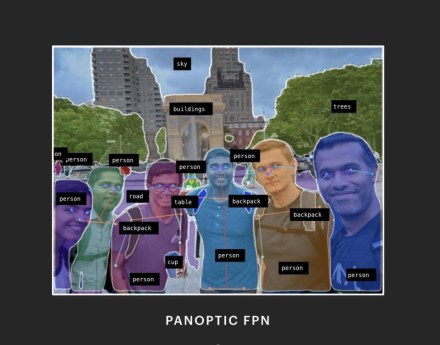

L’IA alimente un large spectre de produits et d’infrastructures au sein de Facebook. Ces dernières années, cela s’est étendu à nos efforts pour détecter de façon proactive les contenus qui violent nos Standards de la Communauté. Pour nous aider à identifier de plus en plus de ce contenu problématique, nous nous efforçons de nous assurer que nous systèmes d’IA comprennent le contenu avec le moins de supervision humaine possible. Et nous avons fait d’importants progrès. Nos avancées en traitement automatique du langage naturel (NLP) nous ont aidées à créer un langage numérique commun pour traduire les contenus préjudiciables, afin qu’ils puissent être pris en compte dans davantage de langues. Et une nouvelle approche de la reconnaissance d’objets appelée FPN panoptique a aidé nos systèmes alimentés par l’intelligence artificielle à comprendre le contexte à partir de l’arrière-plan des photos.

Légende : Des technologies comme le FPN Panoptic, montré ici, aident les systèmes basés sur l’intelligence artificielle à comprendre le contexte à partir des arrière-plans des photos.

Notre travail autour du traitement du langage naturel est important, mais de nombreuses techniques fonctionnent mieux avec les langues les plus parlées. Nous avons également besoin de trouver un moyen de tenir compte des nombreuses langues pour lesquelles nous ne disposons pas de suffisamment d’exemples sur lesquels s’entraîner. L’apprentissage auto-supervisé peut être utile, puisque nous sommes capables d’entraîner des modèles sans avoir besoin d’immenses set de données labellisés par des humains. Ces techniques permettent de s’assurer que tous nos classificateurs captent le contenu problématique dans un plus grand nombre de langues qu’auparavant. Cela nous permet de mieux comprendre les contenus pertinents – y compris les violations de nos Standards de la Communauté – sans avoir à traduire chaque phrase.

Si l’intelligence artificielle est essentielle pour assurer la sûreté de notre plateforme, nous savons qu’elle comporte des risques. Elle peut refléter et amplifier des biais. Pour remédier à ce problème, nous élaborons des bonnes pratiques en matière d’équité pour veiller à ce que l’IA protège les gens et ne soit pas discriminante, et ce à chaque étape du développement des produits.

Lorsque les modèles d’IA sont entraînés par des humains sur des ensembles de données impliquant des personnes, il y a un enjeu inhérent de représentativité. Si les ensembles de données sont limités, contiennent des défauts ou d’autres problèmes, les modèles résultants peuvent fonctionner différemment pour des personnes différentes. Pour pallier ce risque, nous avons élaboré un nouveau cadre pour une IA inclusive. Ce cadre fournit des lignes directrices pour aider les chercheurs et les programmeurs à concevoir des ensembles de données, à mesurer la performance des produits et à mettre à l’essai de nouveaux systèmes dans une optique d’inclusivité. Pour la vision, ces dimensions comprennent la couleur de la peau, l’âge et le sexe, et pour la voix, elles comprennent le dialecte, l’âge et le sexe. Ce cadre d’intelligence artificielle inclusive est maintenant utilisé par de nombreuses équipes produits chez Facebook et a été intégré dans le développement de nouvelles fonctionnalités.

Pour en savoir plus sur les mises à jour et les progrès de l’IA d’aujourd’hui, vous pouvez consulter les articles sur notre blog d’IA.

Réalité virtuelle et réalité augmentée (AR/VR)

L’un des domaines dans lesquels nous utilisons le cadre d’IA inclusive est la réalité augmentée (AR). Les ingénieurs de Spark AR l’utilisent pour s’assurer que leur logiciel fournit des effets de réalité augmentée de qualité pour tous. Par exemple, certains des effets sont déclenchés par un geste de la main, de sorte que les données d’entraînement comprennent diverses couleurs de peau dans diverses conditions d’éclairage, pour que le système puisse toujours reconnaître qu’il y a une main devant l’appareil. Les ingénieurs d’Oculus utilisent également ce processus pour les commandes vocales en réalité virtuelle (VR), en utilisant des données représentatives dess dialectes, des âges et des sexes.

Tout en veillant à ce que notre technologie n’exclue pas les gens, nous nous efforçons également de faire en sorte qu’elle contribue à les rapprocher. Avec la réalité virtuelle, nous envisageons un avenir dans lequel les gens pourront interagir et se rassembler quelle que soit la distance qui les sépare. Mais pour y parvenir, les gens doivent se sentir complètement présents dans la VR. Et cela signifie que nous avons besoin d’avatars vraiment réalistes, avec des gestes, des expressions faciales et un ton de voix qui ajoutent de la nuance à nos conversations.

Nous avons fait preuve d’un réalisme innovant avec nos avatars Codec, qui permettent aux gens d’interagir en temps réel en VR. Toutefois, une véritable communication requiert le corps entier. C’est pourquoi nous développons des modèles entièrement adaptatifs, basés sur les lois physiques, qui reproduisent un avatar 3D avec les données d’un nombre limité de capteurs. Nous utilisons une approche par couches qui reproduit l’anatomie humaine et peut s’adapter automatiquement pour parfaitement correspondre à l’apparence et au mouvement uniques de chaque individu. Nous concevons ces modèles à partir de l’intérieur, en développant un squelette virtuel puis en superposant la structure musculaire, la peau et les vêtements. Il en résulte des avatars réalistes jusque dans les mouvements musculaires et le drapage des vêtements. Il nous reste encore beaucoup de chemin à parcourir avant que cette recherche aboutisse à un produit, mais les résultats obtenus jusqu’à présent nous encouragent à persévérer.

Comme pour la réalité augmentée, nous voulons que la réalité virtuelle soit inclusive et sûre pour tous. Nous avons mis en place des systèmes préventifs – comme un code de conduite pour tous ceux qui utilisent ou construisent nos casques – qui favorisent une culture et des interactions respectueuses. Nous avons également construit des systèmes réactifs – y compris des outils pour signaler ou bloquer les utilisateurs qui enfreignent les standards.

Lorsque nous avons lancé nos propres applications sociales de réalité virtuelle, y compris Spaces, Venues et Rooms, nous avons intégré la sécurité dans la conception de base de l’expérience. Une vidéo d’orientation présente aux gens certaines des fonctionnalités pour qu’ils se sentent plus à l’aise d’interagir avec un grand groupe de personnes pendant leur expérience en réalité virtuelle. Par exemple, la bulle de sécurité est une fonctionnalité qui empêche les personnes ou les objets de s’approcher plus près de vous que vous ne le souhaiteriez. Si un avatar entre dans la bulle de sécurité de l’autre, les deux avatars deviennent invisibles l’un pour l’autre. Nous avons également des modérateurs disponibles en direct pour aider à assurer un comportement correct et à examiner les signalements de comportements inappropriés.

Les outils et les cadres que nous avons partagés aujourd’hui font tous partie de la façon dont nous nous préparons à la suite. Pour nous, ce travail consiste à donner une voix et des chances égales à tout le monde et à aider les gens à rester en contact les uns avec les autres. Pour en savoir plus sur les annonces d’hier, lisez notre bilan de la première journée. Pour plus de détails sur les nouvelles d’aujourd’hui, consultez nos blogs de développeurs, d’IA, d’ingénierie, Oculus, le centre presse Instagram, et la Newsroom. Vous pouvez également regarder toutes les conférences F8 sur la page Facebook pour les développeurs.