A menudo nos preguntan cómo decidimos qué está permitido en Facebook y cuánto contenido inapropiado existe. Durante años, las Normas comunitarias, en las que se explica qué contenido está permitido y cuál no, nos han ayudado a responder a la primera pregunta. Hace tres semanas publicamos por primera vez las directrices internas que utilizamos para garantizar que se cumplan dichas normas y hoy presentamos nuestro Informe de cumplimiento de las Normas comunitarias, en el que se incluyen distintas estadísticas con el fin de que todo el mundo pueda juzgar nuestro rendimiento por sí mismo.

En esta publicación de la serie “Preguntas comprometidas» y en la guía para comprender el informe de cumplimiento de las Normas comunitarias, Alex Schultz, vicepresidente de análisis de datos, explica con más detalle nuestra forma de medir exactamente qué ocurre en Facebook. Sin embargo, es importante recalcar que todavía estamos trabajando en estos procesos y que probablemente iremos cambiando nuestra metodología a medida que vayamos descubriendo qué es lo más relevante y qué proporciona mejores resultados.

En este informe explicamos nuestros esfuerzos para garantizar el cumplimiento de las normas entre octubre de 2017 y marzo de 2018. En él se analizan seis temas: violencia gráfica, desnudos de adultos y actividad sexual, propaganda terrorista, lenguaje que incita al odio, spam y cuentas falsas. Las estadísticas proporcionan información sobre los siguientes aspectos:

- cuánto contenido que infringe nuestras normas han visto las personas,

- cuánto contenido hemos eliminado,

- cuánto contenido hemos detectado de forma proactiva gracias a nuestra tecnología (antes de que los usuarios de Facebook lo denunciaran).

La mayoría de las acciones que llevamos a cabo para eliminar el contenido inapropiado están relacionadas con las cuentas falsas y la gran cantidad de spam que generan. Por ejemplo:

La mayoría de las acciones que llevamos a cabo para eliminar el contenido inapropiado están relacionadas con las cuentas falsas y la gran cantidad de spam que generan. Por ejemplo:

- Retiramos 837 millones de publicaciones consideradas spam durante el primer trimestre de 2018; casi todas ellas se encontraron y procesaron antes de que alguien las denunciara.

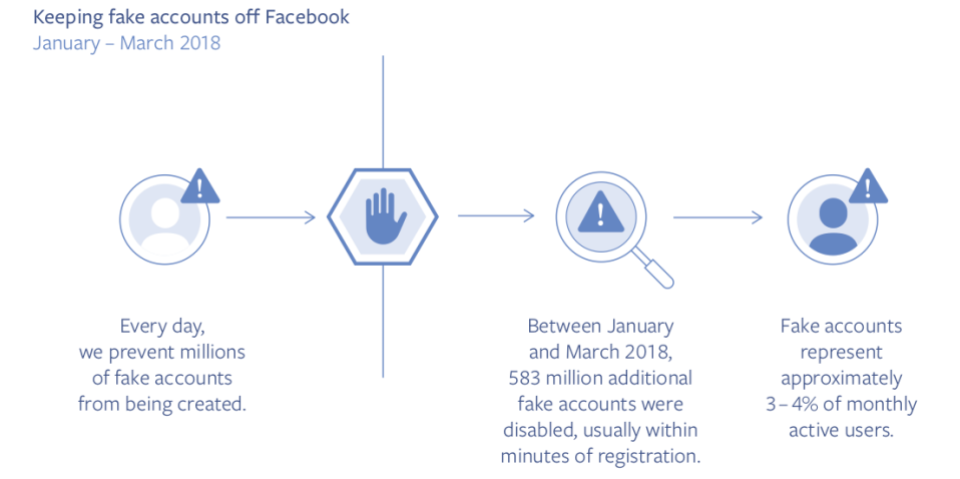

- La clave para enfrentarse al spam es retirar las cuentas falsas que lo difunden. Durante el primer trimestre, desactivamos aproximadamente 583 millones de cuentas falsas, la mayoría, tan solo unos minutos después de su creación. A esta cifra hay que sumarle los millones de cuentas falsas que evitamos que se creen a diario en Facebook. En general, estimamos que, durante este periodo, quedaban aproximadamente entre un 3 y un 4 % de cuentas activas falsas en la plataforma.

En relación con otros tipos de contenido que infringen las normas:

- Eliminamos 21 millones de publicaciones que contenían desnudos o pornografía de adultos durante el primer trimestre de 2018, el 96 % de las cuales se encontraron y procesaron antes de que alguien las denunciara. A pesar de esto, estimamos que, en general, de cada 10 000 publicaciones visualizadas en Facebook, entre siete y nueve infringían nuestras normas relativas a los desnudos o la pornografía de adultos y aún permanecían en la plataforma.

- En cuanto a problemas serios como la violencia gráfica y el lenguaje que incita al odio, nuestra tecnología aún no es lo suficientemente eficaz, por lo que nuestros equipos de revisión se encargan de ellos. Durante el primer trimestre de 2018, retiramos unos 3,5 millones de publicaciones relacionadas con contenido violento o les aplicamos etiquetas de advertencia. Nuestra tecnología identificó el 86 % de ellas antes de que alguien las denunciara a Facebook. También eliminamos 2,5 millones de publicaciones relacionadas con el lenguaje que incita al odio durante este mismo trimestre. Nuestra tecnología fue capaz de detectar un 38 % de dichas publicaciones.

Tal y como afirmó Mark durante la Conferencia F8, todavía nos queda mucho trabajo por hacer para evitar las situaciones de abuso. Parte del motivo se debe a que las tecnologías como la inteligencia artificial, si bien son prometedoras, todavía están muy lejos de ser efectivas para la mayoría de los casos de contenido inapropiado, porque el contexto juega un papel muy importante. Por ejemplo, la inteligencia artificial todavía no puede concretar si alguien está incitando al odio o está describiendo una situación que le ha ocurrido para dar a conocer un problema. Además, tal y como expliqué la semana pasada, la tecnología necesita una gran cantidad de datos para asimilar y reconocer patrones significativos de comportamiento, pero normalmente no disponemos de ellos en el caso de idiomas menos usados o de situaciones que no suelen denunciarse. Asimismo, en muchos aspectos (ya sea spam, pornografía o cuentas falsas), nos enfrentamos a unos adversarios muy sofisticados que cambian de método constantemente para eludir nuestros controles, así que debemos desarrollar y adaptar nuestras estrategias de forma continua. Es por este motivo que invertimos enormemente en disponer de más personal y de una tecnología mejor para hacer que Facebook sea un lugar seguro para todos.

Esta también es la razón por la que publicamos esta información. Creemos que, si fomentamos la transparencia, con el tiempo también se promoverá la responsabilidad. Además, la publicación de esta información nos hará mejorar de forma más rápida. Estos son los mismos datos que utilizamos para medir nuestro progreso de forma interna. Ahora todo el mundo puede verlos para juzgar nuestro progreso por sí mismo. Esperamos vuestros comentarios.