Hoje estamos compartilhando destaques do nosso trabalho de integridade no segundo trimestre de 2022. O material completo pode ser encontrado na Central de Transparência. Esta atualização inclui:

- O Relatório de Aplicação dos Padrões da Comunidade do segundo trimestre de 2022;

- O Relatório de Conteúdo Amplamente Visualizado do segundo trimestre de 2022;

- O Relatório Trimestral do Comitê de Supervisão do segundo trimestre de 2022;

- Atualizações sobre nosso trabalho para proteger a segurança e a expressão; e

- Novos dados sobre nosso programa independente de verificação de fatos.

No início deste mês também divulgamos nosso Relatório Trimestral de Ameaças, que fornece uma visão profunda e qualitativa dos diferentes tipos de ameaças que enfrentamos globalmente, bem como nossa abordagem para as próximas eleições no Brasil e nos Estados Unidos.

Destaques do Relatório de Aplicação dos Padrões da Comunidade

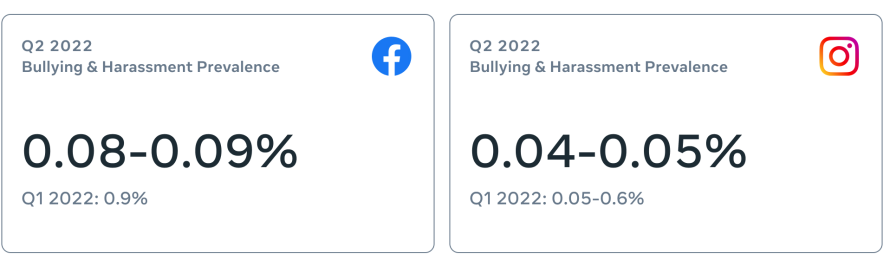

Continuamos a fazer progresso constante em várias áreas, incluindo bullying e assédio. À medida que continuamos a aperfeiçoar nossa tecnologia de IA, a taxa de detecção proativa de conteúdo relacionado a bullying e assédio no Facebook aumentou de 67% no primeiro trimestre de 2022 para 76,8% no segundo trimestre de 2022, e no Instagram de 83,8% no primeiro trimestre de 2022 para 87,4% no segundo trimestre de 2022.

No Facebook, no segundo trimestre de 2022:

- Bullying e assédio: A prevalência foi de 0,08-0,09%, ante 0,09% no primeiro trimestre. Aplicamos medidas em 8,2 milhões de peças de conteúdo no segundo trimestre, ante 9,5 milhões no primeiro trimestre.

- Discurso de ódio: A prevalência permaneceu em 0,02%, ou 2 visualizações a cada 10 mil. Aplicamos medidas em 13,5 milhões de peças de conteúdo no segundo trimestre, ante 15,1 milhões no primeiro trimestre.

- Violência e incitação: A prevalência permaneceu em 0,03%, ou 3 visualizações a cada 10 mil. Aplicamos medidas em 19,3 milhões de peças de conteúdo no segundo trimestre, ante 21,7 milhões no primeiro trimestre.

No Instagram, no segundo trimestre de 2022:

- Bullying e assédio: A prevalência foi de 0,04-0,05%, ante 0,05-0,6% no primeiro trimestre. Aplicamos medidas em 6,1 milhões de peças de conteúdo, ante 7 milhões no primeiro trimestre.

- Discurso de ódio: A prevalência foi de 0,01-0,02% ou 1 a 2 visualizações a cada 10 mil, ante 0,02% no primeiro trimestre. Aplicamos medidas em 3,8 milhões de peças de conteúdo no segundo trimestre, ante 3,4 milhões no primeiro trimestre.

- Violência e incitação: A prevalência permaneceu em 0,01-0,02%, ou 2 visualizações a cada 10 mil. Aplicamos medidas em 3,7 milhões de peças de conteúdo no segundo trimestre, ante 2,7 milhões no primeiro trimestre.

Como parte de nosso trabalho para melhorar constantemente as métricas que compartilhamos neste relatório, atualizamos nossa metodologia de apelação para considerar todas as instâncias em que o conteúdo foi enviado para análise adicional, incluindo momentos em que as pessoas nos disseram que discordavam da nossa decisão.

À medida que novas regulações continuam a ser implementadas ao redor do mundo, estamos focados nas obrigações que elas criam e como essas obrigações podem afetar nossa capacidade de manter baixa a prevalência de conteúdo violador em nossos aplicativos, minimizar erros de aplicação de medidas e conduzir uma diligência como parte de nossos processos de segurança e proteção.

Destaques do Comitê de Supervisão

Expansão do escopo do Comitê: O Comitê emitirá em breve um novo tipo de julgamento vinculante sobre os casos: se devemos ou não aplicar uma tela de aviso a algumas peças de conteúdo. Embora o Comitê já tenha sido capaz de aplicar decisões vinculantes sobre a remoção ou manutenção de peças de conteúdo, esta expansão irá os empoderar ainda mais, dando-lhes mais subsídios sobre como o conteúdo aparece e é distribuído às pessoas em nossas plataformas.

Relevância noticiosa: Como resultado de uma recomendação do Comitê de Supervisão, estamos divulgando dados sobre o número de exceções relacionadas à relevância noticiosa que abrimos ao longo de um ano. Estamos nos comprometendo a divulgar esses números periodicamente, daqui em diante. De junho de 2021 a junho de 2022, documentamos 68 exceções relacionadas à relevância noticiosa, das quais 13 (~20%) foram emitidas para publicações de políticos. Estes dados, juntamente com exemplos e detalhes sobre estas concessões, estão agora disponíveis em nossa Central de Transparência.

Protocolo de Política de Crise: Durante as crises, avaliamos os riscos de danos iminentes dentro e fora das nossas plataformas e respondemos com ações específicas, como políticas e produtos. Com base em uma recomendação do Comitê de Supervisão — e para fortalecer nosso trabalho existente — estamos publicando um Protocolo de Política de Crise (PPC) para codificar nossas respostas a crises que envolvem políticas de conteúdo. Esta estrutura ajuda a avaliar situações de crise que podem exigir uma nova ou única resposta de política. O PPC orientará nosso uso de intervenções de políticas de crise direcionadas de maneira oportuna, consistente com os riscos observados e com intervenções anteriores. Como resultado, isto ajudará nossa resposta de política de crise a ser mais calibrada e sustentável, pois procuramos equilibrar uma resposta global consistente adaptada a condições que mudam rapidamente. O desenvolvimento do protocolo incluiu pesquisas originais, consultas com mais de 50 especialistas externos globais em segurança nacional, prevenção de conflitos, discurso do ódio, resposta humanitária e direitos humanos. Saiba mais aqui e aqui.

Empoderando a expressão e protegendo a segurança

Estamos sempre refinando nossas políticas e nossa aplicação de medidas para que ambos apoiem a capacidade das pessoas de se expressarem e para criar um ambiente seguro nas nossas plataformas. Sabemos que nem sempre acertamos, e estamos procurando maneiras de melhorar nossa aplicação proativa, como por meio da tecnologia de IA.

Descobrimos que o uso de telas de aviso para desencorajar o discurso de ódio ou o conteúdo de bullying e assédio preveniu parte desse conteúdo —que poderia ter violado nossos Padrões da Comunidade — de ser publicado.

Também estamos expandindo o teste Sinalizado pelo Facebook, que permite que alguns administradores de Grupos moldem melhor a cultura desses grupos e levem em consideração o contexto, mantendo alguns conteúdos em seus Grupos que poderiam ser sinalizados como bullying e assédio. Por exemplo, através deste teste, um administrador de um grupo de entusiastas de tanques de peixes permitiu um comentário sinalizado que chamou um peixe de “gordo”, no qual não havia a intenção de ser ofensivo.

Verificação de fatos e comentários úteis

Construímos a maior rede global de verificação de fatos de qualquer plataforma, com mais de 90 parceiros de verificação de fatos em todo o mundo que analisam e classificam desinformação viral.

No segundo trimestre, exibimos avisos em mais de 200 milhões de conteúdos distintos no Facebook (incluindo compartilhamentos) globalmente com base em mais de 130 mil artigos escritos por nossos parceiros de verificação de fatos.

Nos EUA, temos parceria com 10 organizações de verificação de fatos, cinco das quais cobrem conteúdo em espanhol. Estamos incluindo a TelevisaUnivision como mais um parceiro nos Estados Unidos para verificar conteúdo em espanhol.

Também lançamos um programa piloto no Facebook que visa mostrar às pessoas informações mais confiáveis e empoderá-las para decidir o que ler, confiar e compartilhar. Um pequeno grupo de nossos parceiros de verificação de fatos independentes nos EUA poderá deixar comentários em inglês e espanhol para fornecer mais informações em publicações públicas no Facebook que eles determinarem que se beneficiariam de mais contexto. Este esforço é separado do nosso programa de verificação de fatos independente. Os comentários não são classificações de checagem de fatos. Eles não resultarão em nenhuma penalidade para os criadores do conteúdo, nem impactarão na distribuição de uma publicação ou o status geral de uma Página. Além disso, ao contrário da verificação de fatos, esses comentários aparecerão em publicações do Facebook que podem não ser comprovadamente falsas, mas que as pessoas podem achar enganosos.