- Acreditamos que focar em prevalência, a quantidade de discurso de ódio que as pessoas realmente veem em nossas plataformas, e como a reduzimos usando todas as nossas ferramentas, é a métrica mais importante.

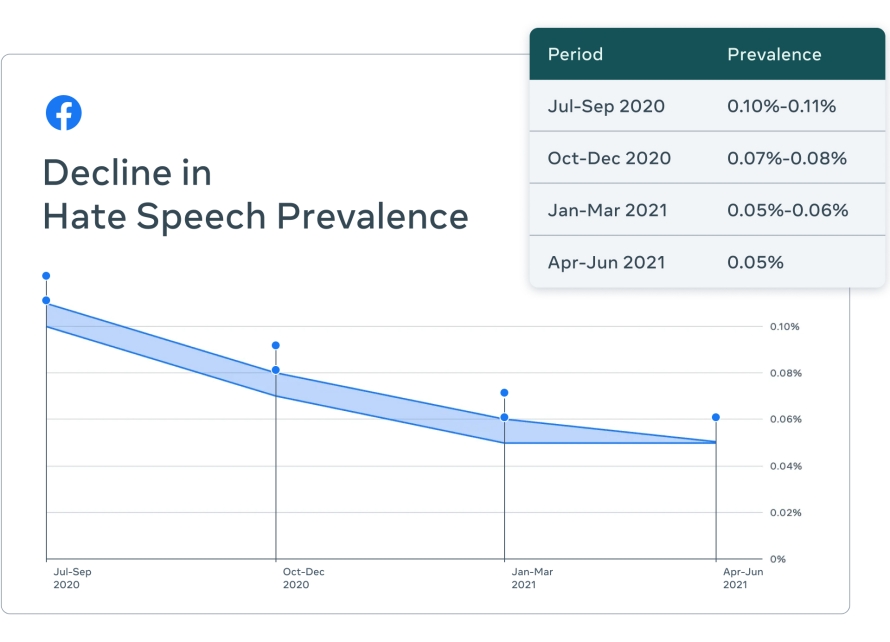

- Nossa tecnologia vem demonstrando um grande impacto na redução do discurso de ódio que as pessoas veem no Facebook. De acordo com nosso último Relatório de Aplicação dos Padrões da Comunidade, sua prevalência é de cerca de 0,05% de conteúdo visualizado, ou cerca de 5 visualizações a cada 10.000, uma queda de quase 50% nos últimos três trimestres.

- Usamos tecnologia para reduzir a prevalência do discurso de ódio de várias maneiras: ela nos ajuda a detectar este tipo de conteúdo proativamente, encaminhá-lo para nossos revisores e removê-lo quando viola nossas políticas. Também nos permite reduzir a distribuição de conteúdo provavelmente violador. Todas essas ferramentas trabalhando juntas são o que têm impacto na prevalência.

- Em 2016, nossos esforços de moderação de conteúdo se baseavam principalmente em denúncias de usuários. Portanto, criamos tecnologia para identificar proativamente o conteúdo violador antes que as pessoas o denunciem. Nossa taxa de detecção proativa reflete isso. No entanto, relatamos números de prevalência para que possamos ser julgados sobre o quanto de conteúdo de discurso de ódio é realmente visto em nossos aplicativos.

Dados extraídos de documentos vazados estão sendo usados para criar uma narrativa de que a tecnologia que usamos para combater o discurso de ódio é inadequada e que deliberadamente representamos incorretamente nosso progresso. Isso não é verdade. Não queremos ver ódio em nossa plataforma, nem nossos usuários ou anunciantes, e somos transparentes sobre nosso trabalho para removê-lo. O que esses documentos demonstram é que nosso trabalho de integridade é uma jornada de anos. Embora nunca atingiremos a perfeição, nossos times continuam a trabalhar para desenvolver sistemas, identificar problemas e construir soluções.

Reportes recentes sugerem que nossa abordagem para lidar com o discurso de ódio é muito mais restrita do que realmente é, ignorando o fato de que a prevalência do discurso de ódio caiu para 0,05%, ou 5 visualizações a cada 10.000 no Facebook. Acreditamos que a prevalência é a métrica mais importante a ser usada porque mostra quanto conteúdo com discurso de ódio é realmente visto no Facebook.

Focar apenas na remoção de conteúdo é a maneira errada de ver como lutamos contra discurso de ódio. Isso porque usar a tecnologia para remover discurso de ódio é apenas uma maneira de combatê-lo. Precisamos ter certeza de que algo é de fato discurso de ódio antes de removê-lo. Se algo pode ser discurso de ódio, mas não temos certeza de que atenda aos requisitos para remoção, nossa tecnologia pode reduzir a distribuição do conteúdo ou não recomendar Grupos, Páginas ou pessoas que regularmente postam conteúdo que provavelmente viola as nossas políticas. Também usamos tecnologia para sinalizar conteúdo que deverá passar por mais revisão.

Temos uma barra alta para a remoção automática de conteúdo. Se não tivéssemos, correríamos o risco de cometer mais erros em conteúdo que parece discurso de ódio, mas não é, prejudicando as próprias pessoas que estamos tentando proteger, como aquelas que descrevem experiências que passaram com atos de ódio ou que o condenam.

Outra métrica que está sendo mal interpretada é nossa taxa de detecção proativa, que nos diz o quão boa nossa tecnologia é para encontrar conteúdo antes mesmo que as pessoas o reportem. Ela nos diz, sobre o conteúdo que removemos, o quanto nós mesmos encontramos. Em 2016, a grande maioria das nossas remoções de conteúdo era baseada nas denúncias de usuários. Sabíamos que precisávamos melhorar e, por isso, começamos a desenvolver tecnologia para identificar conteúdo potencialmente violador, sem que ninguém o reportasse.

Quando começamos a relatar nossas métricas sobre discurso de ódio, apenas 23,6% do conteúdo que removemos era detectado de forma proativa por nossos sistemas; a maior parte do que removemos era encontrado por pessoas. Agora, esse número é superior a 97%. Mas nossa taxa proativa não nos diz o que estamos perdendo e não leva em conta a soma de nossos esforços, incluindo o que fazemos para reduzir a distribuição de conteúdo problemático. É por isso que nos concentramos na prevalência e a descrevemos consistentemente como a métrica mais importante. A prevalência nos diz quanto conteúdo violador as pessoas viram porque nós o perdemos. É desta maneira que avaliamos de forma objetiva o nosso progresso, pois fornece uma imagem mais completa. Falamos sobre a prevalência trimestralmente em nosso Relatório de Aplicação dos Padrões da Comunidade e a descrevemos em nossa Central de Transparência.

A prevalência é como medimos nosso trabalho internamente, e é por isso que compartilhamos a mesma métrica externamente. Embora saibamos que nosso trabalho nunca estará terminado neste espaço, o fato de que a prevalência foi reduzida em quase 50% nos últimos três trimestres mostra que, em conjunto, nossos esforços estão tendo impacto. Conforme relatado em nosso Relatório de Aplicação dos Padrões da Comunidade, podemos atribuir uma parte significativa da queda aos aprimoramento e a expansão dos nossos sistemas de IA.

Trabalhamos com especialistas internacionais para desenvolver nossas métricas. Também somos a única empresa que se comprometeu a passar por uma auditoria independente.

Incluímos muitas métricas em nossos relatórios trimestrais, que são os mais abrangentes de seu tipo, para dar às pessoas uma imagem mais completa. Trabalhamos com especialistas internacionais em pesquisa, estatística e outras áreas para fornecer uma avaliação pública independente e garantir que estamos medindo as coisas certas. Embora tenham concordado amplamente com nossa abordagem, eles também forneceram recomendações sobre como podemos melhorar. Você pode ler o relatório completo aqui. Também nos comprometemos a passar por uma auditoria independente, com a empresa de auditoria global EY, para garantir que estamos medindo e relatando nossas métricas com precisão.