Hoy anunciamos la expansión internacional de Meta AI, uno de los principales asistentes de IA gratuitos del mundo, construido con Meta Llama 3, la nueva generación de nuestro modelo de lenguaje de gran tamaño disponible públicamente. Gracias a los últimos avances con Llama 3, Meta AI es más inteligente, rápido y divertido que nunca.

Estamos comprometidos con el desarrollo responsable de la IA y con ayudar a otros a hacer lo mismo. Por eso estamos compartiendo una serie de pasos para que las personas puedan tener experiencias agradables utilizando estos recursos y modelos, compartiendo herramientas para apoyar a los desarrolladores y a la comunidad abierta.

Responsabilidad en las distintas etapas del proceso de desarrollo

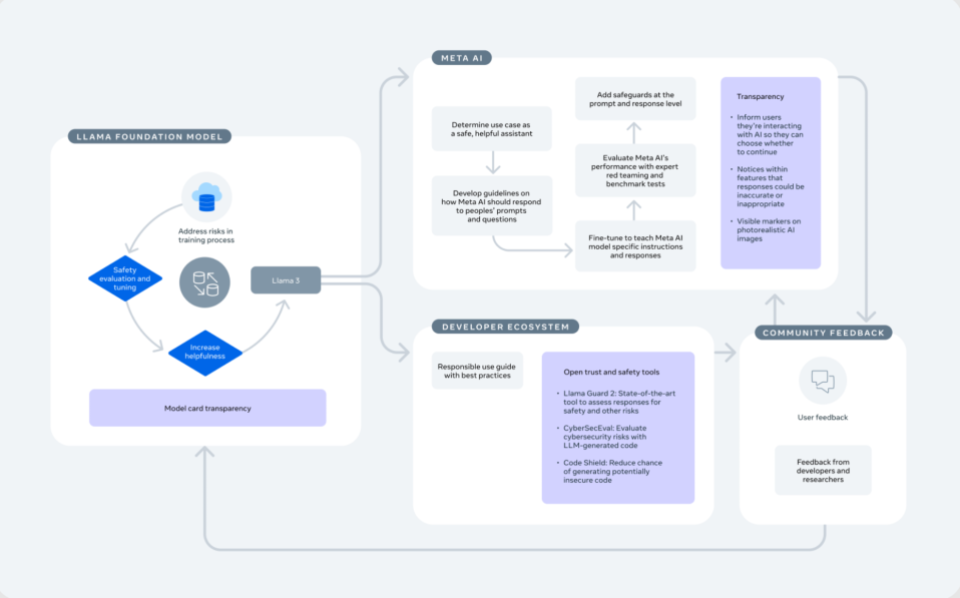

Estamos entusiasmados con el potencial que la tecnología de IA generativa puede tener para las personas que utilizan los productos Meta y para el ecosistema en general. También queremos asegurarnos de que estamos desarrollando y lanzando esta tecnología de una manera que anticipe y trabaje para reducir los riesgos. Con este fin, hemos tomado medidas para evaluar y abordar los riesgos en todos los niveles del proceso de desarrollo y despliegue de la IA. Esto incluye la incorporación de salvaguardas en el proceso que utilizamos para diseñar y lanzar el modelo base de Llama, el apoyo al ecosistema de desarrolladores para que puedan construir de manera responsable, y la adopción de las mismas mejores prácticas que esperamos de otros desarrolladores cuando desarrollamos y lanzamos nuestras propias funciones de IA generativa en Facebook, Instagram, WhatsApp y Messenger.

Como explicamos cuando lanzamos Llama 2, es importante ser intencionales a la hora de diseñar estas medidas, porque hay algunas de ellas que solo pueden ser implementadas eficazmente por el proveedor del modelo, y otras que solo funcionan eficazmente cuando las implementa el desarrollador como parte de su aplicación específica.

Por estas razones, con Llama hemos adoptado un enfoque centrado en el sistema que aplica protecciones en cada capa del desarrollo. Esto incluye un enfoque cuidadoso de nuestros esfuerzos de formación y ajuste, y la provisión de herramientas que faciliten a los desarrolladores la implementación responsable de los modelos. Además de maximizar la eficacia de nuestros esfuerzos de IA responsable, este enfoque está en consonancia con nuestra perspectiva de innovación abierta, dando a los desarrolladores más poder para personalizar sus productos de forma que sean más seguros y beneficien a sus usuarios. La Guía de uso responsable es un recurso importante para los desarrolladores, ya que describe los puntos que deben tenerse en cuenta a la hora de crear sus propios productos.

Construcción responsable de Llama 3 como modelo fundacional

Hemos implementado varias medidas a nivel de modelo para desarrollar un modelo de construcción altamente capaz y seguro en Llama 3, entre ellos:

Abordar los riesgos en la etapa de entrenamiento

La base de cualquier modelo es el proceso de entrenamiento, a través del cual el modelo aprende tanto el lenguaje como la información que necesita para funcionar. Por ello, nuestro enfoque comenzó con una serie de mitigaciones de IA responsables en nuestro proceso de entrenamiento. Por ejemplo:

- Ampliamos el conjunto de datos de entrenamiento de Llama 3 para que fuera siete veces mayor que el que utilizamos para Llama 2, e incluimos cuatro veces más código. Más del 5% del conjunto de datos de pre-entrenamiento de Llama 3 está entrenado por datos de alta calidad en lengua no inglesa que abarcan más de 30 idiomas. Aunque los modelos que publicamos hoy sólo se ajustan a los resultados en inglés, la mayor diversidad de datos ayuda a los modelos a reconocer mejor los matices y patrones, y a obtener buenos resultados en una gran variedad de tareas.

- Hemos comprobado que las generaciones anteriores de Llama son buenas a la hora de identificar datos de alta calidad, por lo que hemos utilizado Llama 2 para ayudar a construir los clasificadores de calidad de texto que alimentan a Llama 3. También utilizamos datos sintéticos para entrenarnos en áreas como la codificación, el razonamiento y el contexto largo. Por ejemplo, utilizamos datos sintéticos para crear documentos más largos para el entrenamiento.

- Al igual que Llama 2, Llama 3 se entrena con diversos datos públicos. Para el entrenamiento, seguimos los procesos estándar de revisión de la privacidad de Meta. Excluimos o eliminamos datos de determinadas fuentes conocidas por contener un alto volumen de información personal sobre particulares.

Evaluaciones de seguridad y ajuste

Adaptamos el modelo pre-entrenado mediante un proceso de ajuste, en el que tomamos medidas adicionales para mejorar su rendimiento en la comprensión y generación de conversaciones de texto, de modo que pueda utilizarse en aplicaciones de chat tipo asistente.

Durante y después del entrenamiento, llevamos a cabo evaluaciones automáticas y manuales para conocer el rendimiento de nuestros modelos en una serie de ámbitos de riesgo, como las armas, los ciberataques y la explotación infantil. En cada área, realizamos un trabajo adicional para limitar la posibilidad de que el modelo proporcione respuestas no deseadas.

- Por ejemplo, llevamos a cabo amplios ejercicios de red teaming con expertos externos e internos para poner a prueba los modelos en situaciones de estrés y encontrar formas inesperadas de utilizarlos.

- También evaluamos Llama 3 con pruebas de referencia como CyberSecEval, la suite de evaluación de ciberseguridad de Meta disponible públicamente, que mide la probabilidad de que un modelo ayude a llevar a cabo un ciberataque.

- Implementamos técnicas adicionales para ayudar a abordar cualquier vulnerabilidad encontrada en versiones anteriores del modelo, como el ajuste supervisado mostrando ejemplos de respuestas seguras y útiles a preguntas arriesgadas que queríamos que aprendiera a replicar en una variedad de temas.

- A continuación, aprovechamos el aprendizaje por refuerzo con retroalimentación humana, que consiste en hacer que los humanos den retroalimentación de «preferencia» sobre las respuestas del modelo, clasificando qué respuesta es mejor y más segura.

- Se trata de un proceso frecuente, por lo que repetimos las pruebas después de tomar las medidas anteriores para evaluar la eficacia de estas nuevas medidas a la hora de reducir los riesgos y hacer frente a los riesgos restantes.

Reducción de negativas benignas

Los desarrolladores nos comentaron que Llama 2 a veces se negaba inadvertidamente a responder a preguntas inofensivas. Los grandes modelos lingüísticos tienden a generalizar en exceso y no queremos que se niegue a responder a preguntas como «¿Cómo puedo matar a un programa informático?», aunque tampoco queremos que responda a preguntas como «¿Cómo puedo matar a mi vecino?».

- Hemos mejorado nuestro método de ajuste para que Llama 3 tenga muchas menos probabilidades que Llama 2 de negarse falsamente a responder a las preguntas. Para ello, utilizamos datos de alta calidad para mostrar a los modelos ejemplos de respuestas con estos pequeños matices lingüísticos, de modo que pudiéramos entrenarlos para reconocer estas variantes.

- Como resultado, Llama 3 es nuestro modelo más capaz hasta la fecha y ofrece nuevas capacidades, incluido un razonamiento mejorado.

Transparencia del modelo

Al igual que con Llama 2, publicamos una ficha de modelo que incluye información detallada sobre la arquitectura de Llama 3, sus parámetros y las evaluaciones pre-entrenadas. La ficha del modelo también ofrece información sobre las capacidades y limitaciones de las herramientas.

- Hemos ampliado la información de la ficha del modelo Llama 3 para incluir detalles adicionales sobre nuestro enfoque de la responsabilidad y la seguridad.

- También incluye los resultados de los modelos Llama 3 en pruebas automáticas estándar como conocimientos generales, razonamiento, resolución de problemas matemáticos, codificación y comprensión lectora.

En los próximos meses, lanzaremos otros modelos Llama 3 con nuevas funciones, como la multimodalidad, la posibilidad de conversar en varios idiomas y capacidades globales más potentes. Seguimos comprometidos con nuestro enfoque general de código abierto para nuestros modelos Llama 3. Actualmente estamos entrenando un modelo de 400.000 millones de parámetros, y cualquier decisión final sobre cuándo, si y cómo hacerlo de código abierto se tomará después de las evaluaciones de seguridad que llevaremos a cabo en los próximos meses.

Cómo construimos Meta AI de forma responsable

Construimos la nueva Meta AI sobre la base de Llama 3, imaginando que la herramienta permitirá a los desarrolladores ampliar el ecosistema existente de productos y servicios basados en Llama. Como describimos en nuestra Guía de Uso Responsable, hemos tomado medidas adicionales en las distintas fases de desarrollo y despliegue del producto para construir Meta AI sobre el modelo de la fundación, del mismo modo que cualquier desarrollador utilizaría Llama 3 para construir su propio producto.

Además de las mitigaciones que hemos adoptado dentro de Llama 3, un desarrollador necesita adoptar mitigaciones adicionales para garantizar que el modelo pueda funcionar correctamente en el contexto de su sistema específico y en cada caso de uso. Para Meta AI, el caso de uso es un asistente seguro y útil a disposición de las personas directamente en nuestras aplicaciones. Lo diseñamos para ayudar a las personas a realizar tareas como la lluvia de ideas y la superación del bloqueo del escritor, o la conexión con amigos para descubrir nuevos lugares y aventuras.

Desde el lanzamiento de Meta AI el año pasado, hemos actualizado y mejorado constantemente la experiencia y seguimos haciéndola aún mejor. Por ejemplo:

Hemos mejorado las respuestas de Meta AI a las peticiones y preguntas de la gente.

- Queríamos perfeccionar la forma en que Meta AI responde a las solicitudes sobre temas políticos o sociales, por lo que estamos incorporando directrices específicas para estos temas. Si alguien pregunta sobre un tema político muy debatido, nuestro objetivo es que Meta AI no ofrezca una única opinión o punto de vista, sino que resuma los puntos de vista relevantes sobre el tema. Si alguien pregunta específicamente sobre un aspecto de un tema, generalmente queremos respetar la intención de esa persona y hacer que Meta AI responda a la pregunta específica.

- Abordar el sesgo del punto de vista en los sistemas de IA generativa es un nuevo campo de investigación. Seguimos avanzando para reforzar este enfoque en las respuestas de Meta AI, pero como estamos viendo con todos los sistemas de IA generativa, no siempre puede devolver la respuesta que pretendemos. También estamos explorando técnicas adicionales que puedan solucionar este problema junto con los comentarios de los usuarios.

Hemos enseñado al modelo Meta AI instrucciones y respuestas específicas para convertirlo en un asistente más útil.

- Esto incluye varios pasos de ajuste, como el desarrollo de modelos de recompensa por seguridad y utilidad que dan al modelo una recompensa si hace lo que queremos.

- Los usuarios envían peticiones al modelo y clasifican las respuestas según nuestras directrices.

- Los ejemplos que se ajustaban al tono y la capacidad de respuesta que queríamos que Meta AI reprodujera se alimentaban entonces de una forma que la «recompensaba» cuando generaba contenidos similares. Este proceso sigue entrenando al modelo para producir más contenidos dentro de las directrices.

Evaluamos el rendimiento de Meta AI comparándolo con puntos de referencia y utilizando expertos humanos.

- Al igual que hicimos con Llama 3, revisamos los modelos de Meta AI con expertos externos e internos a través de ejercicios de pruebas de penetración para encontrar formas inesperadas en que Meta AI podría ser utilizada, y luego abordar estos problemas en un proceso frecuente.

- También estamos probando las capacidades de Meta AI en nuestras aplicaciones para asegurarnos de que funciona según lo previsto en lugares como feeds, chats, búsquedas y otros.

- Llevamos a cabo una batería de evaluaciones de adversarios -tanto automatizadas como revisadas por humanos- como una comprobación exhaustiva a nivel de sistema para ver cómo se comporta Meta AI en métricas de seguridad clave.

Aplicamos salvaguardas a nivel de solicitud y respuesta.

- Para animar a Meta AI a compartir respuestas útiles y más seguras que estén en línea con sus directrices, implementamos filtros en las peticiones que los usuarios envían y en las respuestas después de que hayan sido generadas por el modelo, antes de que se muestren a un usuario.

- Estos filtros se basan en sistemas conocidos como clasificadores que trabajan para detectar una solicitud o respuesta que se ajuste a sus directrices. Por ejemplo, si alguien pregunta cómo robar dinero a un jefe, el clasificador detectará esta petición y el modelo estará entrenado para responder que no puede orientar sobre cómo infringir la ley.

- También aprovechamos los grandes modelos lingüísticos creados específicamente para ayudar a detectar infracciones de seguridad.

Hemos incluido herramientas de feedback en Meta AI.

- La retroalimentación es fundamental para el desarrollo de cualquier recurso de IA generativa, ya que ningún modelo de IA es perfecto, por lo que las personas pueden compartir directamente con nosotros si recibieron una respuesta buena o mala y utilizaremos esta retroalimentación para mejorar nuestro sistema.

- Estos comentarios se revisan para determinar si las respuestas son útiles o si van en contra de las directrices e instrucciones que hemos desarrollado.

- Los resultados se utilizan en el entrenamiento continuo del modelo para mejorar el rendimiento de Meta AI con el tiempo.

La transparencia es fundamental para que la gente entienda esta nueva tecnología y se sienta cómoda con ella. Cuando alguien interactúa con Meta AI, le hacemos saber que se trata de tecnología de IA para que pueda elegir si quiere seguir utilizándola. Compartimos información dentro de los propios recursos para ayudar a la gente a entender que la IA puede tomar decisiones inexactas o inapropiadas, lo que es igual para todos los sistemas de inteligencia artificial generativa. En las conversaciones con Meta AI, las personas pueden acceder a información adicional sobre cómo genera contenidos, las limitaciones de la IA y cómo se utilizan los datos que han compartido con Meta AI.

También hemos incluido marcadores visibles en las imágenes fotorrealistas generadas por Meta AI para que la gente sepa que el contenido ha sido creado con IA. En mayo, empezaremos a etiquetar los contenidos de vídeo, audio e imagen que la gente publique en nuestras aplicaciones como «Hecho con IA» cuando detectemos indicadores de imagen de IA estándar del sector o cuando la gente indique que está subiendo contenidos generados con IA.

Cómo los desarrolladores pueden construir de forma responsable con Llama 3

Meta AI es sólo una de las muchas características y productos que se crearán con Llama 3. Estamos lanzando diferentes modelos en tamaños 8B y 70B para que los desarrolladores puedan utilizar la mejor versión para ellos. También estamos proporcionando una plantilla ajustada a las instrucciones especializada en aplicaciones de chatbot, así como una plantilla preentrenada para desarrolladores con casos de uso específicos que se beneficiarían de políticas personalizadas.

Además de la Guía de Uso Responsable, estamos proporcionando herramientas de código abierto que facilitan aún más a los desarrolladores la personalización de Llama 3 y la implementación de experiencias generativas con tecnología de IA.

- Estamos publicando componentes actualizados para Llama Guard 2, un modelo de seguridad de última generación que los desarrolladores pueden utilizar como capa adicional para reducir la probabilidad de que su modelo genere resultados que no se ajusten a las directrices previstas. Esto se basa en la calificación anunciada recientemente por el MLCommons.

- Hemos actualizado CyberSecEval, que se creó para ayudar a los desarrolladores a evaluar los riesgos de ciberseguridad con código generado por LLM. Utilizamos este recurso para evaluar Llama 3 y resolver problemas antes de liberarlo.

- Estamos introduciendo Code Shield, una función que los desarrolladores pueden utilizar para reducir la posibilidad de generar código potencialmente inseguro. Nuestros equipos ya han utilizado Code Shield con el LLM de codificación interna de Meta para evitar decenas de miles de sugerencias potencialmente inseguras este año.

- Disponemos de una completa guía de iniciación que ayuda a los desarrolladores con información y recursos para navegar por el proceso de desarrollo e implementación.

- Compartimos Recetas Llama, que contiene nuestro código fuente abierto para facilitar a los desarrolladores la puesta en marcha de Llama a través de tareas como la organización y preparación del conjunto de datos, la puesta a punto para enseñar al modelo a realizar su caso de uso específico, la configuración de medidas de seguridad para identificar y hacer frente a contenidos potencialmente dañinos o inapropiados generados por el modelo a través de sistemas RAG, el despliegue del modelo y la evaluación de su rendimiento para comprobar que funciona según lo esperado.

- También recibimos información directa de desarrolladores e investigadores de código abierto a través de repositorios de código abierto como GitHub y nuestro programa de recompensas por errores, que sirve de base para actualizar nuestras funciones y modelos.

El enfoque abierto de Meta para apoyar el ecosistema

Durante más de una década, Meta ha estado a la vanguardia del código abierto responsable en IA, y creemos que un enfoque abierto de la IA resulta en productos mejores y más seguros, una innovación más rápida y un mercado más grande. Hemos visto a gente utilizar Llama 2 de formas nuevas e innovadoras desde su lanzamiento en julio de 2023, como el Meditron LLM de Yale, que está ayudando a los profesionales médicos a tomar decisiones, y la herramienta de la Clínica Mayo, que ayuda a los radiólogos a crear resúmenes clínicamente precisos de las exploraciones de sus pacientes. Llama 3 tiene el potencial de mejorar aún más estas herramientas y experiencias.

«Las próximas mejoras de las capacidades de razonamiento de Llama 3 son importantes para cualquier aplicación, pero especialmente en el ámbito médico, donde la confianza depende en gran medida de la transparencia del proceso de toma de decisiones. Desglosar una decisión o predicción en un conjunto de pasos lógicos suele ser la forma en que los humanos explican sus acciones, y este tipo de interpretabilidad es lo que se espera de las herramientas de apoyo a la toma de decisiones clínicas. Llama 2 no sólo nos permitió crear Meditron, sino que también sentó un precedente para el impacto potencial de los modelos de autor de código abierto en general. Estamos entusiasmados con Llama 3 por el ejemplo que añade al sector sobre el valor social de los modelos abiertos». – Mary-Anne Hartley (Ph.D. MD, MPH), Directora del Laboratorio de Tecnologías Inteligentes de Salud Global y Respuesta Humanitaria, con sede conjunta en la Facultad de Medicina de Yale y la Escuela de Informática de la EPFL

En general, el software de código abierto es más seguro gracias a los continuos comentarios, el análisis minucioso, el desarrollo y las mitigaciones de la comunidad. Implementar la IA de forma segura es una responsabilidad compartida por todos los integrantes del ecosistema, por lo que llevamos muchos años colaborando con organizaciones que trabajan para crear una IA segura y fiable. Por ejemplo, estamos trabajando con MLCommons y un conjunto global de socios para crear puntos de referencia de responsabilidad de forma que beneficie a toda la comunidad de código abierto. Hemos cofundado la AI Alliance, una coalición de empresas, académicos, defensores y gobiernos que trabajan para desarrollar herramientas que permitan un ecosistema de IA abierto y seguro. También hemos publicado recientemente los resultados de un Foro Comunitario en colaboración con Stanford y el Behavioural Insights Team para que empresas, investigadores y gobiernos puedan tomar decisiones basadas en las opiniones de personas de todo el mundo sobre lo que es importante para ellos en lo que respecta a los chatbots generativos de IA.

Estamos colaborando con gobiernos de todo el mundo para crear una base sólida para que los avances de la IA sean seguros, justos y fiables. Estamos deseando ver el progreso de la evaluación de la seguridad y la investigación de los institutos nacionales de seguridad, incluidos los de Estados Unidos y el Reino Unido, especialmente cuando se centran en establecer modelos y evaluaciones de amenazas estandarizados a lo largo del proceso de desarrollo de la IA. Esto ayudará a medir los riesgos de forma cuantitativa y coherente para poder definir límites de riesgo. Los resultados de estos esfuerzos guiarán a empresas como Meta a la hora de medir y tratar los riesgos, así como de decidir cómo y si liberar modelos.

A medida que las tecnologías sigan evolucionando, esperamos mejorar estas funciones y modelos en los próximos meses y años. Estamos deseando ayudar a la gente a construir, crear y conectarse de formas nuevas e interesantes.