Destaques:

- Estamos incorporando salvaguardias a las funciones y modelos de Inteligencia Artificial (IA) antes de lanzarlas para que los usuarios puedan disfrutar de experiencias más seguras y agradables.

- Como ocurre con todos los sistemas de IA generativa, los modelos pueden entregar resultados imprecisos o inadecuados. Seguiremos mejorando estas funcionalidades a medida que evolucionen y tengamos más feedback de las personas.

- Trabajamos con gobiernos, empresas, especialistas en IA del mundo académico y de la sociedad civil, padres y expertos en privacidad, entre otros, para establecer barreras de seguridad responsables.

Meta lleva más de una década siendo una empresa pionera en IA. Hemos lanzado más de 1.000 modelos de IA, bibliotecas y conjuntos de datos para investigadores, incluida la última versión de nuestro gran modelo lingüístico, Llama 2, que fue posibilitado mediante una colaboración con Microsoft.

En Connect 2023, anunciamos varias funciones nuevas de IA generativa que las personas pueden utilizar para hacer que las experiencias que tienen en nuestras plataformas sean aún más sociales e inmersivas. Esperamos que estas herramientas puedan ayudar a las personas de diversas maneras. Imaginemos un grupo de amigos que planean un viaje juntos. En un chat grupal, pueden pedir a un asistente de IA sugerencias de actividades para realizar o restaurantes para experimentar. O en otro caso, un profesor podría utilizar la IA para ayudar a crear clases empleando distintos estilos de aprendizaje personalizados para cada uno de los alumnos.

La construcción de esta tecnología conlleva la responsabilidad de desarrollar las mejores prácticas y las mejores políticas que sea posible. Aunque hay muchos casos de uso interesantes y creativos para la IA generativa, no siempre será perfecta. Los modelos subyacentes, por ejemplo, tienen el potencial de generar respuestas ficticias o exacerbar estereotipos que pueden aprender de los datos que fueron utilizado para su entrenamiento. Hemos incorporado las lecciones que aprendimos durante la última década a estas nuevas funciones, como es el caso de las notificaciones para que las personas puedan entender los límites de la IA generativa, o el de los clasificadores de integridad, que nos ayudan a detectar y eliminar respuestas peligrosas. Todo ello de acuerdo con las mejores prácticas del sector descritas en la Guía de uso responsable de Llama 2.

En consonancia con nuestro compromiso con desarrollar IA en forma responsable, también sometemos nuestros productos a pruebas de estrés para mejorar su seguridad y colaboramos regularmente con legisladores, especialistas del mundo académico y de la sociedad civil, entre muchos otros miembros del sector, para avanzar en el uso responsable de esta tecnología. Desarrollaremos estas funciones paso a paso y lanzaremos las IA en fase beta. Seguiremos perfeccionando y mejorando estas funciones a medida que las tecnologías evolucionen y veamos cómo la gente las utiliza en su vida cotidiana.

Cómo trabajamos de forma responsable y priorizamos la seguridad de las personas

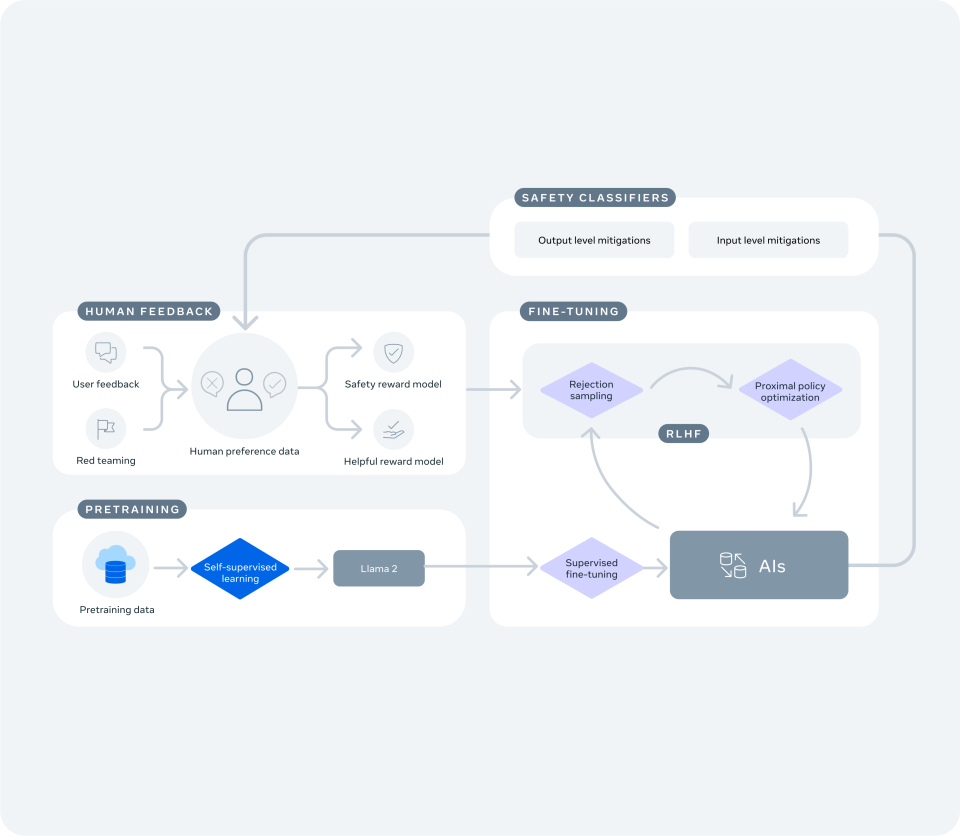

Los modelos de IA personalizados que impulsan nuevas experiencias basadas en texto, como Meta AI, nuestro asistente impulsado por modelos lingüísticos, se construyen sobre la base de Llama 2 y aprovechan sus principios fundacionales de seguridad y responsabilidad. También hemos invertido en medidas específicas para las funciones que anunciamos hoy.

Estamos compartiendo un recurso que explica las medidas que adoptamos para detectar posibles vulnerabilidades, reducir riesgos, mejorar la seguridad y reforzar la fiabilidad. Como por ejemplo:

- Evaluamos y mejoramos nuestras IA conversacionales con especialistas externos e internos empleando ejercicios de ‘red teaming.’ Diferentes equipos integrados por expertos han dedicado miles de horas para probar estos modelos, explorando maneras inusuales de utilizarlos e identificando y corrigiendo vulnerabilidades.

- Refinación de modelos. Esta práctica incluye entrenar modelos para realizar tareas específicas, como la generación de imágenes de alta calidad, con instrucciones que puedan aumentar la probabilidad de obtener respuestas útiles. También los entrenamos para que ofrezcan recursos que cuentan con el respaldo de expertos en seguridad. Por ejemplo, las IA sugerirán organizaciones locales dedicadas a atender la problemática del suicidio o los trastornos alimentarios, en caso de consultas específicas, dejando claro que no pueden dar asesoramiento médico.

- Entrenamos nuestros modelos en pautas de seguridad y responsabilidad. Enseñar pautas a los modelos significa que es menos probable que compartan respuestas potencialmente dañinas o inapropiadas en nuestras apps.

- Adoptamos medidas para reducir la tendenciosidad. El abordaje de los posibles sesgos en los sistemas de IA generativa es un nuevo campo de investigación. Al igual que con otros modelos, el enfoque se va perfeccionando a medida que más personas utilizan las funciones y comparten sus comentarios acerca de su experiencia..

- Desarrollamos nuevas tecnologías para detectar y actuar sobre los contenidos que infringen nuestras políticas. Nuestros equipos han creado algoritmos que escanean y filtran las respuestas perjudiciales antes de que se compartan con los usuarios.

- Hemos incorporado herramientas de retroalimentación dentro de estas funciones. Ningún modelo de IA es perfecto. Utilizaremos los comentarios que recibamos para seguir entrenando los modelos con el fin de mejorar el rendimiento en materia de seguridad y en la detección automática de infracciones de las políticas. También estamos poniendo nuestras nuevas funciones de IA generativa a disposición de los investigadores en ese campo a través del programa de recompensas por fallos de Meta, que lleva mucho tiempo en marcha.

¿Cómo protegemos la privacidad de las personas?

Debemos rendir cuentas acerca de la manera en que protegemos la privacidad de las personas a los reguladores, legisladores y distintos especialistas, y trabajamos con ellos para garantizar que lo que construimos siga las mejores prácticas y cumpla con las normas estrictas de protección de datos.

Creemos que es importante que las personas entiendan los tipos de datos que utilizamos para entrenar los modelos que impulsan nuestros productos de IA generativa. Por ejemplo, no utilizamos sus mensajes privados con amigos y familiares para entrenar nuestras IA. Podemos utilizar los datos de tu uso de los stickers de IA, como tus búsquedas de un sticker para utilizarlo en un chat, para mejorar nuestros modelos de stickers de IA. Puede obtener más información sobre los tipos de datos que utilizamos en nuestro artículo sobre privacidad de la IA generativa.

¿Cómo nos aseguramos de que las personas sepan usar las nuevas funciones y conozcan sus limitaciones?

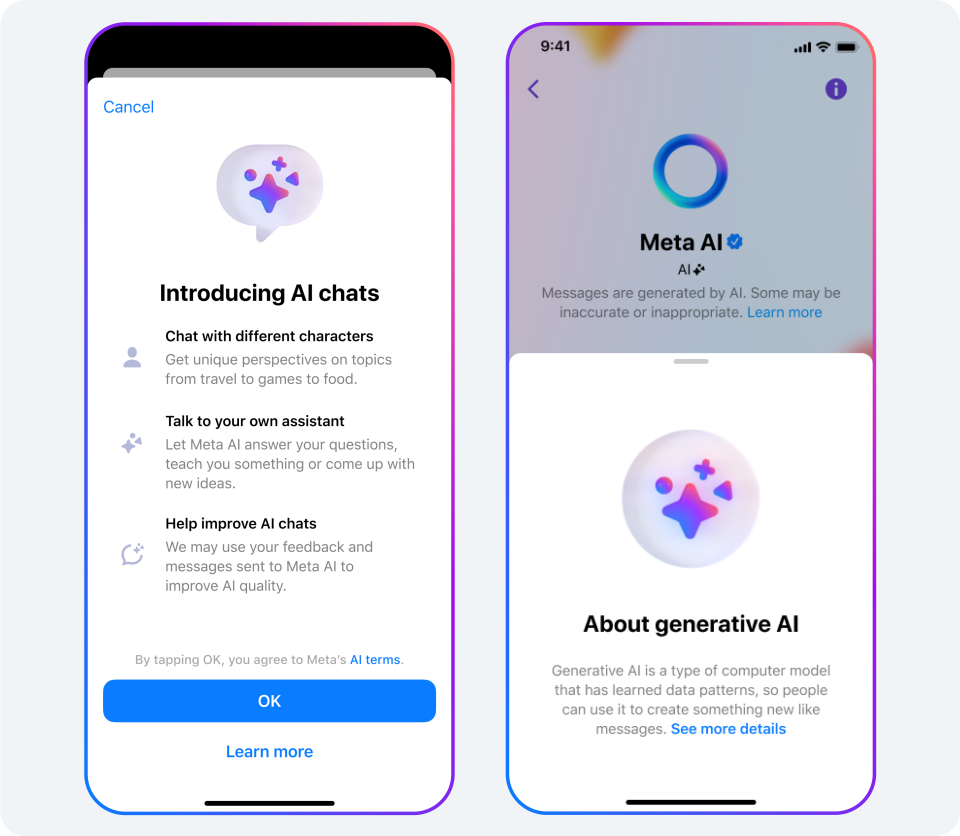

Proveemos información dentro de las mismas funciones para ayudar a las personas a entender cuándo están interactuando con IA y cómo funciona esta nueva tecnología. Indicamos en la experiencia del producto que podría entregar resultados inexactos o inadecuados.

El año pasado publicamos 22 «Tarjetas de Sistema» para dar a los usuarios información comprensible sobre cómo nuestra IA toma decisiones y sus efectos. Hoy compartimos las nuevas tarjetas del sistema de IA generativa en el sitio web de IA de Meta, uno para los sistemas de IA que generan texto que alimenta Meta AI y otro para los sistemas de IA que generan imágenes para los stickers de IA, Meta AI, restyle y backdrop. Estas tarjetas incluyen una demostración interactiva para que los usuarios puedan ver cómo el perfeccionamiento de sus indicaciones afecta a los resultados de los modelos.

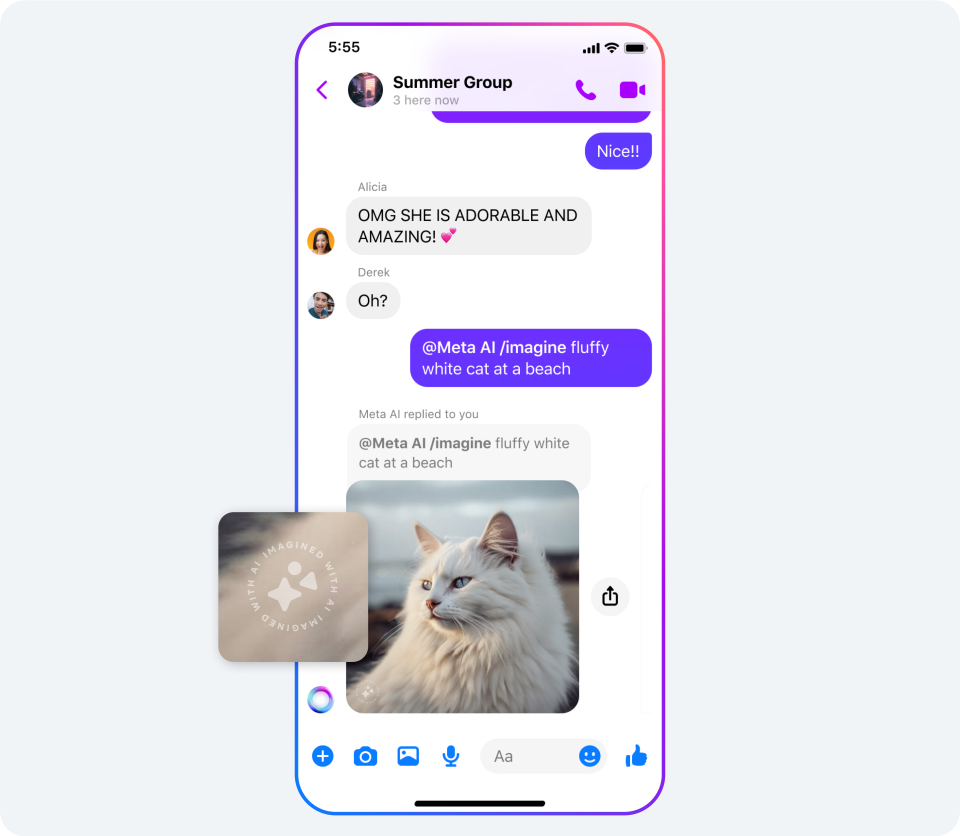

¿Cómo ayudamos a las personas a saber cuándo se crean las imágenes con nuestras funciones de IA?

Seguimos las mejores prácticas de la industria para que sea más difícil difundir información errónea con nuestras herramientas. Las imágenes creadas o editadas por Meta AI, restyle y backdrop tendrán marcadores visibles para que las personas sepan que el contenido fue creado por AI. También estamos desarrollando técnicas adicionales para incluir información dentro de los archivos de imagen que fueron creados por Meta AI, y tenemos la intención de ampliar esto a otras experiencias a medida que la tecnología mejore. No tenemos previsto añadir estas funciones a los stickers de IA, ya que no son fotorrealistas y es poco probable que induzcan a error a las personas haciéndoles creer que son reales.

Actualmente, la industria no tiene normas comunes para identificar y etiquetar los contenidos generados por IA. Creemos que deberían existir y es por eso que estamos trabajando con otras empresas, en foros como el Partnership on AI, con la expectativa de desarrollarlas.

¿Qué medidas estamos tomando para impedir que las personas difundan información errónea utilizando IA generativa?

La inteligencia artificial es un elemento clave para combatir la desinformación y otros contenidos nocivos. Por ejemplo, hemos desarrollado tecnologías de IA para que encuentren contenidos que son prácticamente duplicados de otros ya previamente verificados. También disponemos de una herramienta llamada Few-Shot Learner, que puede adaptarse más fácilmente para actuar con rapidez sobre tipos de contenidos nocivos nuevos o en evolución, y que funciona en más de 100 idiomas. Antes teníamos que recopilar miles o incluso millones de ejemplos para crear un conjunto de datos lo suficientemente grande como para entrenar un modelo de inteligencia artificial, y luego afinarlo para que funcionara correctamente. Few-Shot Learner puede entrenar un modelo de IA basado en apenas un puñado de ejemplos.

La IA generativa podría ayudarnos a eliminar contenidos nocivos con mayor rapidez y precisión que las actuales herramientas de IA. Hemos empezado a probar grandes modelos lingüísticos (LLM) entrenándolos con nuestras Normas Comunitarias para ayudarnos a determinar si un contenido infringe o no nuestras políticas. Estas pruebas iniciales sugieren que los LLM pueden funcionar mejor que los modelos de aprendizaje automático existentes, o al menos mejorar algunos, como Few-Shot Learner, y somos optimistas en que la IA generativa pueda ayudarnos a aplicar nuestras políticas en el futuro.