- Creemos que enfocarnos en la prevalencia –la cantidad de discurso de odio que las personas realmente ven en la plataforma– y cómo reducirla usando nuestras herramientas es la medida más importante.

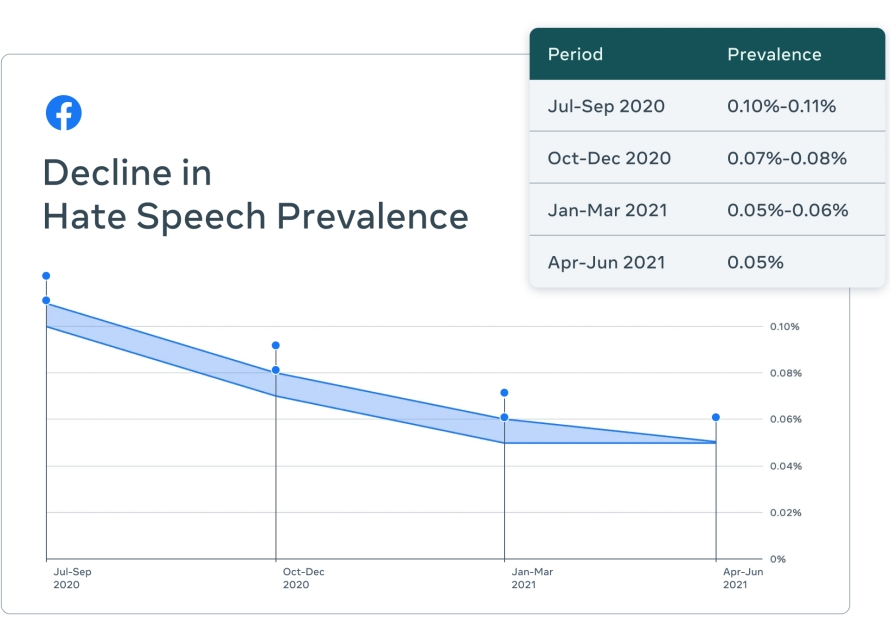

- Nuestra tecnología está siendo muy efectiva para reducir la cantidad de contenido con discurso de odio que las personas ven en Facebook. De acuerdo a nuestro último Informe de Cumplimiento de nuestras Normas Comunitarias, su prevalencia es de cerca de 0.05% del contenido visto, o cerca de 5 vistas de cada 10,000, una disminución de casi 50% en los últimos tres trimestres.

- Usamos la tecnología para reducir la prevalencia del contenido de odio en diversas formas: Nos ayuda a detectarlo proactivamente, mandarlo a nuestros revisores y eliminarlo si viola nuestras políticas. También, nos ayuda a reducir la distribución del contenido posiblemente infractor. Estas herramientas en conjunto generan un impacto en la prevalencia.

- En 2016, nuestros esfuerzos de moderación de contenido dependían principalmente de los reportes de usuarios. Por lo que desarrollamos tecnología para identificar proactivamente contenido infractor antes de que las personas lo reportaran. Nuestra tasa de detección proactiva refleja esto. Sin embargo, publicamos cifras de prevalencia para que podamos ser juzgados con base en cuánto discurso de odio realmente se ve en nuestras aplicaciones.

Los datos tomados de documentos filtrados están siendo usados para afirmar que la tecnología que usamos para combatir el discurso de odio es inadecuada y que deliberadamente interpretamos erróneamente nuestro progreso. Esto no es cierto. Estos documentos demuestran cómo trabajamos: identificamos problemas, pensamos en soluciones y luego nos concentramos en arreglarlos. No queremos ver odio en nuestra plataforma, tampoco nuestros usuarios y anunciantes, y somos transparentes sobre nuestro trabajo para eliminarlo. Lo que demuestran estos documentos es que nuestro trabajo de integridad es un viaje de varios años. Si bien nunca seremos perfectos, nuestros equipos trabajan continuamente para desarrollar nuestros sistemas, identificar problemas y construir soluciones.

Recientes reportes sugieren que nuestro enfoque para combatir el discurso de odio es más limitado de lo que realmente es, ignorando que la prevalencia del discurso del odio se ha reducido a 0.05%, o 5 visitas por cada 10,000 en Facebook. Creemos que la prevalencia es la métrica más importante a utilizar porque muestra cuánto discurso de odio se ve realmente en Facebook.

Concentrarse solo en la cantidad de contenido eliminado es una manera incorrecta de ver nuestras acciones contra el discurso de odio, ya que el uso de la tecnología para eliminar contenido de odio es solo una forma en la que combatimos este problema. Necesitamos estar seguros de que algo es discurso de odio antes de eliminarlo. Si algo pudiera ser discurso de odio pero no estamos suficientemente seguros que cumple con los criterios para su eliminación, nuestra tecnología puede reducir su distribución o no recomendar Grupos, Páginas o personas que comúnmente publican contenido que probablemente viola nuestras políticas. También, usamos la tecnología para identificar el contenido para revisiones adicionales.

Tenemos umbrales altos para la eliminación automática de contenido. Si no los tuviéramos, correríamos el riesgo de cometer más errores sobre el contenido que parece un discurso de odio pero no lo es, dañando a las personas que buscamos proteger, como quienes están compartiendo sus experiencias con el discurso de odio o lo están condenando.

Otra métrica que se malinterpreta es nuestra tasa de detección proactiva, que nos dice qué tan efectiva es nuestra tecnología para detectar contenido antes de que sea reportado por las personas. Nos dice, del contenido que eliminamos, cuánto detectamos por nuestra cuenta. En 2016, la gran mayoría del contenido eliminado se basó en los reportes de usuarios. Sabíamos que necesitábamos mejorar por lo que empezamos a desarrollar tecnología para identificar contenido potencialmente infractor sin necesidad de que alguien nos lo reportara.

Cuando empezamos a compartir nuestras métricas sobre discurso de odio, solo 23.6% del contenido que eliminamos fue detectado proactivamente por nuestros sistemas, la mayoría de lo que eliminamos fue detectado por las personas. Ahora, este número es de más de 97%. Pero esta métrica no nos dice qué nos hace falta y no refleja todos nuestros esfuerzos para reducir la distribución de contenido problemático. Por esto nos enfocamos en la prevalencia y constantemente la describimos como la métrica más importante. La prevalencia nos dice la cantidad de contenido infractor que la gente ve debido a que no lo detectamos. Es la forma más objetiva en la que evaluamos nuestro progreso, ya que muestra el panorama más completo. Mostramos la prevalencia en nuestro Informe de Cumplimiento de nuestras Normas Comunitarias cada trimestre y la describimos en nuestro Centro de Transparencia.

La prevalencia es la forma en que medimos nuestro trabajo internamente y es por eso que compartimos la misma métrica externamente. Si bien sabemos que nuestro trabajo en este sentido nunca concluirá, el hecho de que la prevalencia haya reducido por casi 50% en los últimos tres trimestres muestra que, en conjunto, nuestros esfuerzos están teniendo impacto. Como se reportó en nuestro Informe de Cumplimiento de nuestras Normas Comunitarias, podemos atribuir una parte significativa de la disminución al mejoramiento y ampliación de nuestros sistemas de inteligencia artificial.

Hemos trabajado con expertos internacionales para desarrollar nuestras métricas. También, somos la única empresa que se ha ofrecido voluntariamente para ser auditada de forma independiente.

Incluimos muchas métricas en nuestros informes trimestrales, que son los más completos de su tipo, para dar a las personas un panorama más completo. Hemos trabajado con expertos internacionales en medición, estadísticas y otras áreas para proporcionar una evaluación pública e independiente para asegurarnos de que estamos midiendo las cosas correctas. Si bien estuvieron de acuerdo en general con nuestro enfoque, también dieron recomendaciones sobre cómo podemos mejorar. Consulta el informe completo aquí. También, nos hemos comprometido a someternos a una auditoría independiente de la compañía global EY, para asegurarnos de que estamos midiendo e informando nuestras métricas con precisión.