Por Guy Rosen, Vicepresidente de Producto.

Las personas sólo se sentirán cómodas compartiendo sus experiencias e ideas en Facebook si se sienten seguras. Por eso es que en los últimos dos años invertimos fuerte tanto en tecnología como en recursos humanos para ser más eficientes a la hora de remover contenido abusivo de nuestros servicios. En abril, publicamos por primera vez las guías internas que emplean los equipos de revisión para aplicar nuestras Normas Comunitarias, para que la gente pueda entender mejor qué está permitido y qué no en Facebook, y porqué. Y en mayo divulgamos números sobre el contenido que había violado las normas para que las personas puedan juzgar por sí mismas cómo lo estábamos haciendo.

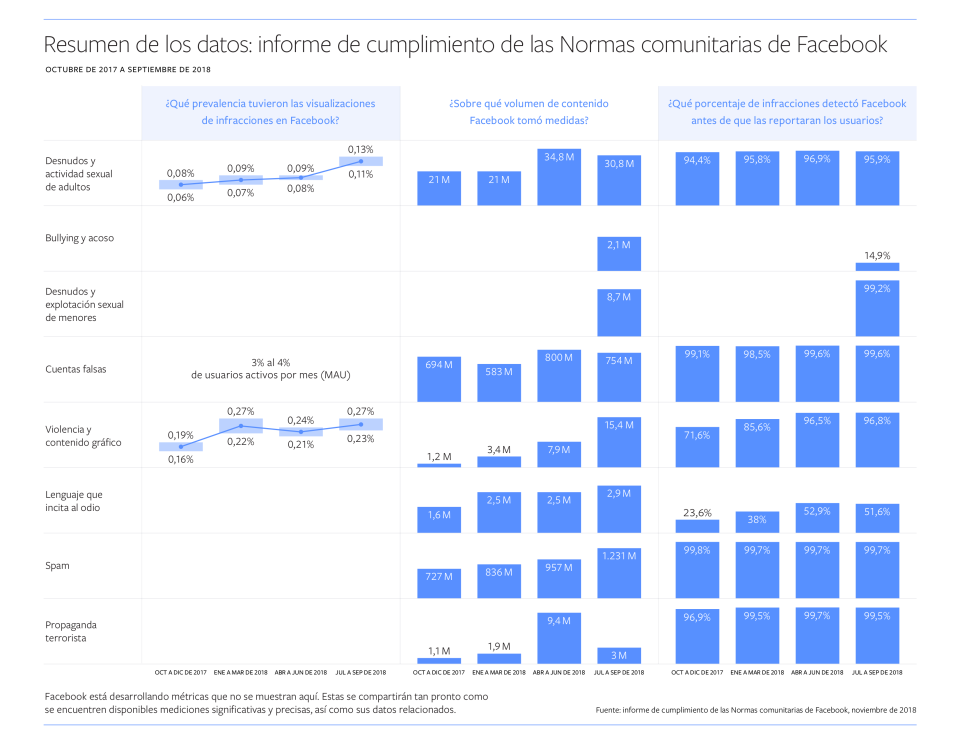

Hoy publicamos nuestro segundo Reporte sobre Cumplimiento de las Normas Comunitarias. Esta segunda entrega muestra la aplicación de nuestras políticas contra la desnudez en adultos y actividad sexual, cuentas falsas, discurso de odio, spam, propaganda terrorista, y la violencia contenido gráfico, para el semestre entre abril y septiembre de 2018. El informe incluye dos nuevas categorías: bullying y acoso, y desnudo infantil y explotación sexual de menores.

Detectando contenido abusivo

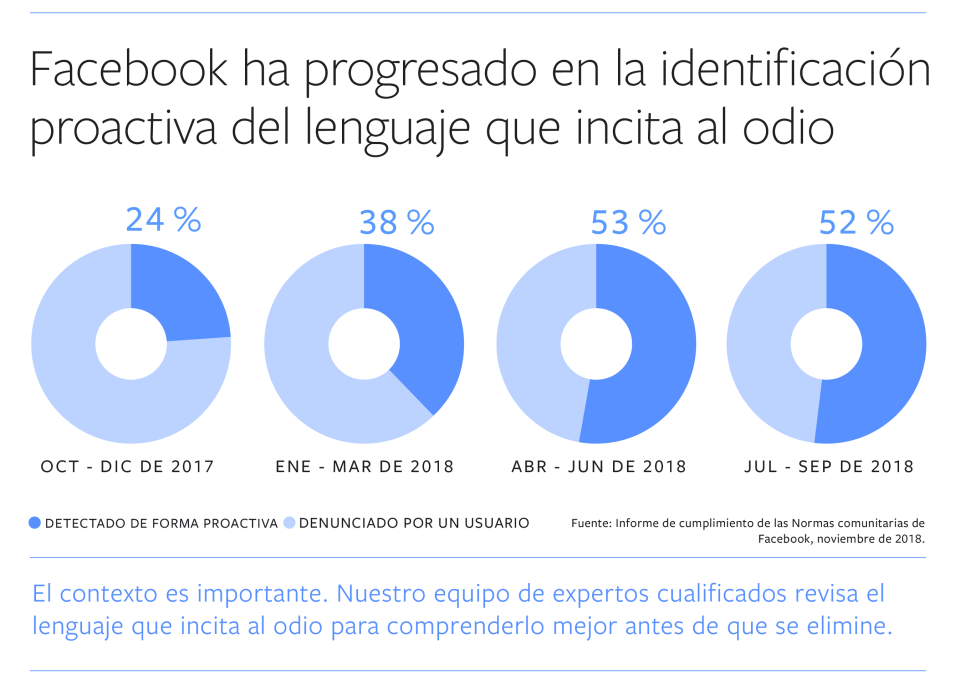

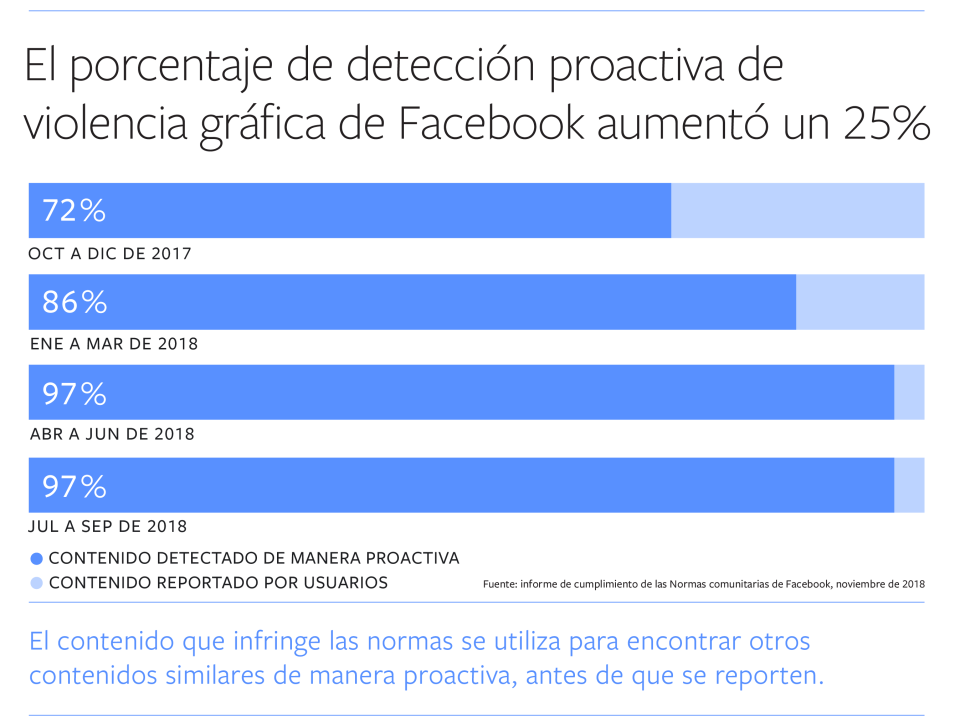

Estamos mejorando en la identificación activa del contenido que vulnera nuestras políticas antes de que sea reportado, específicamente para discurso de odio y violencia gráfica. Pero aún hay áreas en las que tenemos trabajo por hacer.

- Desde nuestro último reporte, la cantidad de discurso de odio que detectamos activamente más que se duplicó hasta llegar a un 52%, desde un 24% previo. La mayoría de las publicaciones que eliminamos en esta categoría fue antes de que nadie lo reportara. Este trabajo tiene una importancia central para nosotros y continuaremos invirtiendo para mejorar nuestro trabajo en aquellos lugares donde aún está en su etapa inicial: los idiomas menos utilizados.

- La detección activa de publicaciones que incluyen violencia gráfica aumentó 25 puntos porcentuales, pasando de un 72 a un 97%.

Remoción de contenido y de cuentas

No sólo hemos mejorado en la tarea de hallar contenido malicioso, también a la hora de removerlo. En el tercer trimestre del 2018 eliminamos 15,4 millones de piezas de contenido que contenían violencia gráfica, más de 10 veces el volumen del cuarto trimestre del 2017. Este incremento respondió a las mejoras constantes en nuestra tecnología, que nos permite aplicar automáticamente la misma acción sobre contenido idéntico o extremadamente similar. Además, como anunciamos la semanas pasada, hubo un aumento significativo en la cantidad de contenido asociado al terrorismo que removimos en el segundo trimestre del 2018. Expandimos el uso de nuestro sistema de comparación de medios – una tecnología que detecta fotos muy similares a otras que ya están en nuestra base de datos de material violatorio – para eliminar imágenes viejas de propaganda terrorista. Parte de este aumento obedece a la corrección de un bug que nos impedía remover ciertos contenidos que iban contra nuestras normas.

También aumentó la cantidad de cuentas falsas que retiramos de la plataforma en el segundo y el tercer trimestre del 2018, en comparación con los mismos períodos del año anterior: 800 millones y 754 millones, respectivamente. La mayoría de ellas fueron creadas para para diseminar spam con el objetivo de ganar dinero, generando cuentas a granel. Gracias a que fuimos capaces de eliminar la mayoría de esas cuentas apenas minutos después de que fueran registradas, la presencia de cuentas falsas en Facebook permaneció estable entre un 3 y 4% de los usuarios activos, como informamos en nuestro balance del tercer trimestre.

Nuevas categorías

Los datos de las dos nuevas categorías que estamos agregando en este reporte – bullying y asedio, y desnudo infantil y explotación sexual de menores – servirán como punto de partida para también poder medir nuestro progreso a lo largo del tiempo en relación a este tipo de violación.

Bullying y asedio suelen ser ataques personales que se producen en un determinado contexto, por lo que en muchas ocasiones es necesario que una persona reporte este comportamiento antes de que podamos identificarlo y eliminarlo. Esto lleva a una tasa más baja de detección activa que en otro tipo de abusos. En el último trimestre, eliminamos 2,1 millones de piezas de contenido que violaban nuestras políticas de bullying y asedio, un 15% antes de que fuera informado. Descubrimos este contenido mientras buscábamos activamente otras violaciones. El hecho de que las víctimas tengan que reportar este tipo de contenido antes de que podamos actuar puede ser irritante. Estamos determinados a mejorar nuestro entendimiento de estos abusos para poder detectarlos mejor en forma activa.

Nuestras Normas Comunitarias prohiben la explotación de menores. Pero para evitar potenciales abusos removemos contenido no sexual como fotos inocentes de niños en la bañera, que insertadas en un contexto diferente podrían fácilmente ser usadas maliciosamente. Sólo en el último trimestre, eliminamos 8,7 millones de piezas de contenido que vulneraba nuestras normas, un 99% del cual fue removido antes de ser reportado. Recientemente anunciamos una nueva tecnología para luchar contra la explotación sexual en Facebook, que confío en que nos ayudará a identificar más contenido malicioso con mayor rapidez.

Sabemos que tenemos mucho más trabajo por delante para prevenir abusos en Facebook. Y la Inteligencia Artificial continuará ayudándonos a detectar y eliminar contenido abusivo de nuestra plataforma. Poder medir nuestro progreso es también crucial, porque mantiene a nuestros equipos enfocados en los desafíos que enfrentamos. Para evaluar nuestra metodología hemos estado trabajando con la organización Data Transparency Advisory Group (DTAG), especializada en gobernanza corporativa. Seguiremos trabajando este tipo de información para que nuestros datos sean más precisos y significativos con el tiempo.

Puedes ver más información sobre este reporte y sobre el de Solicitudes de las Autoridades y Remociones de Propiedad Intelectual aquí. Ambos estudios estarán disponibles en más de 15 idiomas a principios de 2019.