Por Guy Rosen, VP de Producto

A menudo nos preguntan cómo decidimos qué contenido puede ser publicado en Facebook y cuál es considerado inapropiado. Nuestras Normas Comunitarias, vigentes desde hace años, determinan qué puede permanecer en la plataforma y qué debe ser retirado. Hace tres semanas publicamos por primera vez los criterios internos que usamos para hacer cumplir esas normas y hoy divulgamos las estadísticas sobre el Cumplimiento de Normas Comunitarias, para que todo el mundo pueda analizarlas.

Alex Schultz, Vicepresidente de Análisis de Datos, explica en una publicación en nuestro blog de Preguntas Difíciles y en una guía para Comprender el Informe de Cumplimiento de Normas Comunitarias, cómo Facebook realiza ese trabajo. Es importante remarcar que por tratarse de una tarea en constante evolución, la metodología puede ser modificada a medida que aprendamos más y podamos identificar las prácticas que funcionan mejor.

Este informe cubre seis áreas: violencia gráfica, desnudez en adultos y actividad sexual, propaganda terrorista, discurso de odio, spam y cuentas falsas.

El reporte detalla:

- La cantidad de contenido que viola nuestras normas visto por usuarios de Facebook.

- La cantidad de contenido que fue eliminado.

- La cantidad de contenido que fue detectado a través de la tecnología antes de que los usuarios de Facebook lo reportaran.

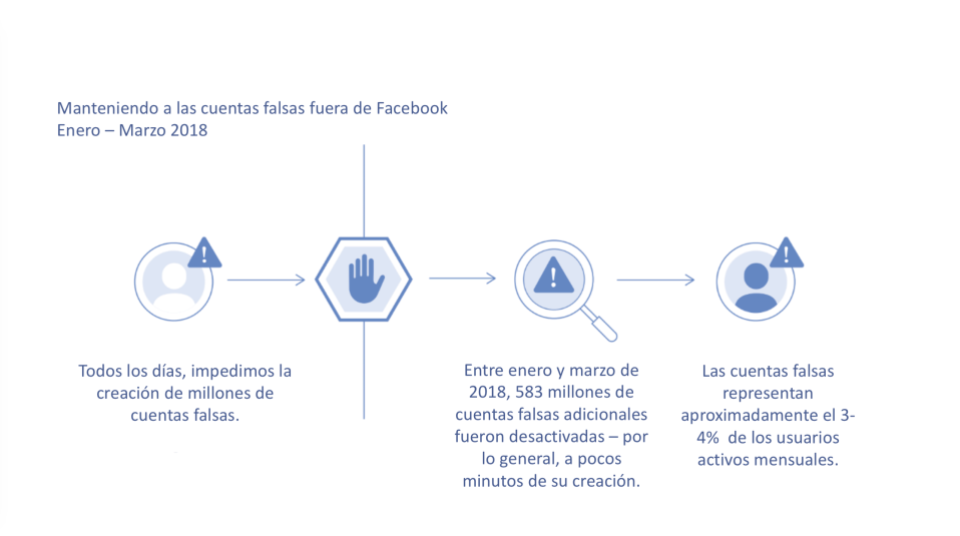

La mayor parte del trabajo que hacemos para eliminar contenido inapropiado involucra cuentas falsas y el spam que estas generan. Los resultados del primer trimestre de 2018 muestran que:

- Eliminamos 837 millones de mensajes no deseados, casi todos detectados antes de que fueran reportados por los usuarios.

- Desactivamos alrededor de 583 millones de cuentas falsas, la mayoría apenas unos minutos después de que fueran registradas. Este dato se suma a las tareas de prevención que evitan que millones de cuentas falsas sean creadas diariamente. Calculamos que entre 3 y 4 por ciento de las cuentas activas durante el período analizado eran falsas.

Otros tipos de contenido inapropiado:

- Eliminamos 21 millones de publicaciones de desnudos de adultos o material pornográfico durante el primer trimestre de 2018. Un 96 por ciento fue detectado y marcado con herramientas tecnológicas antes de que fuera reportado. Nuestros estudios indican que de cada 10.000 publicaciones visualizadas en Facebook, entre siete y nueve incluían material que violaba nuestros estándares.

- En casos más graves, como violencia gráfica o discursos de odio, nuestra tecnología aún no es lo suficientemente eficaz y requiere de la participación de equipos de revisión. Dimos de baja o colocamos advertencias sobre cerca de 3,5 millones de publicaciones con contenido violento en el primer trimestre de 2018, un 86% de las cuales fueron identificadas por nuestra tecnología antes de que fueran reportadas. También fueron eliminados 2,5 millones de artículos que contenían discurso de odio, un 38% de los cuales fueron identificado por nuestra tecnología.

Como dijo Mark Zuckerberg durante la conferencia de desarrolladores F8 el mes pasado, todavía tenemos mucho trabajo por hacer para evitar los abusos en la plataforma. Y debido a que prometedoras tecnologías como la inteligencia artificial aún están lejos de ser efectivas para detectar la mayoría del contenido inapropiado, el contexto es clave. Por ejemplo, la inteligencia artificial no es lo suficientemente buena para determinar si alguien está publicando discurso de odio o lo está mencionando para darlo a conocer. Como explicamos la semana pasada, la tecnología necesita de grandes cantidades de datos para aprender a reconocer patrones de comportamiento, que frecuentemente no están disponibles en los idiomas menos utilizados o en los casos reportados con menor frecuencia. Además, en muchas áreas, como la pornografía, el spam o las cuentas falsas, enfrentamos adversarios sofisticados que cambian continuamente de táctica para eludir nuestros controles y eso exige una adaptación continua en nuestros esfuerzos. Es por eso que estamos invirtiendo en personal y en desarrollar una mejor tecnología para hacer que Facebook sea un lugar más seguro para todos.

También es por eso que estamos publicando esta información. Creemos que una mayor transparencia contribuye a crear una mayor responsabilidad y el hecho de divulgar estos datos también nos ayudará a mejorar más rápidamente. Esta es la misma información que empleamos para medir internamente nuestro progreso y ahora ustedes también pueden juzgar nuestro trabajo. Esperamos poder contar con sus comentarios.