주요 내용:

- 청소년 계정의 다이렉트 메시지(DM)에 새로운 안전 기능이 추가되어, 청소년이 대화 중인 상대 상대에 대한 더 많은 정보를 확인할 수 있습니다.

- 나체 사진이 포함된 이미지를 흐리게 처리하는 기능을 비롯해, 최근 적용된 안전 기능의 성과에 대한 데이터를 공개합니다.

- Meta는 아동이 주로 등장하는 성인 운영 계정에도 청소년 계정의 보호 기능 일부를 확대 적용했으며, 이러한 계정을 악용하려는 이들에 대해 지속적으로 엄정하게 대응하고 있습니다.

Meta는 청소년에게 연령에 맞는 경험을 제공하고 원치 않는 연락을 방지하는 청소년 계정부터 아동 성착취 콘텐츠를 탐지하고 제거하는 정교한 기술까지, 다양한 방식을 통해 청소년이 직·간접적인 위험으로부터 보호받을 수 있도록 노력하고 있습니다.

오늘 Meta는 이러한 노력을 강화하기 위한 다양한 업데이트를 발표하며, 최근 도입된 안전 기능들의 효과에 대한 새로운 데이터도 함께 공개하고자 합니다.

청소년을 잠재적인 위험이나 원치 않는 연락으로부터 보호하기

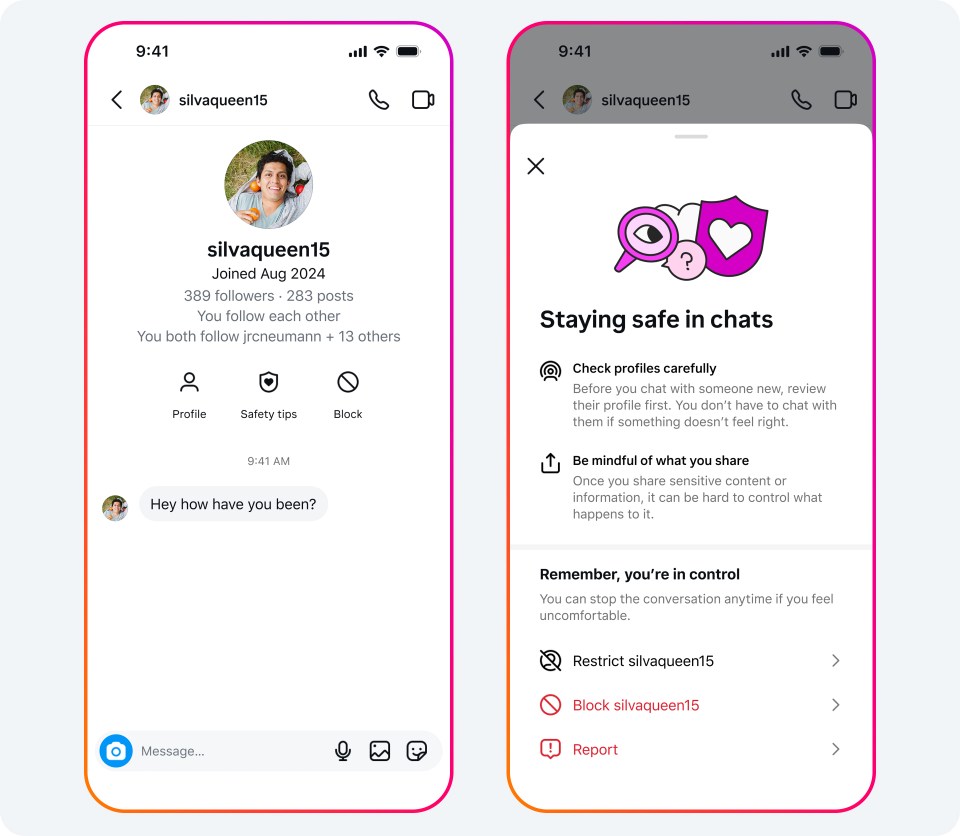

최근 청소년 계정의 다이렉트 메시지(DM)에 새로운 안전 기능이 추가되었습니다. 이 기능은 메시지를 주고받는 상대 계정에 대한 정보를 더 많이 제공해, 잠재적인 사기 계정을 식별하는 데 도움이 됩니다. 이제 청소년은 DM 채팅방 상단에서 안전 팁 및 계정 차단 옵션과 함께, 대화를 나누는 계정이 Instagram에 가입한 시기(가입 연도와 월)를 확인할 수 있습니다.

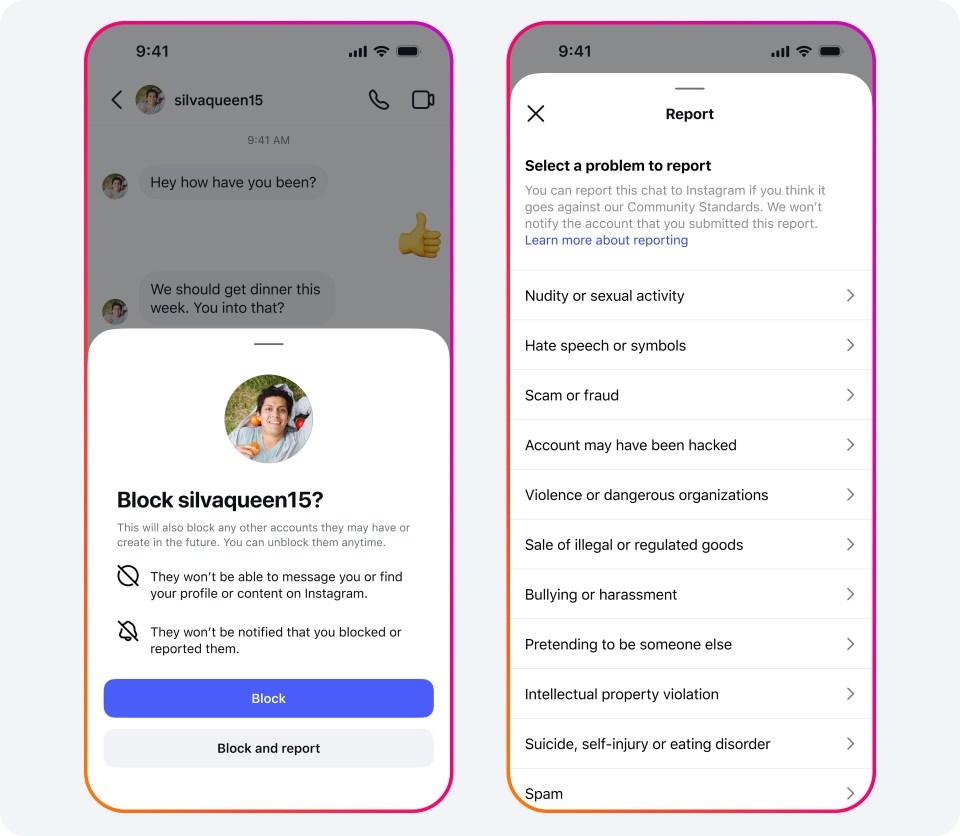

또한 DM에 계정 차단과 신고를 한 번에 진행할 수 있는 통합 옵션을 새롭게 추가했습니다. Meta는 늘 의심스러운 이용자를 차단하고 신고할 것을 권장하고 있습니다. 이번 통합 기능은 해당 절차를 보다 간소화해주며, 커뮤니티 가이드라인 위반 가능성이 있는 계정들이 신고를 통해 원활한 검토 및 조치가 이뤄질 수 있도록 지원합니다.

이러한 새로운 기능들은 개인 메시지 공간에서 이용자들이 보다 신중하게 행동하고, 불편함을 느낄 경우 바로 차단 및 신고할 수 있도록 안내하는 기존의 ‘안전 알림(Safety Notice)’을 보완합니다. 특히 청소년들이 이러한 알림에 적극적으로 반응하고 있다는 점에서 고무적입니다. 6월 한 달 동안만 해도, 청소년들은 안전 알림을 확인한 후 100만 건의 계정을 차단하고, 또 다른 계정 100만 건을 신고했습니다.

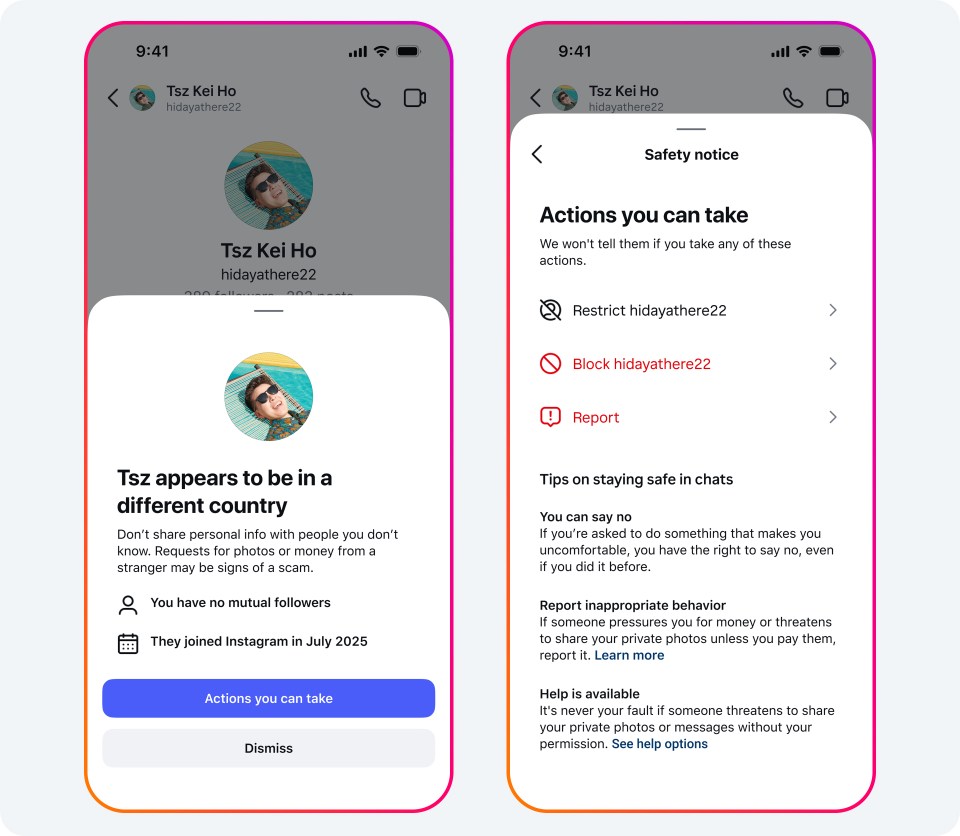

또한, 지난 6월에 청소년과 어린 성인 이용자들이 Instagram에 새롭게 도입된 ‘위치 알림(Location Notice)’을 100만 회 확인했으며, 이들 10명 중 1명은 해당 알림을 눌러 추가로 취할 수 있는 조치에 대해 알아봤습니다. 위치 알림은 메시지를 주고받는 상대가 다른 국가에 있을 수 있는 점을 알려주는 기능으로, 종종 실제 거주지를 속이는 경우가 많은 성착취 사기범들로부터 이용자를 보호하기 위해 설계되었습니다.

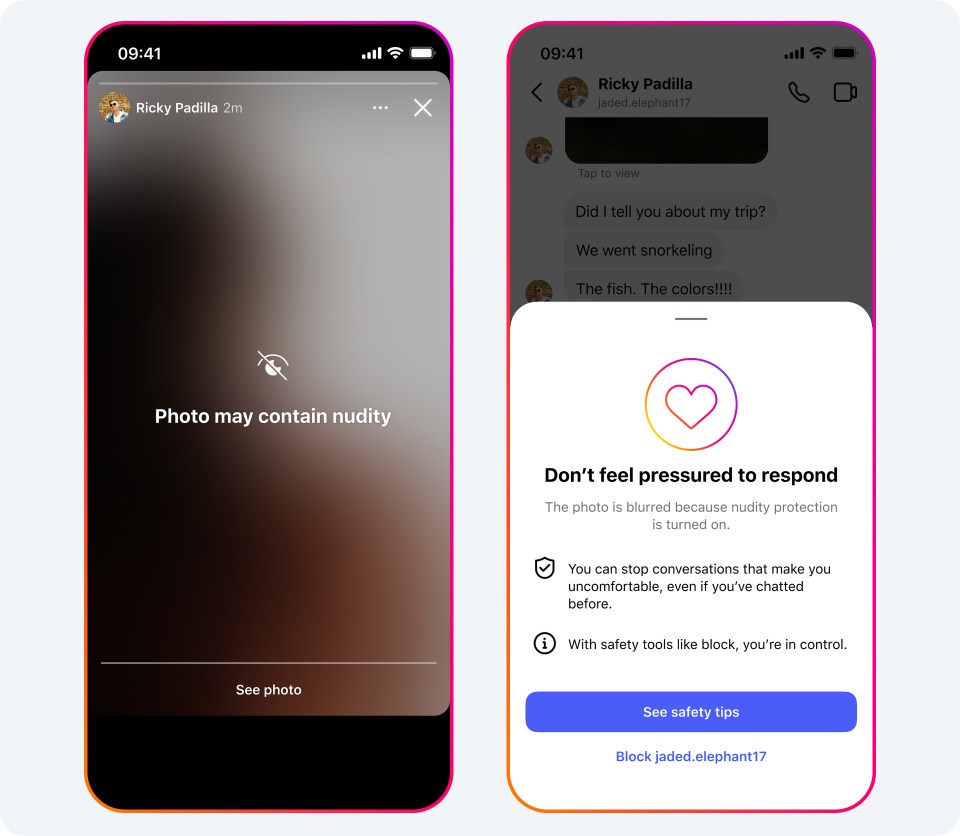

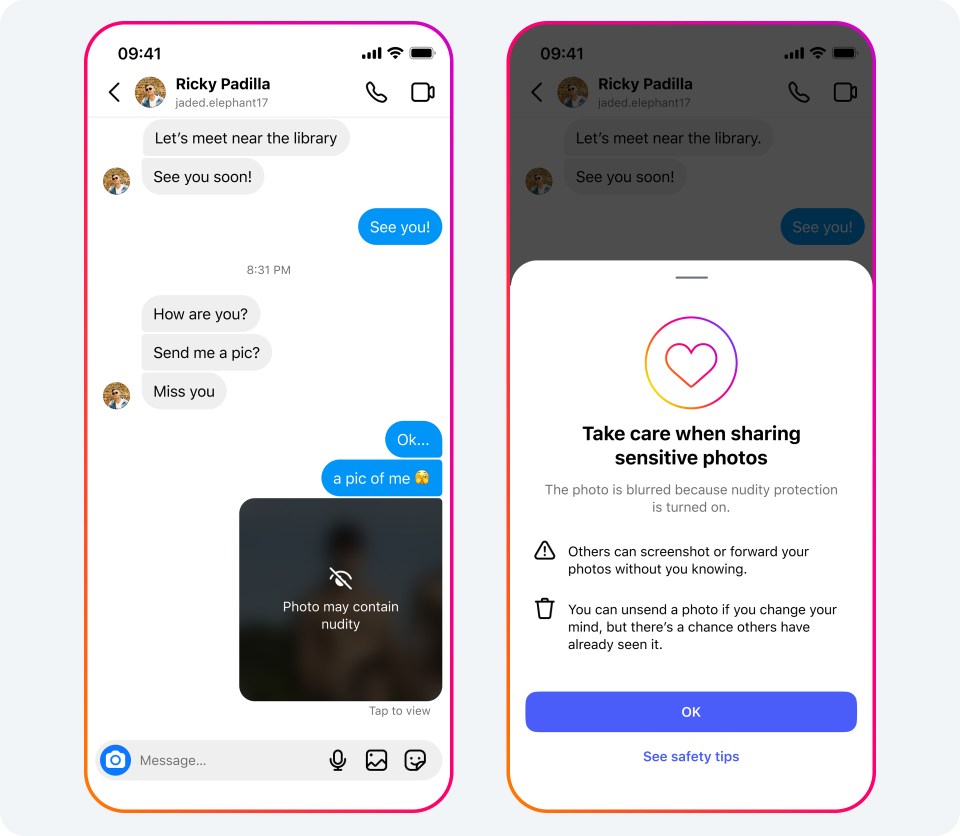

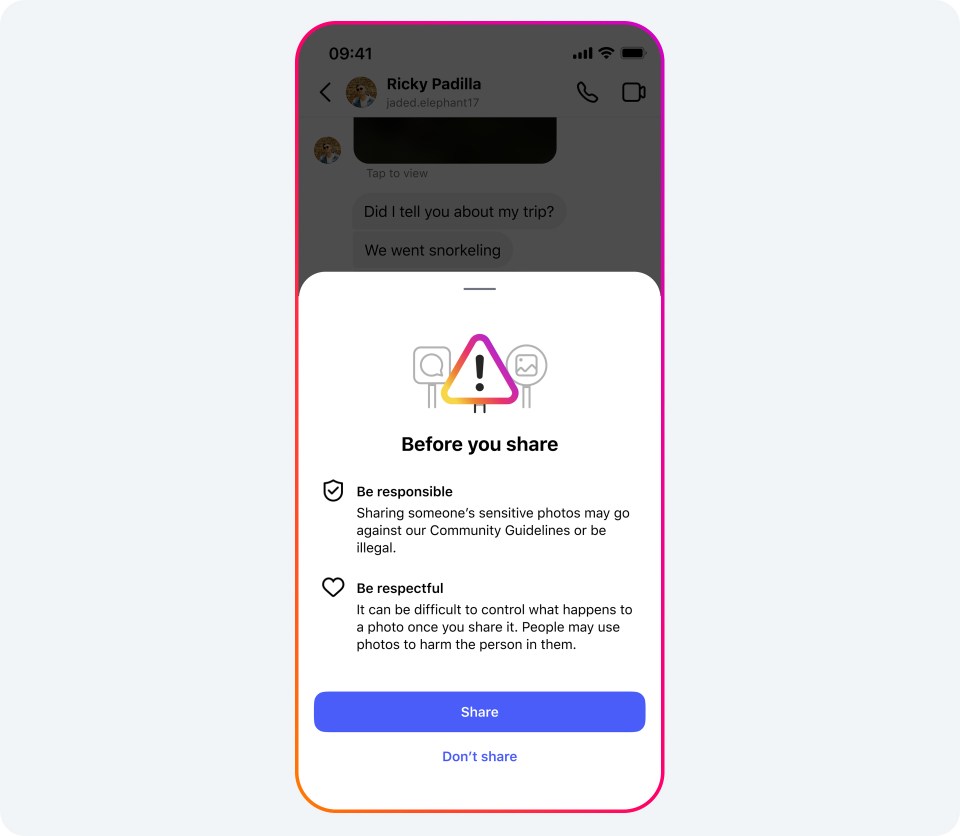

나체 사진이 포함된 이미지를 감지하면 사진을 흐리게 처리하는 나체 이미지 방지 기능을 전 세계에 도입한 후, 청소년을 포함한 이용자의 99%가 해당 기능을 켠 상태로 유지하고 있습니다. 6월에는 DM에서 받은 블러(blur) 처리된 이미지 중 40% 이상이 끝까지 흐린 상태로 유지되어, 원치 않는 이미지에 노출될 가능성을 크게 줄였습니다. 나체 이미지 방지 기능은 청소년에게 기본적으로 자동 적용되며, 의심되는 나체 이미지를 전달하기 전에 다시 한번 신중하게 생각해보도록 유도합니다. 실제로 5월에는 경고 메시지를 본 이용자 중 약 45%가 이미지 공유를 중단한 것으로 나타났습니다.

어린이가 주로 등장하는 성인이 운영하는 계정에도 청소년 계정 보호 장치 일부 도입

Meta는 어린이가 주로 등장하는 계정을 운영하는 성인 사용자에 대해서도 보호 조치를 강화하고 있습니다. 여기에는 자녀의 사진과 영상을 정기적으로 공유하는 보호자나, 만 14세(글로벌 기준 만 13세) 미만 아동 또는 청소년을 대신해 계정을 운영하는 부모, 매니저 등의 성인이 포함됩니다. 인스타그램은 원칙적으로 만 14세(글로벌 기준 만 13세) 이상만 이용할 수 있지만, 계정 소개란에 성인이 운영 중임이 명확히 표시된 경우에는 예외적으로 만 14세 미만 아동을 대표하는 계정을 허용합니다. 단, 해당 계정을 실제로 아동 본인이 운영하는 것으로 확인될 경우, 해당 계정은 삭제됩니다.

이러한 계정 대부분은 선의의 목적으로 운영되고 있지만, 게시물에 성적인 댓글을 달거나 DM으로 성적인 이미지를 요청하는 등 Meta의 규칙을 명백하게 위반하며 악용하는 사례도 존재합니다. 이에 따라 Meta는 이러한 악용을 방지하기 위한 추가 조치를 도입합니다.

저희는 청소년 계정에 적용되는 보호 기능의 일부를, 아동이 주로 등장하는 성인 운영 계정에도 확대 적용합니다. 이에 따라 해당 계정은 원치 않는 메시지를 차단해주는 가장 엄격한 메시지 수신 설정이 자동으로 적용되며, 불쾌한 댓글을 필터링하는 ‘숨겨진 단어(Hidden Words)’ 기능도 자동으로 활성화됩니다. 적용 대상 계정에는 인스타그램 피드 상단에 알림을 띄워 안전 설정이 업데이트되었음을 안내하고, 계정의 개인정보 보호 설정을 점검하도록 유도할 예정입니다. 이러한 변경 사항은 향후 몇 달에 걸쳐 순차적으로 적용될 예정입니다.

또한 Meta는 청소년에게 차단당한 이력이 있는 등 잠재적으로 의심스러운 성인이 이러한 계정을 애초에 찾지 못하도록 조치를 취하고자 합니다. 이를 위해 성인이 운영하지만 아동이 주로 등장하는 계정이 잠재적으로 의심스러운 성인에게 추천되지 않도록 하고, 반대로 의심스러운 성인의 계정도 해당 계정에 추천되지 않도록 할 예정입니다. 또한 서로가 검색을 통해 쉽게 찾지 못하도록 하고, 의심스러운 성인이 남긴 댓글은 게시물에서 자동으로 숨겨질 수 있도록 할 계획입니다. 이는 지난해, 어린이가 주로 등장하는 계정에 대해 구독이나 선물 수령 기능을 제한한 데 이어 추가로 강화된 보호 조치입니다.

온라인 전반에 걸친 유해 계정에 대한 조치 강화

이러한 새로운 보호 기능 외에도, Meta는 커뮤니티 규정을 위반하는 계정에 대해 지속적으로 강력한 대응을 이어가고 있습니다. 올해 초, Meta 전문 팀은 만 13세 미만 아동이 등장하는 성인 운영 계정에 성적인 댓글을 달거나 성적인 이미지를 요청한 Instagram 계정 약 13만 5천 개를 삭제했습니다. 또한, 해당 계정들과 연결된 Facebook 및 Instagram 계정 50만 개도 추가로 삭제 조치했습니다. Meta는 이러한 계정의 콘텐츠와 부적절하게 상호작용한 계정이 삭제되었음을 이용자들에게 알리고, 경각심을 갖고 차단 및 신고 기능을 활용할 수 있도록 안내했습니다.

아동을 착취하려는 이들은 특정 플랫폼에서만 활동하지 않기 때문에, Meta는 이러한 유해 계정들의 정보를 아동 온라인 안전을 위한 비영리단체인 ‘Tech Coalition’의 Lantern 프로그램(크로스 플랫폼 시그널 공유 시스템)을 통해 다른 테크 기업들과도 공유했습니다.