주요 내용

- Meta는 동영상과 오디오를 포함한 AI 콘텐츠를 식별하는 공통 기술 표준을 마련하기 위해 업계 파트너들과 협력하고 있습니다.

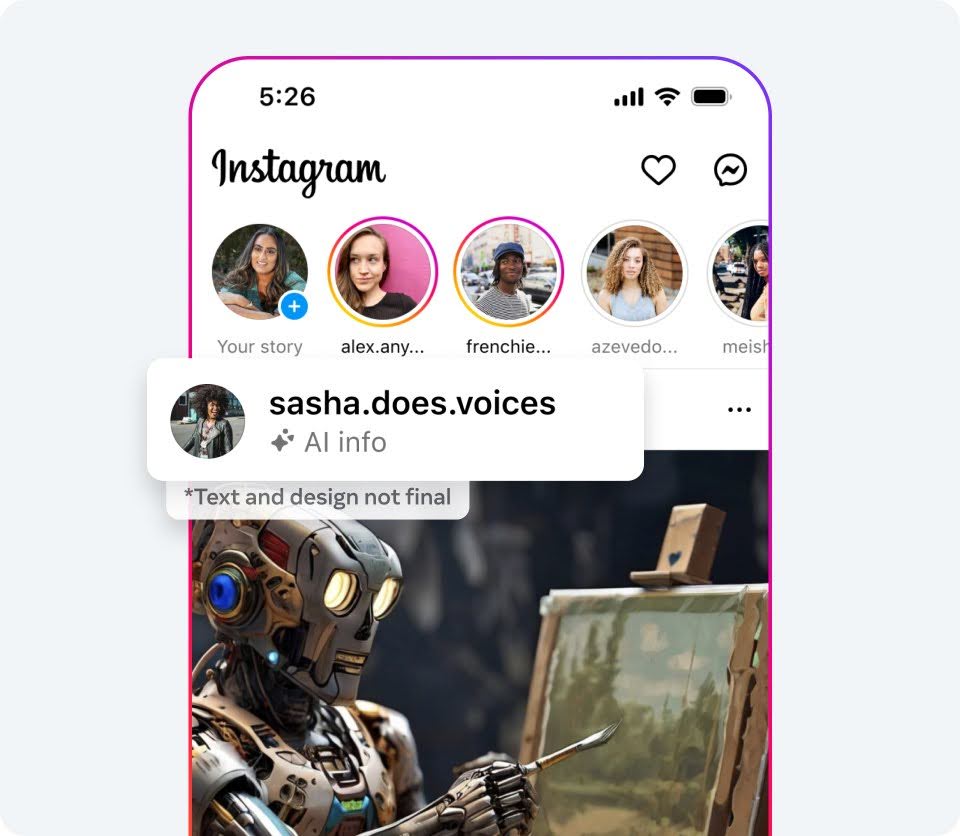

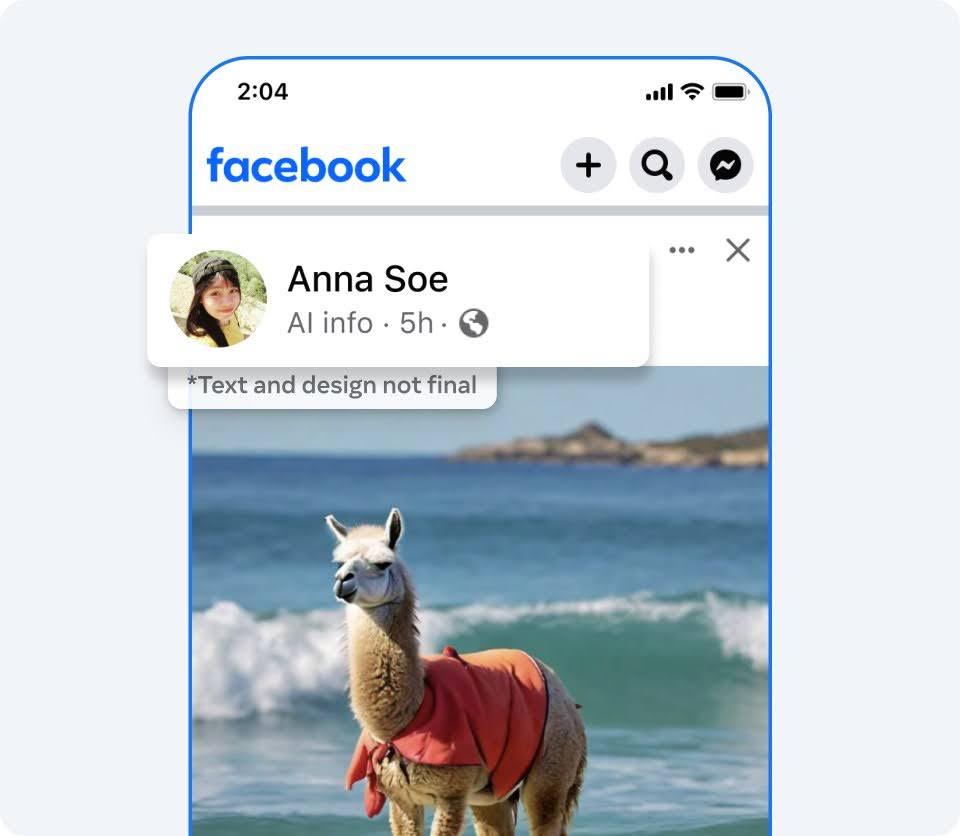

- 앞으로 수개월 내 Facebook, Instagram 및 Threads에 게시하는 이미지에 AI로 생성되었다는 업계 표준 지표가 감지될 경우, 이를 알리는 라벨이 표시됩니다.

- Meta는 Meta AI를 사용해 만든 이미지에 “Imagined with AI” 라벨을 표시함으로써 해당 이미지가 AI로 생성되었음을 알리고 있습니다.

10여 년간 AI 산업을 선도해온 기업으로서, 간단한 텍스트 명령어로 사진을 생성하는 Meta AI 이미지 생성 도구와 같은 새로운 툴을 통해 창의력이 폭발하는 현장을 목격하는 것은 매우 고무적인 일입니다.

사람이 만든 콘텐츠와 AI가 만든 콘텐츠의 구분이 모호해지면서, 사람들은 그 경계가 어디에 있는지 알고 싶어합니다. AI 기반 콘텐츠가 아직은 많은 사람들에게 생소하기 때문에, 이용자들은 이 새로운 기술에 대한 투명성이 필요하다고 이야기합니다. 지금 보고 있는 실제 사진처럼 보이는 콘텐츠가 AI 도구를 통해 제작됐다는 사실을 알 수 있도록 하는 것이 중요한 것이죠. 이를 위해 현재 Meta는 Meta AI 기능을 사용해 제작된 콘텐츠에는 “Imagined with AI’ 라벨을 함께 표시하고 있습니다. 하지만 다른 회사의 AI 도구를 통해 제작된 콘텐츠에도 이러한 라벨을 적용할 수 있게 되길 희망합니다.

이것이 특정 콘텐츠가 AI를 사용해 제작되었음을 알아채는 공통 기술 표준을 마련하기 위해 Meta가 업계 파트너들과 지속적으로 협력하는 이유입니다. 어떤 콘텐츠가 AI로 제작되었다는 신호를 감지할 수 있게 되면, Facebook과 Instagram, Threads의 이용자들이 플랫폼에 게시하는 AI 생성 이미지에 라벨을 표시할 수 있을 것입니다. Meta는 현재 이러한 기능을 구축 중이며, 앞으로 수개월 내 각 플랫폼에서 지원하는 모든 언어로 적용될 예정입니다. 특히 전 세계적으로 중요한 선거가 많이 치러지는 내년까지 Meta는 이러한 접근 방식을 고수할 예정입니다. 이 기간 동안 사람들이 AI 콘텐츠를 제작하고 공유하는 방식과 어떤 식으로 투명하게 공개하는 것이 가장 적합한지, 그리고 이러한 생성 AI 기술이 어떻게 발전하고 있는지에 대해 더 많이 배울 수 있을 것으로 기대합니다. 이렇게 배운 깨달음은 업계 모범사례는 물론 Meta의 AI 기술 개발 방향성에도 가이드 역할을 해줄 것입니다.

AI 생성 콘텐츠 식별 및 라벨링에 대한 새로운 접근 방식

Meta의 AI 기능을 통해 사실과도 같은 이미지가 생성되면, Meta는 보는 이로 하여금 이 이미지가 AI를 활용해 만들어졌다는 것을 다양한 방식으로 알리고 있습니다. 이미지에 눈에 보이는 표식을 붙이고, 이미지 파일 내에 보이지 않는 워터마크와 메타데이터를 심기도 합니다. 보이지 않는 워터마크와 메타데이터를 함께 사용하면, 보이지 않는 표식의 효과가 보다 확실해지고 다른 플랫폼에서도 해당 이미지가 AI로 생성되었다는 걸 감지할 수 있습니다. 이는 생성형 AI를 책임감 있게 구축하기 위한 Meta의 접근방식 중 중요한 한 부분입니다.

오늘날 AI 생성 콘텐츠는 인터넷 전반에 걸쳐 확산되고 있기 때문에, Meta는 Partnership on AI(PAI)와 같은 포럼에서 동종업계의 타 기업들과 협력하며 AI 생성 콘텐츠를 식별하기 위한 공통 기술 표준 개발에 힘쓰고 있습니다. Meta AI로 만든 이미지에 삽입되는 보이지 않는 표식, 즉 IPTC 메타데이터와 보이지 않는 워터마크,는 PAI이 말하는 모범 사례에 부합합니다.

Meta는 C2PA와 IPTC 기술 표준에 나와있는 “AI 생성” 정보 등 보이지 않는 표식을 대량으로 식별할 수 있는 업계 최고의 도구를 구축해왔습니다. Google, OpenAI, Microsoft, Adobe, Midjourney, Shutterstock 등 다른 플랫폼의 도구로 생성된 이미지에도 메타데이터가 이식되면, Meta는 이를 식별해 AI로 생성되었다는 라벨을 붙일 수 있습니다.

많은 기업들이 자사의 이미지 생성 도구에 AI로 만들었다는 걸 알아챌 수 있는 신호를 포함하기 시작했지만, 오디오와 동영상 콘텐츠를 만드는 AI 도구에는 아직 이러한 신호가 포함되지 않아서 이를 감지하거나 별도의 라벨을 표시할 수가 없습니다. 업계에서 이 기능을 개발하는 동안 Meta는 사람들이 AI 생성 동영상이나 오디오를 공유할 때, 직접 이를 공개할 수 있는 기능을 추가할 계획입니다. 또한 디지털로 제작되거나 변형된, 실제와 같은 영상이나 오디오 콘텐츠를 올릴 때에도 이를 고지하고 라벨을 붙이도록 요구할 계획입니다. 만약 이를 어길 시 제재를 받을 수도 있습니다. 만약 디지털로 만들어지거나 조작된 이미지, 영상, 음성 콘텐츠가 중요한 사안에 대해 대중을 기만할 위험이 높다고 판단될 경우, 더욱 눈에 잘 띄는 라벨을 적용해 사람들로 하여금 더 많은 정보와 맥락을 파악할 수 있도록 지원할 방침입니다.

이러한 접근 방식은 현재의 기술로 구현 가능한 최첨단 방식입니다. 하지만 아직 모든 AI 생성 콘텐츠를 식별할 수 있는 것은 아니며, 보이지 않는 마커를 제거하는 방법도 존재합니다. Meta는 이를 해결하기 위한 다양한 방안을 모색하고 있습니다. 우선, 콘텐츠 내에 보이지 않는 표식이 없을 경우에도 AI 생성 콘텐츠를 자동으로 감지할 수 있는 분류 도구를 개발하기 위해 노력하고 있습니다. 동시에 이용자들이 보이지 않는 워터마크를 제거하거나 변경하기 어렵게 만드는 방법도 모색하고 있습니다. 예를 들어, Meta의 인공지능연구소, FAIR(Fundamental AI Research)는 최근 Stable Signature라는 보이지 않는 워터마킹 기술에 대한 연구 결과를 공유한 바 있습니다. 이는 일부 이미지 생성 도구의 이미지 생성 과정 자체에 워터마킹 메커니즘을 통합시키는 것으로, 오픈소스 모델이 워터마킹 기능을 비활성화하는 것을 방지하는 데 유용할 수 있습니다.

AI 생성 콘텐츠는 향후 몇 년 동안 논쟁의 중심이 될 가능성이 높기 때문에, 이러한 작업은 특히 중요합니다. AI 생성 콘텐츠로 사람들을 속이려는 개인과 조직은 이를 감지하고자 마련된 안전장치를 우회하는 방법을 모색할 것입니다. 이에 업계와 사회 전반에 걸쳐 모두가 한 발 앞서 나갈 수 있는 방법을 계속해서 찾아야 합니다.

이와 동시에 개인은, AI로 생성된 콘텐츠인지 판단할 때 콘텐츠를 공유한 계정이 신뢰할만 한지 확인하거나 부자연스러워 보이는 부분을 찾는 등 여러 사항을 고려하는 것이 중요합니다.

지금은 AI 생성 콘텐츠가 확산되고 있는 초기 단계입니다. 앞으로 몇 년 동안 AI 기술이 더욱 보편화됨에 따라 합성 콘텐츠와 비합성 콘텐츠를 식별하기 위해 무엇을 해야 하고, 또 하지 말아야 할지에 대한 논쟁이 사회 전반에서 벌어질 것입니다. AI로 제작되지 않은 콘텐츠와 AI를 활용해 제작된 콘텐츠를 증명하는 방향으로 업계와 규제당국은 나아갈 수도 있습니다. 오늘 소개하는 내용은 현재 Meta의 플랫폼에서 공유되는 콘텐츠에 적용하기에 적합하다고 판단하는 것들입니다. Meta는 계속해서 이 사안을 지켜보고 학습하면서 접근 방식을 검토해 나갈 것입니다. 또한 업계 파트너들과의 협력을 지속하고, 정부 및 시민사회와도 꾸준히 소통해 나가겠습니다.

양날의 검이 되는 인공지능

Meta의 커뮤니티 규정은 콘텐츠 생성 방식과 무관하게 플랫폼 내 모든 콘텐츠에 동일하게 적용됩니다. 특히 유해한 콘텐츠의 경우, AI를 통해 생성되었는지 여부와 관계없이 이를 감지하고 조치를 취합니다. 그리고 AI는 이러한 유해한 콘텐츠를 발견하는 데 큰 역할을 하고 있습니다.

Meta는 수년 동안 AI 시스템을 통해 이용자를 보호해 왔습니다. 예를 들어, 혐오 발언 또는 Meta 정책에 위반되는 콘텐츠를 감지하고 대응하는 데 AI를 활용하고 있습니다. 이러한 노력 덕분에 Facebook에서 혐오 표현의 확산을 0.01~0.02%(2023년 3분기 기준)로 낮출 수 있었습니다. 즉, 콘텐츠를 10,000번 조회할 때 그 중 혐오 표현이 포함된 콘텐츠는 1~2번에 불과한 것으로 추정하고 있습니다.

Meta는 커뮤니티 정책 집행을 위해 AI 기술을 활용하고 있지만, 같은 목적으로 생성형 AI 도구를 사용하는 데는 한계가 있습니다. 다만 생성형 AI 도구를 통해 유해한 콘텐츠를 더 빠르고 정확하게 삭제할 수 있을 것으로 기대합니다. 또한 선거와 같이 위험이 고조되는 시기에 정책을 시행할 때 유용할 수 있습니다. Meta는 자사의 커뮤니티 규정을 대규모 언어 모델(LLM)에 학습시켜 콘텐츠의 정책 위반 여부를 판단하는 데 도움이 되는 지 실험하고 있습니다. 초기 실험 결과, LLM이 기존 머신 러닝 모델보다 더 나은 성능을 발휘할 수 있는 것을 발견했습니다. 또한, Meta 내부 검토자들이 특정 콘텐츠가 정책을 위반하지 않는다고 확신하는 경우에, LLM을 활용해 해당 콘텐츠를 검토 대기열에서 제거할 수 있습니다. 이를 통해 콘텐츠 검토자들은 규정을 위반할 가능성이 높은 콘텐츠에 더욱 집중할 수 있습니다.

또한 AI 생성 콘텐츠는 Meta의 독립적인 팩트체킹 파트너들로부터 사실 확인을 받을 수 있으며, 사실이 아닌 것으로 확인된 콘텐츠에는 라벨을 적용해 이용자들이 인터넷에서 유사한 콘텐츠를 접할 때 정확한 정보를 얻을 수 있도록 하고 있습니다.

Meta는 지난 십수년간 AI 개발의 선구자 역할을 해왔습니다. 발전과 책임이 함께 할 수 있으며, 함께 해야만 한다는 것을 알고 있습니다. 엄청난 기회의 장을 연 생성형 AI 기술이 투명하고 책임감 있는 방식으로 개발되는 것이 가능하고, 또 필수적이라고 믿습니다. Meta가 AI로 생성된 이미지를 이용자들이 식별해낼 수 있도록 돕고, AI의 가능성의 한계를 공개하는 이유도 여기에 있습니다. 이용자들이 Meta의 도구를 사용하는 방식에서 배우고, 또 개선할 것입니다. 또한 PAI와 같은 포럼을 통해 지속적으로 협력하여 공통의 표준과 보호 장치를 개발해나가겠습니다.