Puntos de interés:

- Estamos haciendo cambios en la forma en que tratamos los contenidos manipulados en Facebook, Instagram y Threads tras el feedback recibido del Consejo asesor de contenido y nuestro proceso de revisión de políticas con encuestas de opinión pública y consultas a expertos.

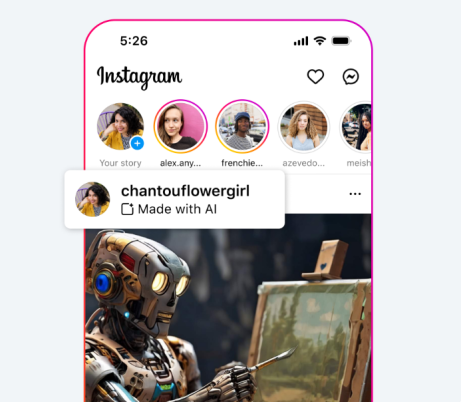

- Empezaremos a etiquetar una gama más amplia de contenidos de vídeo, audio e imagen como «Hecho con IA» cuando detectemos indicadores estándar de imágenes de IA o cuando las personas indiquen que están subiendo contenidos generados con IA.

- Estamos de acuerdo con la recomendación del Consejo asesor de contenido de que proporcionar transparencia y contexto adicional es hoy en día la mejor manera de abordar los contenidos manipulados y evitar el riesgo de restringir innecesariamente la libertad de expresión, por lo que mantendremos este contenido en nuestras plataformas para poder añadir etiquetas y contexto.

Estamos haciendo cambios en la forma en que tratamos los contenidos manipulados en Facebook, Instagram y Threads tras el feedback que recibimos del Consejo asesor de contenido señalando que debemos actualizar nuestro enfoque para reflejar una gama más amplia del contenido que existe hoy en día y proporcionar contexto sobre el contenido a través de etiquetas. Estos cambios también se basan en el proceso de revisión de la política de Meta, que incluyó encuestas de opinión pública extensas y consultas con académicos, organizaciones de la sociedad civil entre otros.

Estamos de acuerdo con el argumento del Consejo asesor de contenido que sostiene que nuestro enfoque actual es demasiado limitado, ya que solo cubre los videos creados o alterados por IA que hacen parecer que una persona dice algo que no ha dicho. Nuestra política sobre contenidos manipulados se redactó en 2020, cuando los contenidos realistas generados por IA eran escasos y la preocupación general se centraba en los videos. En los últimos cuatro años, y especialmente en el último, se han desarrollado otros tipos de contenidos realistas generados por IA, como audio y fotos, y esta tecnología está evolucionando rápidamente. Como señaló el Consejo, es igualmente importante abordar la manipulación que muestra a una persona haciendo algo que no ha hecho.

El Consejo también argumentó que nos arriesgamos innecesariamente a restringir la libertad de expresión cuando eliminamos medios manipulados que no infringen nuestras Normas comunitarias. Recomendó un enfoque «menos restrictivo» para los contenidos manipulados, como las etiquetas con contexto. En febrero, anunciamos que hemos estado trabajando con socios de la industria en normas técnicas comunes para identificar contenidos de IA, incluidos video y audio. Nuestras etiquetas «Hecho con IA» en video, audio e imágenes generados por IA se basarán en nuestra detección de señales de imágenes de IA y en si las personas indican que están subiendo contenidos generados por IA. Ya añadimos «Imaginado con IA» a las imágenes fotorrealistas creadas con nuestra función Meta AI.

Estamos de acuerdo en que ofrecer transparencia y contexto adicional es ahora la mejor manera de abordar estos contenidos. Las etiquetas abarcarán una gama más amplia de contenidos, además de los contenidos manipulados que el Consejo recomendó etiquetar. Si determinamos que una imagen, un video o un audio creados o alterados digitalmente representan un riesgo particularmente alto de engañar materialmente al público sobre un asunto de importancia, podremos añadir una etiqueta más destacada para que la gente tenga más información y contexto. Este enfoque global proporciona a las personas más información sobre el contenido para que puedan evaluarlo mejor y para que tengan más contexto si ven el mismo contenido en otro lugar.

Por tanto, mantendremos este contenido en nuestras plataformas para poder añadir etiquetas informativas y contexto, a menos que el contenido infrinja de otro modo nuestras políticas. Pero seguiremos eliminando contenidos, independientemente de que hayan sido creados por IA o por una persona, si estos infringen nuestras Normas Comunitarias. También contamos con una red de casi 100 verificadores de datos independientes que seguirán revisando los contenidos falsos y engañosos generados por IA. Cuando los verificadores de datos califican un contenido como Falso o Alterado, lo mostramos más abajo en el Feed para que lo vea menos gente, y añadimos una etiqueta superpuesta con información adicional. Además, rechazamos anuncios cuando incluyen contenido desacreditado y, desde enero, los anunciantes tienen que indicar cuando crean o alteran digitalmente un anuncio político o social en determinados casos.

Tenemos previsto empezar a etiquetar los contenidos generados por IA en mayo de 2024, y en julio dejaremos de eliminar contenidos basándonos únicamente en nuestra política de videos manipulados. De este modo, las personas tendrán tiempo de comprender el proceso para auto etiquetar contenido antes de que dejemos de aplicar nuestra política de videos manipulados.

Informe de Proceso de políticas sustentado en opiniones de expertos mundiales y encuestas públicas

En la primavera de 2023, empezamos a reevaluar nuestras políticas para ver si necesitábamos un nuevo enfoque para seguir el ritmo de los rápidos avances tecnológicos y el uso de la IA generativa. Consultamos a más de 120 partes interesadas en 34 países de las principales regiones del mundo. En general, recibimos un amplio apoyo para etiquetar los contenidos generados por IA y un fuerte respaldo a una etiqueta más prominente en escenarios de alto riesgo. Muchas partes interesadas se mostraron receptivas al concepto de que las personas revelen por sí mismas los contenidos generados por IA.

La mayoría de las partes interesadas coincidieron en que la eliminación debería limitarse únicamente a los casos de mayor riesgo en los que el contenido pueda estar vinculado a un daño, ya que la IA generativa se está convirtiendo en una herramienta de expresión creativa de uso generalizado. Esto está alineado con los principios en los que se basan nuestras Normas Comunitarias: que las personas sean libres de expresarse y, al mismo tiempo, estén seguras en nuestras plataformas.

También realizamos un estudio de opinión pública con más de 23.000 encuestados en 13 países y preguntamos a la gente cómo deberían abordar las empresas como Meta los contenidos generados por IA en sus plataformas. Una gran mayoría (82%) está a favor de las etiquetas de advertencia para los contenidos generados por IA que muestran a personas diciendo cosas que no han dicho.

Además, el Consejo señaló que sus recomendaciones se basan en consultas con organizaciones de la sociedad civil, académicos, organizaciones intergubernamentales y otros expertos.

Basándonos en los comentarios de los expertos y del público, estamos tomando medidas que consideramos adecuadas para plataformas como las nuestras. Queremos ayudar a la gente a saber cuándo se han creado o editado imágenes fotorrealistas utilizando IA, por lo que seguiremos colaborando con colegas del sector a través de foros como Partnership on AI y mantendremos un diálogo constante con los gobiernos y la sociedad civil, y seguiremos revisando nuestro enfoque a medida que avance la tecnología.