Puntos de interés:

- Desde su lanzamiento, hemos etiquetado las imágenes fotorrealistas creadas con Meta AI para que la gente sepa que están “Imagined with AI”

- Estamos trabajando con socios del sector en normas técnicas comunes para identificar contenidos de IA, incluidos vídeo y audio.

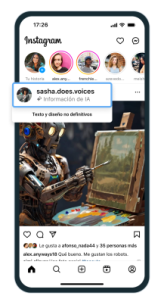

- En los próximos meses, etiquetaremos las imágenes que los usuarios publiquen en Facebook, Instagram y Threads cuando detectemos indicadores estándar del sector que indiquen que han sido generadas con IA.

Como empresa que lleva más de una década a la vanguardia del desarrollo de la IA, ha sido enormemente alentador ser testigo de la explosión de creatividad de las personas que utilizan nuestras nuevas herramientas de IA generativa, como nuestro generador de imágenes Meta AI, que ayuda a las personas a crear imágenes con simples indicaciones de texto.

A medida que se desdibuja la frontera entre el contenido humano y el artificial, la gente quiere saber dónde está el límite. Para muchas personas, es la primera vez que se encuentra con contenidos generados por IA y son muchos los usuarios que nos dicen que aprecian la transparencia en torno a esta nueva forma de contenido. Por eso es importante que ayudemos a la gente a saber cuándo un contenido fotorrealista ha sido creado con IA. Para ello, aplicamos la etiqueta “Imagined with AI” a las imágenes fotorrealistas creadas con nuestra función Meta AI, pero queremos poder hacerlo también con los contenidos creados con herramientas de otras empresas.

Por eso hemos estado trabajando con socios del sector para armonizar normas técnicas comunes que indiquen cuándo un contenido se ha creado con IA. La detección de estas señales nos permitirá etiquetar las imágenes generadas por IA que los usuarios publiquen en Facebook, Instagram y Threads. Estamos desarrollando esta capacidad y en los próximos meses empezaremos a aplicar etiquetas en todos los idiomas que admite cada aplicación. Adoptaremos este enfoque a lo largo del próximo año, durante el cual tendrán lugar varias citas electorales importantes en todo el mundo. Durante este tiempo, esperamos aprender mucho más sobre cómo la gente crea y comparte contenidos de IA, qué tipo de transparencia considera más valiosa y cómo evolucionan estas tecnologías. Lo que aprendamos servirá de base para mejores prácticas dentro del sector y a nuestro propio enfoque de cara al futuro.

Un nuevo enfoque para identificar y etiquetar los contenidos generados por IA

Cuando se crean imágenes fotorrealistas con nuestra función Meta AI, hacemos varias cosas para asegurarnos de que la gente sepa que la IA está involucrada, incluyendo la colocación de marcadores visibles que se pueden ver en las imágenes, así como marcas de agua invisibles y metadatos incrustados dentro de los archivos de imagen. El uso de marcas de agua invisibles y metadatos mejora la solidez de estos marcadores invisibles y ayuda a otras plataformas a identificarlos. Esta es una parte importante del enfoque responsable que estamos adoptando para crear funciones de IA generativa.

Dado que los contenidos generados por IA aparecen en todo Internet, hemos estado trabajando con otras empresas de nuestro sector para desarrollar normas comunes que permitan identificarlos a través de foros como el Partnership on AI (PAI). Los marcadores invisibles que utilizamos para las imágenes Meta AI (metadatos IPTC y marcas de agua invisibles) se ajustan a las mejores prácticas de la PAI.

Estamos creando herramientas líderes en el sector que son capaces de identificar marcadores invisibles a escala, en concreto, la información «generada por IA» de las especificaciones técnicas C2PA e IPTC. Por lo tanto, podemos etiquetar imágenes de Google, OpenAI, Microsoft, Adobe, Midjourney y Shutterstock a medida que ponen en marcha sus planes para añadir metadatos a las imágenes creadas por sus herramientas.

Aunque las empresas están empezando a incluir señales en sus generadores de imágenes, no han empezado a incluirlas en las herramientas de IA que generan audio y vídeo al mismo nivel, por lo que aún no podemos detectar estas señales y etiquetar este tipo de contenido de otras empresas. Mientras el sector se esfuerza por conseguirlo, vamos a añadir una función para que los usuarios nos informen cuando vayan a compartir vídeos o audios generados por IA, de tal manera que podamos añadirles una etiqueta. Además, les pediremos que utilicen esta herramienta de divulgación y etiquetado cuando publiquen como contenido orgánico un vídeo fotorrealista o un sonido realista que haya sido creado o alterado digitalmente, y podremos aplicar sanciones si no lo hacen. Si determinamos que el contenido de imagen, vídeo o audio creado o alterado digitalmente tiene un riesgo particularmente alto de engañar sustancialmente al público sobre un asunto de importancia, podremos añadir una etiqueta más visible, si es necesario, para que las personas tengan más información y contexto.

Este enfoque representa lo último dentro de lo que es técnicamente posible ahora mismo. Pero aún no es posible identificar todos los contenidos generados por IA, y hay formas de eliminar los marcadores invisibles. Por esta razón, estamos estudiando varias opciones. Estamos trabajando duro para desarrollar clasificadores que nos ayuden a detectar automáticamente los contenidos generados por IA, aunque carezcan de marcadores invisibles. Al mismo tiempo, estamos buscando formas de dificultar la eliminación o alteración de las marcas de agua invisibles. Por ejemplo, FAIR, el laboratorio de investigación sobre la IA de Meta, ha presentado recientemente una investigación sobre una tecnología que estamos desarrollando sobre marcas de agua invisibles llamada Stable Signature. Esta tecnología integra el mecanismo de marca de agua directamente en el proceso de generación de imágenes para algunos tipos de generadores de imágenes, lo que podría ser de gran utilidad para los modelos de código abierto, ya que la marca de agua no se puede desactivar.

Este trabajo es especialmente importante, ya que es probable que en los próximos años se convierta en un espacio cada vez más conflictivo. Las personas y organizaciones que quieran engañar activamente a la gente con contenidos generados por IA buscarán formas de evitar las protecciones que se establezcan para detectarlo. En nuestro sector y en la sociedad en general, tendremos que seguir buscando formas de ir un paso por delante.

Mientras tanto, es importante que la gente tenga en cuenta varias cosas a la hora de determinar si el contenido ha sido creado por IA, como comprobar si la cuenta que comparte el contenido es de confianza o buscar detalles que puedan parecer o sonar forzado.

Este es el inicio de la difusión de contenidos generados por inteligencia artificial. A medida que se generalicen en los próximos años, la sociedad debatirá sobre lo que debe y no debe hacerse para identificar los contenidos artificiales y los no artificiales. Es posible que la industria y los reguladores busquen formas de autenticar tanto los contenidos que no se han creado con IA como los que sí. Lo que exponemos hoy son los pasos que consideramos apropiados para los contenidos compartidos en nuestras plataformas en este momento. Pero seguiremos observando y aprendiendo, y seguiremos revisando continuamente nuestro enfoque. También seguiremos colaborando con nuestros compañeros del sector. Y seguiremos dialogando con los gobiernos y la sociedad civil.

La IA es a la vez una espada y un escudo

Nuestras normas comunitarias se aplican a todos los contenidos publicados en nuestras plataformas, independientemente de cómo se hayan creado. Cuando se trata de contenido dañino, lo más importante es que seamos capaces de detectarlo y tomar medidas independientemente de si se ha generado o no utilizando IA. Y el uso de la IA en nuestros sistemas de seguridad es una parte importante de lo que nos permite detectarlos.

Llevamos años utilizando sistemas de IA para ayudar a proteger a nuestros usuarios. Por ejemplo, utilizamos la IA para ayudarnos a detectar y abordar el discurso de odio y otros contenidos que infringen nuestras políticas. Esta es en gran parte la razón por la que hemos sido capaces de reducir la prevalencia de los discursos de odio en Facebook a solo el 0,01-0,02% (a partir del tercer trimestre de 2023). En otras palabras, por cada 10.000 visualizaciones de contenido, calculamos que solo una o dos incluyen discursos de odio.

Aunque utilizamos tecnología de IA para ayudar a hacer cumplir nuestras políticas, nuestro uso de herramientas de IA generativa para este fin ha sido limitado. Pero somos optimistas en cuanto a que la IA generativa podría ayudarnos a retirar contenidos nocivos con mayor rapidez y precisión. También podría ser útil para hacer cumplir nuestras políticas en momentos de mayor riesgo como las elecciones.

Hemos empezado a probar grandes modelos lingüísticos (LLM) entrenándolos con nuestras normas comunitarias para ayudarnos a determinar si un contenido infringe nuestras políticas. Estas pruebas iniciales sugieren que los LLM pueden funcionar mejor que los modelos de aprendizaje automático existentes. También estamos utilizando los LLM para eliminar contenidos de las listas de revisión en determinadas circunstancias, cuando estamos seguros de que no infringen nuestras políticas. Esto libera capacidad para que nuestros revisores se centren en los contenidos que tienen más probabilidades de incumplir nuestras normas.

Los contenidos generados por IA también pueden ser verificados por nuestros socios independientes y etiquetamos los contenidos desacreditados para que la gente disponga de información precisa cuando encuentre contenidos similares en Internet.

Meta es pionera en el desarrollo de IA desde hace más de una década. Sabemos que el progreso y la responsabilidad pueden y deben ir de la mano. Las herramientas de IA generativa ofrecen enormes oportunidades, y creemos que es posible y necesario que estas tecnologías se desarrollen de forma transparente y responsable. Por eso queremos ayudar a la gente a saber cuándo se han creado imágenes fotorrealistas con IA, y por eso también somos abiertos sobre los límites de lo posible. Seguiremos aprendiendo de cómo la gente utiliza nuestras herramientas para mejorarlas. Y seguiremos colaborando con los demás actores a través de foros como PAI para desarrollar normas y barandillas comunes.