Guy Rosen, vicepresidente de integridad de Facebook

Hoy publicamos nuestro tercer Informe de cumplimiento de las Normas Comunitarias, en el que analizamos el cuarto trimestre de 2018 y el primer trimestre de 2019. En este informe se añaden algunos datos adicionales:

Novedades de la tercera edición

- Datos sobre apelaciones y contenido restaurado: por primera vez, incluimos cuánto contenido han apelado las personas y cuánto contenido se ha restaurado después de haber tomado medidas.

- Datos sobre bienes regulados: además de los ámbitos de las ocho políticas que se analizaron en la segunda edición del informe (noviembre de 2018), ahora detallamos cómo eliminamos los intentos de ventas ilegales de bienes regulados, en concreto, la venta de armas de fuego y drogas.

En total, ahora incluimos resultados de nueve políticas de nuestras Normas Comunitarias: desnudos y actividad sexual de adultos, bullying y acoso, desnudos y explotación sexual de menores, cuentas falsas, lenguaje que incita al odio, bienes regulados, spam, propaganda terrorista global, y violencia y contenido gráfico.

Cómo interpretar los números

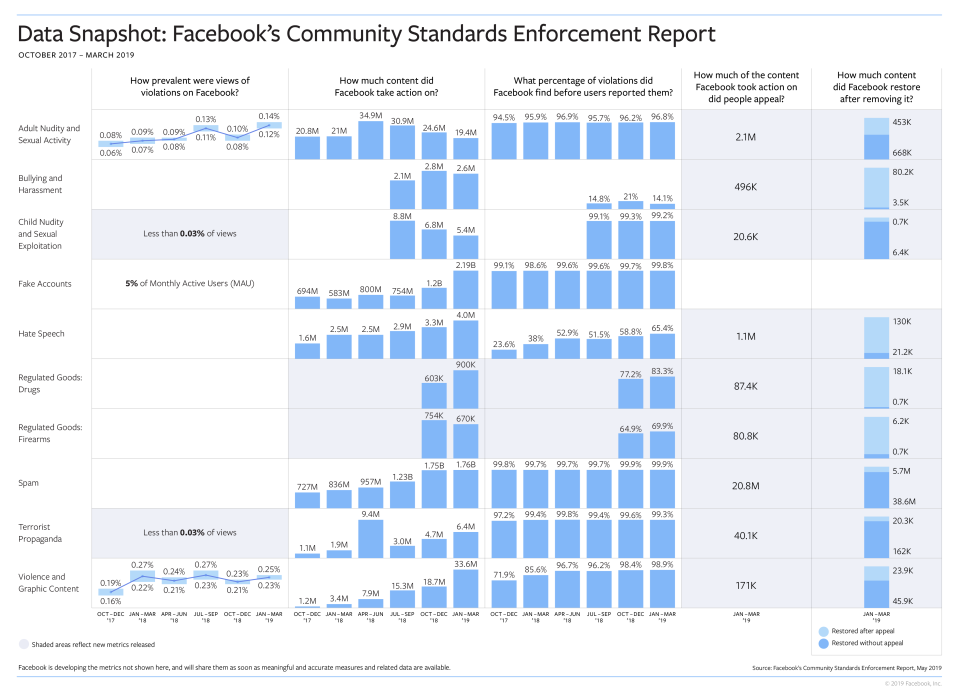

La finalidad de los resultados principales de nuestro informe, que se incluyen a continuación, es realizar el seguimiento de cómo aplicamos las Normas comunitarias:

Prevalencia: frecuencia con la que se ha visto el contenido que infringe las Normas Comunitarias. Nos importa más la frecuencia con la que alguien ve en realidad el contenido que infringe nuestras políticas. Mientras que el contenido en el que se han tomado medidas describe cuánto contenido hemos eliminado, la prevalencia detalla cuánto contenido que las personas podrían ver y que aún no hemos identificado. Para medirlo, hacemos un muestreo periódico del contenido visualizado en Facebook y, a continuación, lo revisamos para comprobar qué porcentaje infringe nuestras normas.

Este resultado está disponible actualmente para las categorías de desnudos y actividad sexual de adultos, violencia y contenido gráfico, y cuentas falsas.

- Estimamos que, de cada 10.000 veces que las personas han visto contenido en Facebook, entre 11 y 14 visualizaciones incluían contenido que infringía nuestra política de desnudos y actividad sexual de adultos.

- Estimamos que, de cada 10.000 veces que las personas vieron contenido en Facebook, 25 visualizaciones incluían contenido que infringía nuestra política de violencia y contenido gráfico.

- En el caso de las cuentas falsas, estimamos que el 5 % de las cuentas activas por mes son falsas.

En este informe, también compartimos por primera vez el resultado de la prevalencia de las categorías de terrorismo global y desnudos y explotación sexual de menores. La prevalencia de ambos ámbitos es demasiado baja para medirla con nuestros mecanismos estándar, pero podemos estimar que en el primer trimestre de 2019, de cada 10.000 veces que las personas han visto contenido en Facebook, menos de tres visualizaciones incluían contenido que infringía alguna de esas políticas.

Seguimos desarrollando resultados de prevalencia para los ámbitos de las políticas que incluimos en el informe. Puedes obtener más información sobre cómo medimos la prevalencia aquí.

Contenido en el que se han tomado medidas: en cuánto contenido hemos tomado medidas porque infringía nuestras Normas Comunitarias. Entre nuestras medidas se incluyen la eliminación del contenido, el uso de una pantalla de advertencia del contenido o la inhabilitación de cuentas. En los datos se refleja cuánto contenido publican las personas que infringe nuestras políticas y cómo podemos identificarlo.

En el caso de las cuentas falsas, el número de cuentas en las que hemos tomado medidas ha aumentado debido a los ataques automatizados de agentes malintencionados que han intentado crear grandes volúmenes de cuentas a la vez. Inhabilitamos 1.200 millones de cuentas en el cuarto trimestre de 2018 y 2190 millones en el primer trimestre de 2019. La mayoría de estas cuentas fueron bloqueadas a escasos minutos de su creación, antes de que pudieran causar daño, y fueron eliminadas tan rápido que no llegaron a considerarse cuentas activas. Continuaremos buscando nuevas formas de detectar intentos de violar nuestras políticas y nuestro Vicepresidente en el área de Analíticas, Alex Schultz, explica más sobre cómo abordamos el problema de las cuentas falsas, en un nuevo blog de Preguntas Difíciles que hemos compartido hoy.

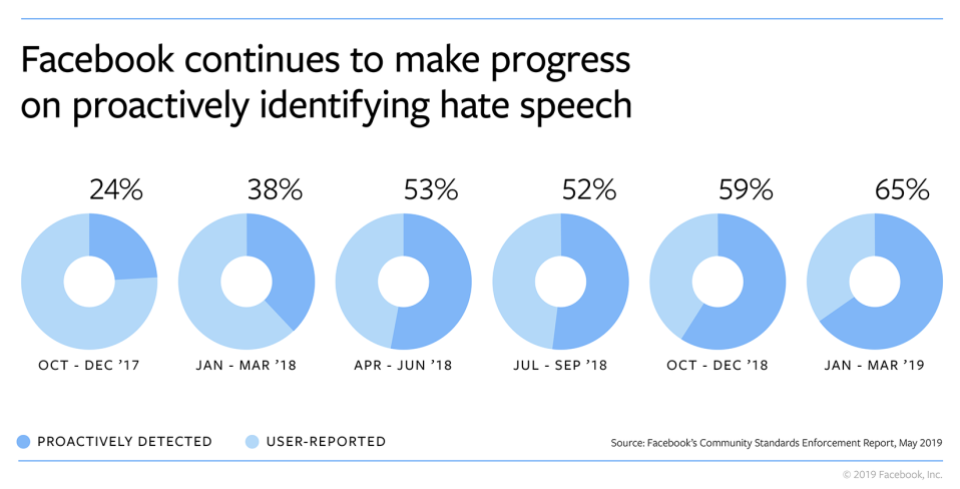

Porcentaje proactivo: del contenido en el que hemos tomado medidas; cuánto han detectado nuestros sistemas antes de que alguien lo denunciara. Este resultado suele reflejar la eficacia de la IA en un ámbito concreto de nuestra política.

En seis de los ámbitos de la política que incluimos en este informe, hemos detectado de forma proactiva más del 95 % del contenido en el que hemos tomado medidas antes de que alguien lo tuviera que denunciar. En el caso del lenguaje que incita al odio, ahora detectamos el 65 % del contenido que eliminamos, lo que supone un aumento desde el 24 % de hace más de un año cuando compartimos por primera vez nuestras medidas. En el primer trimestre de 2019, hemos eliminado cuatro millones de publicaciones con lenguaje que incita al odio y seguimos invirtiendo en esta tecnología y ampliando nuestras capacidades para detectar este contenido en diferentes idiomas y regiones.

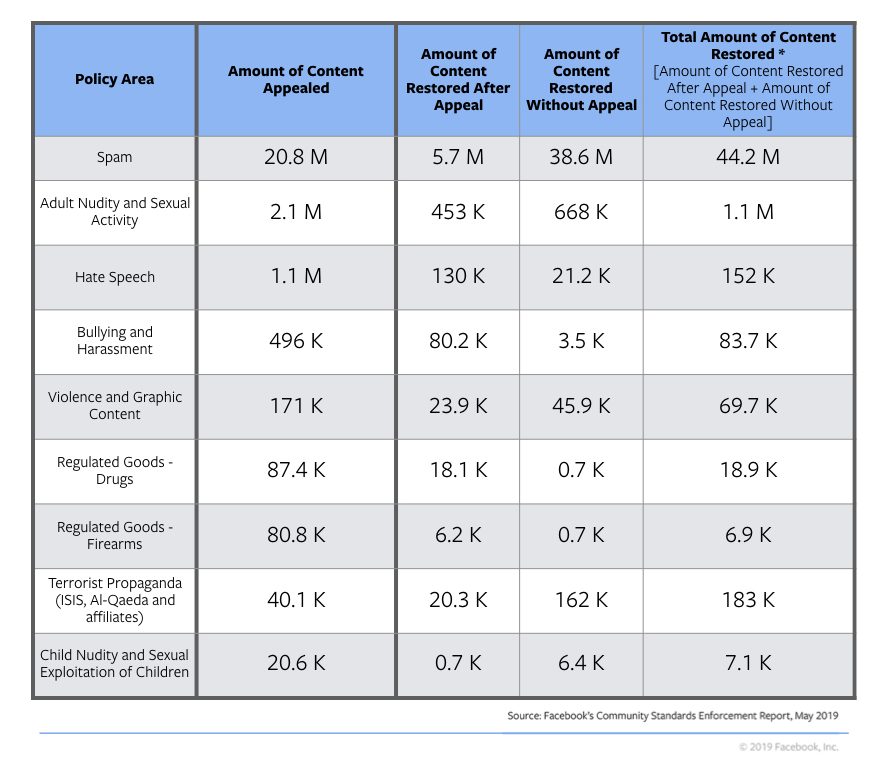

Novedades de este informe: apelaciones y corrección de nuestros errores

Cuando tomamos medidas en un contenido, informamos a la persona que lo ha publicado y, en la mayoría de los casos, le ofrecemos la posibilidad de indicarnos si considera que nos hemos equivocado. En la tercera edición del informe, hemos empezado a publicar datos sobre cuánto contenido han apelado las personas y cuánto contenido se ha restaurado después de haber tomado medidas.

Nuestra forma de actuar no es perfecta y, en cuanto detectamos que nos hemos equivocado, trabajamos para solucionarlo. Por ello, incluimos cuánto contenido hemos restaurado después de que se apelara, así como cuánto contenido hemos restaurado por nuestra cuenta, incluso cuando no se había apelado directamente. Restauramos el contenido sin necesidad de que haya una apelación por las siguientes razones, entre otras:

- Si nos hemos equivocado al eliminar varias publicaciones del mismo contenido, podemos usar la apelación de nuestra decisión de una persona para restaurar todas las publicaciones.

- A veces, identificamos un error en nuestra revisión y restauramos el contenido antes de que la persona que lo ha publicado apele.

- En otras ocasiones, sobre todo en casos de spam, si eliminamos publicaciones que contienen enlaces que identificamos como malintencionados, podemos restaurarlas si averiguamos que el enlace ya no es dañino.

En el informe incluimos esta información relativa al primer trimestre de 2019 de todos los ámbitos de la política, excepto de las cuentas falsas:

La “cantidad de contenido que se ha apelado” en un trimestre no se puede comparar directamente con la “cantidad de contenido que se ha restaurado” en el mismo trimestre, ya que el contenido que se ha restaurado en el primer trimestre de 2019 puede haberse apelado en el cuarto trimestre de 2018. Del mismo modo, puede que se tomaran medidas en el cuarto trimestre de 2018 sobre la “cantidad de contenido que se ha apelado” en el primer trimestre de 2019.

Puedes obtener más información sobre cómo funciona el proceso de apelación aquí.

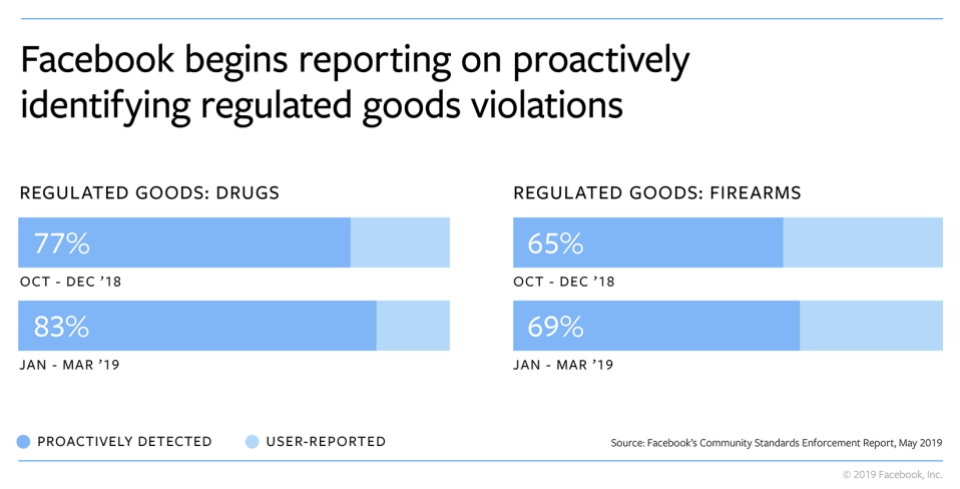

Novedades de este informe: datos sobre bienes regulados

Tenemos políticas antiguas contra las ventas de armas de fuego y drogas ilegales. Durante años, hemos usado una variedad de enfoques para aplicar nuestra política, por ejemplo: investigar perfiles, páginas, grupos, cuentas y hashtags asociados con contenido que infringía las normas y que ya habíamos eliminado; bloquear y filtrar cientos de términos asociados con la venta de drogas; y trabajar con expertos para mantenernos al día en relación con las tácticas más recientes que utilizan los agentes malintencionados para enmascarar su actividad (por ejemplo, las nuevas denominaciones populares de las drogas).

En el verano de 2018, empezamos a utilizar la IA para identificar contenido que infringía nuestras políticas sobre bienes regulados. Esta inversión nos ha permitido tomar medidas en más contenido y, en la mayoría de los casos, hacerlo antes de que las personas lo denunciaran. En el primer trimestre de 2019, hemos tomado medidas en aproximadamente 900 000 ocasiones por contenidos de venta de drogas, de los cuales detectamos de forma proactiva el 83,3 %. Durante el mismo período, hemos tomado medidas aproximadamente 670.000 veces por contenidos de venta de armas de fuego, de los cuales detectamos de forma proactiva el 69,9 %.

Al encontrar más publicaciones que infringen las políticas de forma proactiva, esta tecnología permite a nuestro equipo centrar su trabajo en detectar las próximas tendencias que intentarán los agentes malintencionados para eludir nuestra detección.

Nuestro compromiso con la transparencia

Durante el año pasado, llevamos a cabo una serie de medidas para ser más transparentes en relación con el modo en que desarrollamos nuestras políticas y cómo medimos nuestros esfuerzos para aplicarlas. En relación con nuestras políticas, empezamos a compartir los minutos de nuestra reunión quincenal, donde determinamos las actualizaciones de nuestras políticas. Asimismo, ahora facilitamos un registro de cambios en el sitio web de las Normas comunitarias para que cada mes todos puedan ver qué hemos actualizado exactamente en nuestras políticas. Además, como parte de nuestras medidas para facilitar la investigación académica, vamos a conceder becas a 19 propuestas de investigación de todo el mundo para estudiar nuestras políticas de contenido y cómo influye el contenido que hay en internet en los acontecimientos fuera de internet.

Las aportaciones y los comentarios externos independientes son un componente fundamental sobre cómo mejoramos. Con esa intención, establecimos el Data Transparency Advisory Group (DTAG) para proporcionar una evaluación independiente y pública sobre si los resultados que compartimos en el Informe de cumplimiento de las Normas comunitarias son significativos y precisos en relación con nuestro trabajo. Este cuerpo independiente está compuesto por expertos internacionales en medición, estadísticas, criminología y gestión para evaluar nuestra metodología. Hemos proporcionado a este grupo información detallada y confidencial sobre nuestros procesos de aplicación y metodologías de medición, y esta semana han publicado su evaluación independiente. En su evaluación, el grupo ha indicado que el Informe de cumplimiento de las Normas comunitarias es un ejercicio importante de transparencia y que les parece que nuestro enfoque y metodología son firmes y razonables. Asimismo, han destacado otras áreas en las que podríamos ser más abiertos a la hora de dar más responsabilidad y capacidad de respuesta a las personas que utilizan nuestra plataforma. Estas estadísticas, de importancia demostrada nos ayudarán a orientar nuestro trabajo en el futuro.

Seguiremos aportando más transparencia a nuestro trabajo e incluyendo más información sobre nuestros esfuerzos, de modo que las personas puedan ver lo que progresamos y nos pida responsabilidades en las áreas en las que tengamos que tomar más medidas.

Puedes leer el informe completo aquí y ver la guía aquí.