Na última década, o laboratório Fundamental Artificial Intelligence Research da Meta, em Paris, tem estado na vanguarda do avanço da pesquisa científica. Lideramos avanços na medicina, ciência climática e conservação, e mantivemos nosso compromisso com a ciência aberta e reproduzível. Ao olharmos para a próxima década, nosso foco é alcançar a inteligência avançada de máquina (AMI, na sigla em inglês) e usá-la para impulsionar produtos e inovação para o benefício de todos.

Hoje, em colaboração com o Basque Center on Cognition, Brain and Language, um importante centro de pesquisa interdisciplinar de San Sebastian, na Espanha, estamos animados em compartilhar duas descobertas que mostram como a IA pode ajudar a avançar nossa compreensão da inteligência humana, nos levando mais perto da AMI. Com base em nosso trabalho anterior para decodificar a percepção de imagens e fala da atividade cerebral, estamos compartilhando pesquisas que decodificam com sucesso a produção de frases a partir de gravações cerebrais não invasivas, decodificando com precisão até 80% dos caracteres e, portanto, frequentemente reconstruindo frases completas apenas a partir de sinais cerebrais. Em um segundo estudo, estamos detalhando como a IA também pode ajudar a entender esses sinais cerebrais e esclarecendo como o cérebro transforma efetivamente os pensamentos em uma sequência de palavras.

O avanço dessa importante pesquisa não seria possível sem a colaboração próxima que promovemos na comunidade de neurociência. Hoje, a Meta está anunciando uma doação de US$ 2,2 milhões para a Rothschild Hospital Foundation em apoio a esse trabalho que segue em estreita colaboração com algumas das principais instituições de pesquisa na Europa, incluindo NeuroSpin (CEA), INRIA, ENS PSL e CNRS. Essas parcerias continuarão sendo importantes para nós enquanto trabalhamos juntos para explorar como essas descobertas podem fazer a diferença no mundo real e, finalmente, melhorar a vida das pessoas.

Usando IA para decodificar a linguagem de gravações não invasivas do cérebro

Todos os anos, milhões de pessoas sofrem de lesões cerebrais que podem impedi-las de se comunicar. As abordagens atuais mostram que a comunicação pode ser restaurada com uma neuroprótese alimentando sinais de comando para um decodificador de IA. No entanto, técnicas invasivas de gravação cerebral, como eletroencefalografia estereotáxica e eletrocorticografia, exigem intervenções neurocirúrgicas e são difíceis de escalar. Até agora, o uso de abordagens não invasivas têm sido tipicamente limitado pela complexidade do ruído dos sinais que elas registram.

Para nosso primeiro estudo, usamos MEG e EEG –– dispositivos não invasivos que medem os campos magnéticos e elétricos provocados pela atividade neuronal –– para registrar, no BCBL, 35 voluntários saudáveis enquanto eles digitam frases. Em seguida, treinamos um novo modelo de IA para reconstruir a frase apenas a partir dos sinais cerebrais. Em novas frases, nosso modelo de IA decodifica até 80% dos caracteres digitados pelos participantes registrados com MEG, pelo menos duas vezes melhor do que o que pode ser obtido com o sistema clássico de EEG.

Esta pesquisa pode criar um novo caminho para interfaces cérebro-computador não invasivas para ajudar a restaurar a comunicação daqueles que perderam a capacidade de falar, mas vários desafios importantes permanecem antes que esta abordagem possa ser aplicada em ambientes clínicos. O primeiro é relacionado ao desempenho: o desempenho de decodificação ainda é imperfeito. O segundo é mais prático – o MEG requer que os sujeitos estejam em uma sala blindada magneticamente e permaneçam imóveis. Finalmente, embora esta pesquisa tenha sido feita em voluntários saudáveis, trabalhos futuros precisarão ser feitos para explorar como ela pode beneficiar pessoas que sofrem de lesões cerebrais.

Usando IA para entender como o cérebro forma a linguagem

Também estamos compartilhando um avanço para entender os mecanismos neurais que coordenam a produção da linguagem no cérebro humano. Estudar o cérebro durante a fala sempre se mostrou extremamente desafiador para a neurociência, em parte por causa de um problema técnico simples: mover a boca e a língua corrompe fortemente os sinais de neuroimagem.

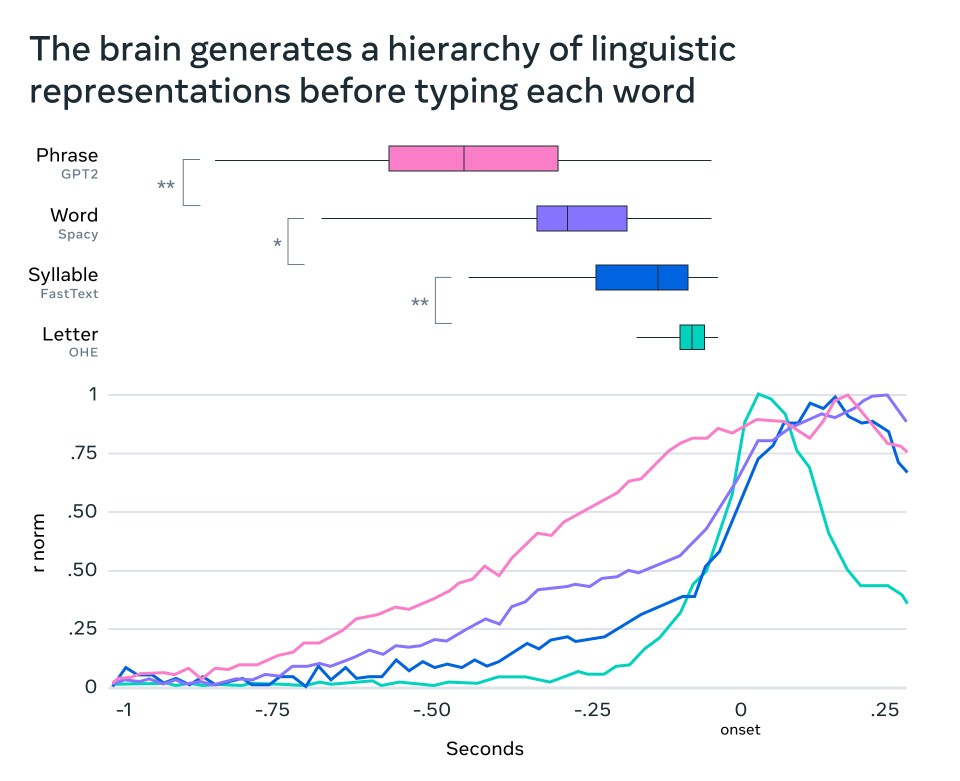

Para explorar como o cérebro transforma pensamentos em sequências complexas de ações motoras, usamos IA para ajudar a interpretar os sinais MEG enquanto os participantes digitavam. Ao tirar 1.000 instantâneos do cérebro a cada segundo, podemos identificar o momento preciso em que os pensamentos são transformados em palavras, sílabas e até mesmo letras individuais. Nosso estudo mostra que o cérebro gera uma sequência de representações que começam no nível mais abstrato de representações — o significado de uma frase — e as transformam progressivamente em uma miríade de ações, como o movimento real dos dedos no teclado.

É importante ressaltar que o estudo também revela como o cérebro representa de forma coerente e simultânea palavras e ações sucessivas. Nossos resultados mostram que o cérebro usa um “código neural dinâmico” – um mecanismo neural especial que encadeia representações sucessivas, mantendo cada uma delas por longos períodos de tempo.

Decifrar o código neural da linguagem continua sendo um dos maiores desafios da IA e da neurociência. A capacidade de linguagem, que é específica dos humanos, dotou nossa espécie com uma habilidade de raciocinar, aprender e acumular conhecimento como nenhum outro animal no planeta. Entender sua arquitetura neural e seus princípios computacionais é, portanto, um caminho importante para o desenvolvimento da AMI.

Possibilitando avanços na saúde com enfoque de IA aberta

Na Meta, estamos em uma posição única para ajudar a resolver alguns dos maiores desafios do mundo usando IA. Nosso compromisso com o enfoque aberto para IA permitiu que a comunidade de IA se baseasse em nossos modelos para alcançar seus próprios avanços. No mês passado, compartilhamos como a BrightHeart, uma empresa sediada na França, está usando o DINOv2 como parte de seu software de IA para ajudar os médicos a identificar ou descartar sinais sugestivos de defeitos cardíacos congênitos em ultrassons cardíacos fetais. No ano passado, a BrightHeart obteve a liberação 510(k) do FDA para seu software, que atribui em parte às contribuições com enfoque aberto da Meta. Também compartilhamos como a Virgo, uma empresa sediada nos Estados Unidos, está usando o DINOv2 para analisar vídeos de endoscopia, alcançando desempenho de última geração em uma ampla gama de benchmarks de IA para o setor, como classificação de marcos anatômicos, pontuação de gravidade da doença para colite ulcerativa e segmentação de pólipos.

Ao olharmos para os próximos dez anos, é animador pensar em como os avanços que compartilhamos hoje podem beneficiar o bem maior. Estamos ansiosos para continuar as conversas importantes que estamos tendo com a comunidade à medida que avançamos — juntos — para enfrentar alguns dos maiores desafios da sociedade.