Atualizado em 12 de setembro de 2024

Em breve lançaremos uma mudança nos rótulos de “Informações de IA” em nossas plataformas para que reflitam melhor a extensão da IA usada no conteúdo. Nossa intenção sempre foi ajudar as pessoas a saber quando veem conteúdo feito com IA, e continuamos a trabalhar com empresas de todo o setor para melhorar nosso processo de marcação, para que os rótulos em nossas plataformas estejam mais alinhados com as expectativas das pessoas.

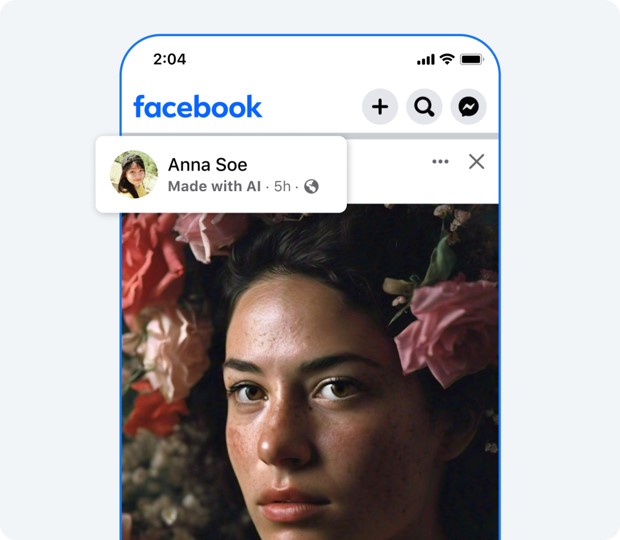

Para conteúdo que detectamos ter sido modificado ou editado apenas por ferramentas de IA, moveremos o rótulo “Informações de IA” para o menu da postagem. Ainda exibiremos o rótulo “Informações de IA” para o conteúdo que detectarmos ter sido gerado por uma ferramenta de IA e compartilharemos se o conteúdo é rotulado devido a sinais compartilhados pela indústria ou porque alguém se auto-declarou. Essas mudanças começarão a partir da próxima semana.

Atualizado em 01 de julho de 2024

Queremos que as pessoas saibam quando estão diante de postagens feitas com Inteligência Artificial. No início deste ano, anunciamos uma nova abordagem para rotular conteúdo gerado por IA. Uma parte dela se baseia em indicadores padrão da indústria que outras empresas incluem no conteúdo criado com as suas ferramentas, o que nos ajuda a avaliar se algo é criado usando IA.

Assim como outras empresas do setor, descobrimos que os nossos rótulos baseados nesses indicadores nem sempre estavam alinhados com as expectativas das pessoas e nem sempre forneciam contexto suficiente. Por exemplo, alguns conteúdos que continham pequenas modificações usando IA, como ferramentas de retoque, incluíam indicadores padrão da indústria que foram rotulados como “Feito com IA”. Embora trabalhemos com empresas do setor para melhorar o processo para que nossa abordagem de rotulagem corresponda melhor à nossa intenção, estamos atualizando o rótulo “Feito com IA” para “Informações de IA” em nossos aplicativos, nos quais as pessoas podem clicar para obter mais informações.

Publicado originalmente em 05 de abril de 2024

Estamos fazendo mudanças na forma como lidamos com mídia manipulada no Facebook, no Instagram e no Threads com base no feedback do Comitê de Supervisão, de que deveríamos atualizar a nossa abordagem para que pudesse refletir uma variedade maior de conteúdos existentes hoje e fornecer mais contexto sobre os conteúdos por meio de rótulos. Essas mudanças também são embasadas pelo processo de revisão de políticas do Meta, que incluiu extensas pesquisas de opinião pública e consultas com acadêmicos, organizações da sociedade civil e outros.

Concordamos com o argumento do Comitê de Supervisão de que a nossa abordagem atual é restrita, uma vez que inclui apenas vídeos criados ou alterados por inteligência artificial para fazer com que uma pessoa pareça dizer algo que não tenha dito. Nossa política de mídia manipulada foi elaborada em 2020, quando conteúdos realistas gerados por IA eram pouco comuns e a preocupação geral era limitada aos vídeos. Nos últimos quatro anos, e particularmente no último ano, as pessoas desenvolveram outros tipos de conteúdos realistas gerados por inteligência artificial, como áudios e fotos, e essa tecnologia está evoluindo rapidamente. Como observou o Comitê, é igualmente importante que abordemos uma manipulação que indique que uma pessoa esteja fazendo algo que não fez.

O Comitê também argumentou que corremos um risco desnecessário de restringir a liberdade de expressão quando removemos mídias manipuladas que não violem os nossos Padrões da Comunidade, e nos recomendaram uma abordagem “menos restritiva” para conteúdos modificados, como rótulos de contexto. Em fevereiro, anunciamos que estamos trabalhando com parceiros da indústria em padrões técnicos comuns para identificar conteúdo de inteligência artificial, incluindo vídeos e áudios. Nossos rótulos de “Feito com IA” em vídeos, áudios e imagens gerados por inteligência artificial serão baseados na nossa identificação de sinais de imagens de IA compartilhados pela indústria ou de pessoas que divulguem que estão publicando conteúdos criados com inteligência artificial. Já adicionamos o rótulo “Criado com IA” às imagens realistas que são criadas com o uso do nosso recurso, Meta AI.

Concordamos que fornecer transparência e contexto adicional é a melhor maneira de abordar este conteúdo no momento. Os rótulos cobrirão uma gama mais ampla de conteúdo, além dos materiais modificados recomendados pelo Comitê de Supervisão. Se determinarmos que imagens, vídeos ou áudios criados ou alterados digitalmente criam um risco particularmente elevado de enganar o público sobre uma questão importante, poderemos adicionar um rótulo mais proeminente para que as pessoas tenham mais contexto. Essa abordagem global dá às pessoas mais informações sobre o conteúdo para que possam avaliá-lo melhor e para que tenham contexto caso vejam o mesmo material em outro lugar.

Portanto, vamos manter esse tipo de conteúdo em nossas plataformas para que possamos adicionar rótulos informativos e contexto a ele, a não ser que viole as nossas políticas. Por exemplo, continuaremos a remover conteúdos, independentemente de terem sido criados com inteligência artificial ou por uma pessoa, caso violem as nossas políticas de interferência eleitoral, bullying e assédio, violência e incitação, ou qualquer outra política dos nossos Padrões da Comunidade. Também temos uma rede de quase 100 checadores de fatos independentes que continuarão a revisar conteúdos falsos e enganosos gerados por inteligência artificial. Quando os verificadores classificam um conteúdo como falso ou modificado, nós o mostramos mais abaixo no Feed para que menos pessoas tenham acesso a ele e adicionamos um rótulo com informações adicionais. Além disso, não aceitamos anúncios que contenham conteúdos desmentidos e, desde janeiro, os anunciantes precisam sinalizar, em determinados casos, quando criam ou alteram digitalmente um anúncio sobre questões políticas ou sociais.

Planejamos começar a rotular conteúdo gerado por inteligência artificial em maio de 2024 e, em julho, deixaremos de remover conteúdos somente com base em nossa política de vídeos manipulados. Esse cronograma dá às pessoas tempo para entender o processo de divulgação antes de pararmos de remover conjuntos menores de mídia manipulada.

Processo de Política elaborado por especialistas globais e pesquisas públicas

Em 2023, começamos a reavaliar as nossas políticas para ver se precisávamos de uma nova abordagem para acompanhar os rápidos avanços nas tecnologias e utilização de inteligência artificial generativa. Consultamos mais de 120 stakeholders em 34 países ao redor do mundo. No geral, recebemos um amplo suporte para rotular conteúdos gerados por inteligência artificial, além de um forte apoio para aplicar um rótulo mais proeminente em cenários de alto risco. Muitos dos stakeholders foram receptivos ao conceito de pessoas divulgando conteúdo como gerado por IA.

A maior parte deles concordou que a remoção deve se limitar aos cenários de maior risco, onde o conteúdo pode estar associado a possíveis danos, dado que a inteligência artificial generativa está prestes a se tornar uma ferramenta comum para a expressão criativa. Isto está alinhado com os princípios dos nossos Padrões da Comunidade – de que as pessoas devem ser livres para se expressar ao mesmo tempo em que permanecem seguras ao utilizar os nossos serviços.

Também conduzimos pesquisas de opinião pública com mais de 23 mil entrevistados em 13 países e perguntamos às pessoas como as empresas de rede social, como a Meta, deveriam abordar o conteúdo gerado por inteligência artificial em suas plataformas. A grande maioria (82%) é favorável à aplicação de rótulos de aviso para conteúdos gerados por inteligência artificial que retratem pessoas dizendo coisas que não tenham dito.

Além disso, o Comitê de Supervisão reconheceu que as recomendações feitas por eles foram baseadas em consultas com organizações da sociedade civil, acadêmicos, organizações governamentais e outros especialistas.

Com base no feedback do Comitê de Supervisão, de especialistas e do público, estamos tomando medidas que consideramos apropriadas para plataformas como as nossas. Queremos ajudar as pessoas a saber quando imagens realistas forem criadas ou editadas usando inteligência artificial e, por isso, continuaremos a colaborar com pares da indústria através de fóruns como a Parceria sobre IA e manteremos o diálogo com governos e com a sociedade civil, além de continuarmos a revisar a nossa abordagem à medida que a tecnologia evoluir.