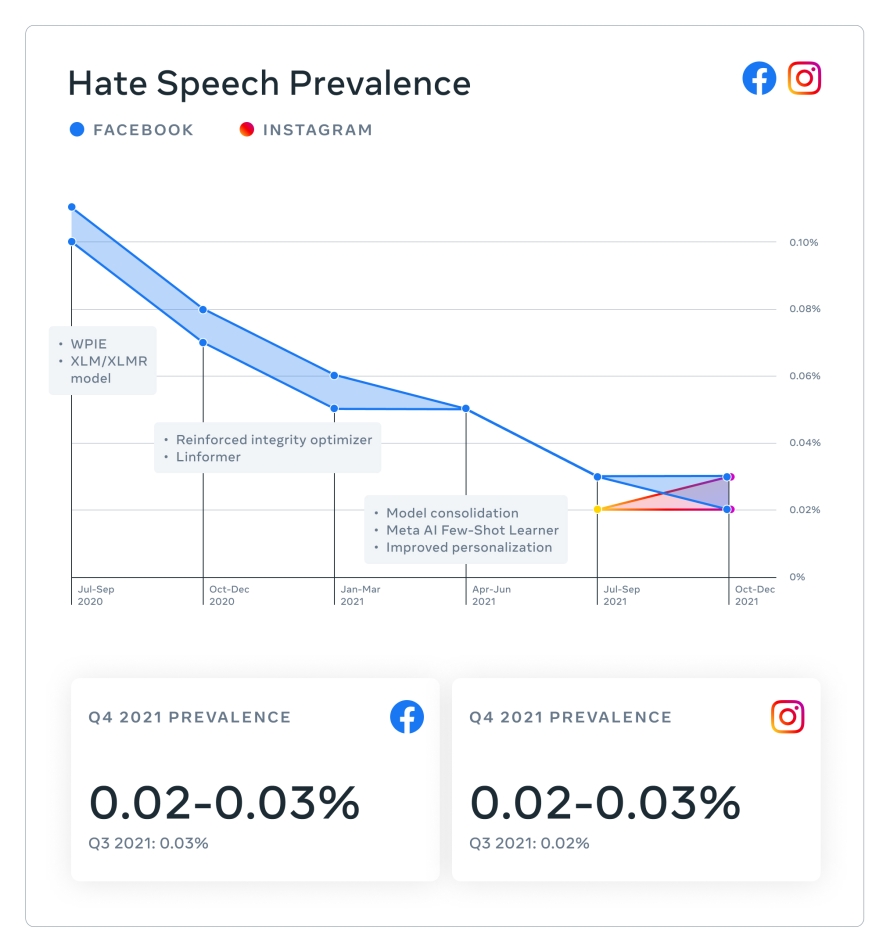

- A prevalência de conteúdos prejudiciais no Facebook e no Instagram permaneceram relativamente consistentes, ou diminuíram, do terceiro para o quarto trimestre na maioria de nossas políticas, em grande parte graças às nossas tecnologias proativas e expandidas de detecção.

A prevalência de conteúdos prejudiciais no Facebook e no Instagram permaneceram relativamente consistentes, ou diminuíram, do terceiro para o quarto trimestre na maioria de nossas políticas, em grande parte graças às nossas tecnologias proativas e expandidas de detecção.

Hoje, estamos publicando nosso Relatório de Aplicação de Padrões da Comunidade para o quarto trimestre de 2021. Este é nosso 12º Relatório de Aplicação de Padrões da Comunidade e fornece métricas sobre como aplicamos nossas regras entre os meses de outubro de 2021 e dezembro de 2021 em 14 políticas no Facebook e 12 no Instagram.

Também estamos compartilhando:

- O Relatório de Conteúdo Amplamente Visualizado do quarto trimestre de 2021

- O Relatório Trimestral do Comitê de Supervisão do quarto trimestre de 2021.

- Post em nosso Design Blog sobre os nossos esforços de design de integridade para evitar o uso indevido de nossas tecnologias, reduzir o risco de integridade e promover uma aplicação efetiva e justa das nossas políticas.

Todos esses relatórios estão disponíveis em nossa Central de Transparência.

Destaques do Relatório

A prevalência de conteúdos prejudiciais no Facebook e no Instagram permaneceram relativamente consistentes ou diminuíram, do terceiro para o quarto trimestre na maioria de nossas políticas, o que significa que a grande maioria do conteúdo que os usuários encontram não é violador.

Continuamos a ver números consistentes no conteúdo sobre o qual agimos em diferentes áreas.

No quarto trimestre, no Facebook, agimos em:

- 4 milhões de peças de conteúdo relacionadas à drogas, o que representa um aumento de 2,7 milhões quando comparado ao terceiro trimestre de 2021, graças às melhorias feitas em nossas tecnologias de detecção proativa.

- 1,5 milhão de peças de conteúdo relacionado a armas de fogo, um aumento de 1,1 milhão no terceiro trimestre, devido às tecnologias de detecção proativa.

- 1,2 bilhão de peças de conteúdo de spam, um aumento de 777,2 milhões quando comparado ao terceiro trimestre, por conta da grande quantidade de conteúdos que removemos em dezembro.

No quarto trimestre, no Instagram, agimos em:

- 905.300 peças de conteúdo relacionado a terrorismo, o que representa um aumento de 685.200 peças quando comparado ao terceiro trimestre, graças às melhorias realizadas em nossas tecnologias de detecção proativa.

- 195.000 peças de conteúdo relacionado a armas de fogo, representando um aumento de 154.400 peças quando comparado ao terceiro trimestre, devido às tecnologias de detecção proativa.

No relatório do terceiro trimestre, incluímos métricas de prevalência de bullying e assédio pela primeira vez, e agora compartilhamos essas métricas de prevalência novamente no quarto trimestre. No Instagram, a prevalência de bullying e assédio permaneceu relativamente estável no último trimestre, entre 0,05 e 0,06%. Neste trimestre, vimos uma redução na prevalência de conteúdo de bullying e assédio no Facebook. No quarto trimestre, essa porcentagem foi de 0,11% a 0,12%, caindo de 0,14% a 0,16% quando comparado ao terceiro trimestre. A redução da prevalência deveu-se, em parte, à contabilização de uma linguagem que, sem contexto adicional, poderia ser considerada ofensiva, mas na realidade é usada de forma familiar ou jocosa entre amigos.

Nossa melhoria constante na redução de conteúdo prejudicial

Nossa melhoria constante pode ser atribuída a uma abordagem abrangente, que inclui nossas políticas, os algoritmos e a inteligência artificial que nos ajudam a aplicá-las, a parte operacional da moderação de conteúdo global, e uma abordagem no design do produto que se concentra na segurança e integridade.

Com os avanços nas tecnologias de inteligência artificial, como o nosso Few Shot Learner e a mudança para a inteligência artificial generalizada, conseguimos agir corretamente sobre conteúdos prejudiciais com mais rapidez.

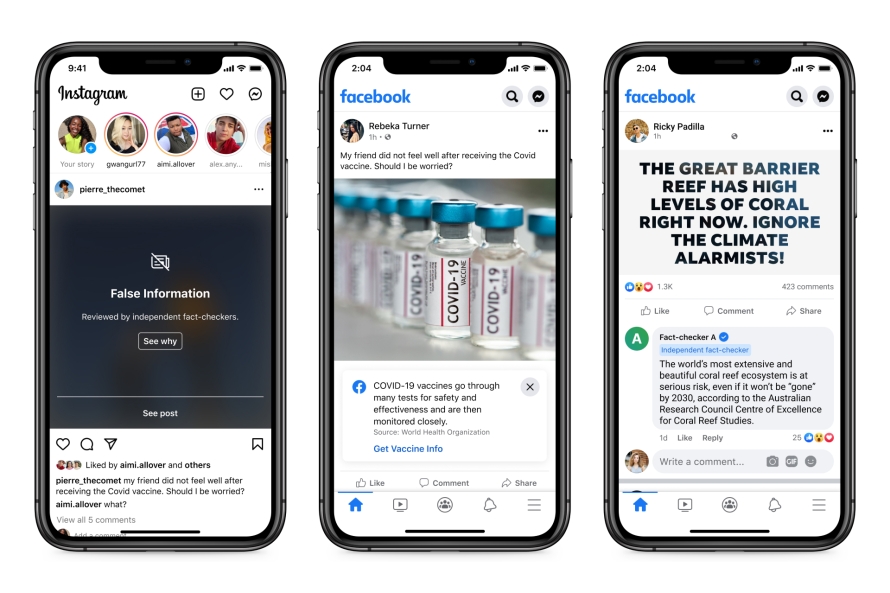

Nossas equipes de design de produtos desempenham um papel importante em nossos esforços para reduzir conteúdos nocivos. Ao projetar cuidadosamente nossos produtos de mídia social, podemos promover maior segurança ao mesmo tempo em que fornecemos às pessoas contexto, controle e espaço para compartilhar suas opiniões. Por exemplo, quando aplicadas, as sobreposições e rótulos informativos fornecem mais contexto e limitam a exposição a informações erradas ou conteúdos potencialmente sensíveis (exemplo apresentado nos gráficos). Leia mais sobre nosso processo de design de integridade.

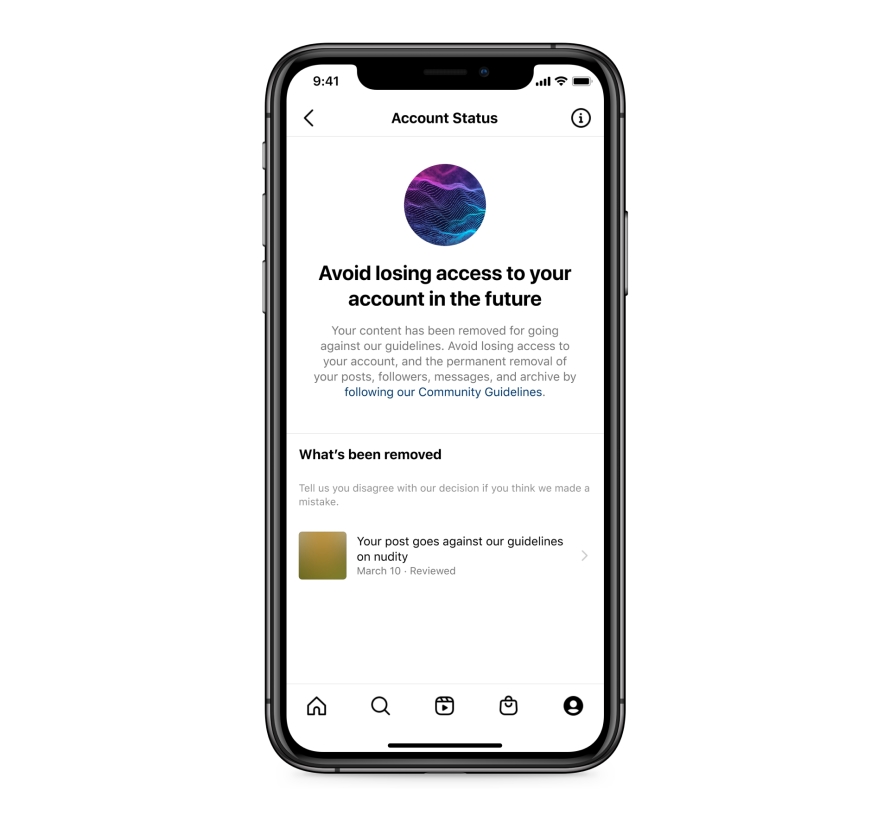

No último trimestre do ano passado, lançamos o Status da Conta no Instagram, que ajuda as pessoas a entender por que determinado conteúdo foi removido e quais políticas ele viola. Após este lançamento, vimos um aumento de conteúdo restaurado no Instagram em várias políticas, incluindo violência e incitação, discurso de ódio, bullying e assédio, e também nudez adulta e atividades sexuais.

Estamos sempre tentando identificar políticas que talvez estejam sendo aplicadas de forma insuficiente ou excessiva para que possamos melhorar. Por exemplo, em 2020, durante o Mês de Conscientização do Câncer de Mama, houve um grande acesso a conteúdos relacionados ao câncer de mama no Instagram, incluindo imagens contendo nudez adulta de natureza médica. Embora não violem nossas políticas, algumas dessas imagens foram incorretamente identificadas por nossos sistemas, o que levou à remoção de conteúdos das contas de suporte ao câncer de mama e de pessoas que sobreviveram à doença. Ouvimos de nossa Comunidade que precisávamos melhorar a forma como moderamos esse tipo de conteúdo. Por isso, o Conselho de Supervisão também ouviu um caso relacionado a sintomas de câncer de mama e nudez e nos pediu para melhorar nossa precisão de análise.

Desde então, trabalhamos para melhorar a precisão da aplicação de nossas políticas em conteúdos sobre saúde, incluindo materiais relacionados a câncer de mama e cirurgias. Definimos e esclarecemos nossa exceção para nudez médica treinando nossos sistemas de inteligência artificial para melhor reconhecer seios expostos com cicatrizes de mastectomia, e aumentar o conteúdo sinalizado como nudez médica para revisão humana, para melhorar ainda mais a precisão. Também enviamos conteúdos com palavras-chave usadas com frequência para revisão humana. Por fim, treinamos nossos sistemas para reconhecer melhor imagens benignas e não violadoras, e evitar a aplicação incorreta no futuro. Como resultado, observamos uma aplicação significativamente menor durante o Mês de Conscientização do Câncer de Mama do ano passado, que permitiu que nossa comunidade compartilhasse conteúdo abertamente.

Integridade e Transparência: De olho no Futuro

Estamos constantemente procurando novas maneiras de melhorar a transparência e a integridade de nossas plataformas. Por muitos anos, publicamos um detalhamento de todas as restrições de conteúdo que recebemos em nosso Relatório Transparência semestral, que incluem o volume de restrições de conteúdo que realizamos quando o conteúdo é denunciado como violador da lei local, mas não viola nossos Padrões da Comunidade. Por isso, concordamos em participar do Lumen, um projeto de pesquisa independente realizado pelo Berkman Klein Center for Internet & Society de Harvard, que estuda cartas de “cessar e desistir” – ordens ou pedidos para cessar uma atividade, sob pena de ação judicial – de governos e atores privados sobre conteúdo online. Estamos nos juntando ao Projeto Lumen porque ele nos permitirá responsabilizar governos, tribunais, reguladores e a nós mesmos pelo conteúdo que eles solicitam a remoção de acordo com a lei local. Estamos comprometidos em ampliar nossa participação no Lumen ao longo do tempo.

Continuaremos desenvolvendo nossas políticas e relatórios em 2022 – estamos sempre trabalhando para melhorar, para ser mais transparentes e compartilhar dados que sejam ainda mais significativos.