Se pudéssemos interagir com um assistente de Inteligência artificial (IA) numa linguagem de conversa natural, da mesma maneira que interagimos com as pessoas, nossas vidas se tornariam mais fáceis de inúmeras maneiras. Mas os assistentes atuais podem trazer diversas decepções, não importa se interagimos com eles por voz ou texto. Eles têm dificuldades com pedidos de rotina como “Silencie todas as notificações até o fim do dia, a menos que seja a minha mãe ligando” e mais ainda com perguntas como “Posso alugar o centro comunitário local para uma festa particular?” ou com tarefas como “Planeje férias em família na praia por um valor acessível para o fim de semana de 7 de setembro”.

Chegou a hora de uma IA interativa com mais qualidade.

Para conseguirmos isso, temos o prazer de anunciar o Projeto CAIRaoke. Desenvolvemos um modelo neural completo capaz de possibilitar conversas muito mais pessoais e contextuais do que os sistemas com os quais as pessoas estão familiarizadas. Já estamos usando o modelo resultante do Projeto CAIRaoke em um dos nossos produtos, Portal, e pretendemos integrá-lo a dispositivos de realidade aumentada e virtual para possibilitar interações imersivas e multimodais com assistentes no futuro.

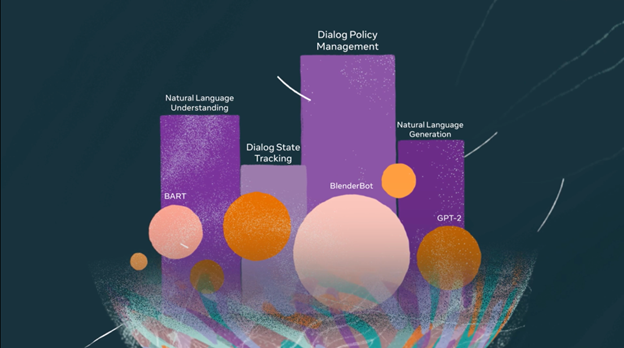

Talvez o maior obstáculo para uma IA interativa melhor seja a arquitetura que capacita até mesmo os assistentes mais avançados hoje em dia. Apesar de esses sistemas fornecerem um único serviço, na verdade, eles dependem de quatro componentes separados: compreensão de linguagem natural (NLU), rastreamento de estado do diálogo (DST), gerenciamento de política de diálogo (DP) e geração de linguagem natural (NLG). Esses sistemas de IA distintos devem ser vinculados, o que os torna difíceis de otimizar, ruins de adaptar a tarefas novas ou desconhecidas e altamente dependentes de conjuntos de dados anotados que executam muitos trabalhos.

Esse é o motivo de os assistentes digitais encontrados na maioria dos dispositivos atuais limitarem as opções dos usuários, se esquecerem do contexto da conversa e seguirem, na maioria das vezes, fluxos de diálogo determinados. Talvez você consiga perguntar a um assistente qual é a previsão do tempo local, por exemplo, mas ele ficará confuso se você perguntar algo simples, mas inesperado logo na sequência, como “Está mais quente do que estava na semana passada?”.

Com os modelos criados com o Projeto CAIRaoke, as pessoas poderão falar naturalmente com os assistentes interativos. Assim, conseguirão retomar algo sobre o qual conversaram antes, mudar o assunto totalmente ou mencionar tópicos que dependam da compreensão de um contexto complexo e cheio de nuances. Elas também poderão interagir com os assistentes de novas maneiras, como usando gestos.

Começamos a usar o modelo no Portal, o dispositivo de ligação de vídeo da Meta, para facilitar a criação e o gerenciamento de lembretes. Por exemplo, você pode resolver rapidamente uma solicitação como a seguinte sem precisar repeti-la:

👩: Criar um lembrete para as 6h30.

![]() : Da manhã ou da noite?

: Da manhã ou da noite?

👩: Da noite, e o nome dele pode ser “comprar ovos”.

![]() : Certo, seu lembrete para comprar ovos está definido para amanhã às 6h30 da noite.

: Certo, seu lembrete para comprar ovos está definido para amanhã às 6h30 da noite.

Mesmo nesse teste inicial, acreditamos que o modelo supera as abordagens padrão. No Portal, observamos uma melhora considerável, em comparação com nossa abordagem existente, na avaliação do domínio de lembretes, conforme mensurado pela taxa de sucesso de conclusão de um conjunto de objetivos de lembrete, mantendo um número de turnos igual.

Mas essa é apenas a primeira etapa do aproveitamento dessa nova tecnologia. Acreditamos que o progresso feito com o Projeto CAIRaoke nos permitirá oferecer uma comunicação mais avançada entre as pessoas e a inteligência artificial, que será uma ferramenta essencial durante a construção do metaverso. Um assistente com a tecnologia do Projeto CAIRaoke integrado a óculos de realidade aumentada poderá, um dia, ser usado de maneiras novas e úteis. Por exemplo, se você perguntasse “O que combina com esta calça?”, ele poderia responder “Esta camisa da sua cor preferida, vermelho” e mostrar uma imagem de um item encontrado para você. Se você dissesse “Gostei, mas as listras são muito largas”, ele mostraria uma versão com listras finas.

No futuro, esperamos aproveitar modelos resultantes desse projeto em aplicativos do cotidiano como esse para milhões de pessoas no mundo.

Construindo uma IA realmente interativa

Um passo necessário para a evolução da IA interativa é entender todo o escopo do problema. Muitas pessoas veem os vários avanços recentes em NLU, como BART e GPT-3, e acham que o desafio de entender e gerar um texto semelhante ao humano foi resolvido. Para mostrar claramente por que ainda não chegamos lá, precisamos separar a IA para compreensão, da IA para interação. A primeira passou por muita pesquisa e desenvolvimento no setor, ela é usada para extrair sentido de várias modalidades de entrada, como reconhecimento de fala automático, classificação de imagem e NLU. A última é como usamos nossa compreensão do mundo para interagir com outras pessoas usando tecnologia. Pode ser enviando um texto, um comando de voz, feedback tátil, mostrando uma imagem, um vídeo, um rosto de avatar ou uma combinação de todos eles.

Pesquisadores e engenheiros do setor concordam que bons sistemas de conversa precisam de um nível de compreensão sólido capacitado por modelos de inteligência artificial. Mas muitos sentem que a interação é um problema de engenharia, em vez de um problema de IA. Assim, um engenheiro que conhece o estado do mundo pode criar uma lógica elaborada para lidar com a interação necessária. A abordagem de engenharia facilita a compreensão do funcionamento do sistema e a depuração ágil da lógica quando necessário. Ainda assim, essa crença comum gera uma IA interativa menos robusta, e é um dos grandes motivos de não ser possível planejar facilmente suas férias por meio desses assistentes.

Uma abordagem nova e unificada

Legenda: Esses exemplos de diálogo mostram habilidades importantes que queremos para os nossos assistentes: Não apenas fornecer conhecimento real preciso e atualizado, mas também trabalhar de forma multimodal (nesse caso, por meio de visão e fala), trabalhar entre domínios (enviando uma mensagem e também estimando seu horário de chegada) e permitir que você conduza a conversa em vez de precisar se adaptar a um modelo de conversa rígido.

A abordagem convencional de assistentes com tecnologia de IA exige quatro conjuntos de entradas e saídas: um para cada estágio do pipeline (NLU, DST, DP e NLG). Além disso, exige padrões definidos de entradas e saídas para cada estágio. Por exemplo, para NLU, um sistema de IA interativo tradicional exige ontologias definidas (por exemplo, diversas intenções e entidades).

O modelo do Projeto CAIRaoke, no entanto, usa uma rede neural e não estabelece nenhum fluxo conversacional. Com esse modelo, precisamos de apenas um conjunto de dados de treinamento.

O Projeto CAIRaoke reduz o trabalho necessário para adicionar um novo domínio. Na abordagem convencional, a expansão para um novo domínio exige a construção e a correção sequencial de cada módulo antes que o próximo possa ser treinado de forma confiável. Em outras palavras, o treinamento de DP não poderá ser feito efetivamente se o NLU e o DST mudarem diariamente. Mudanças em um componente poderiam prejudicar os outros, disparando um novo treinamento de todos os módulos subsequentes. Essa interdependência torna o progresso mais lento nos módulos subsequentes. Mas, com a nossa técnica de ponta a ponta, removemos essa dependência de módulos anteriores, aumentando a velocidade de desenvolvimento e treinamento e permitindo o ajuste de outros modelos com menos esforço e menos dados.

Com a nossa nova abordagem, os diálogos são muito mais robustos, pois são capazes de tomar decisões analisando todo o espectro de informações em um único local. Antes, mesmo um pequeno erro em um componente era capaz de se propagar para outros componentes de maneiras inesperadas e difíceis de solucionar. Por exemplo, os assistentes atuais baseados em regras são programados explicitamente para procurar palavras ou frases específicas, como “p.m.” depois de um número para indicar à tarde, enquanto o Projeto CAIRaoke aproveita os modelos avançados de linguagem pré-treinados que entendem melhor o contexto e podem reconhecer maneiras diferentes de dizer a mesma coisa.

Por fim, o Projeto CAIRaoke une a tecnologia que dá suporte ao bot interativo mais recente da Meta AI, BlenderBot 2.0, a diálogos orientados por tarefas. Isso significa que assistentes criados usando o nosso modelo poderiam mostrar uma linguagem empática, transmitir o conhecimento encontrado em uma pesquisa na internet em tempo real e demonstrar uma personalidade consistente.

Quando os sistemas geram linguagem natural, é essencial solucionar os possíveis desafios de segurança e privacidade. O script da maioria dos componentes de NLG atuais é criado de modo que os moderadores de conteúdo garantam que os assistentes não deem respostas censuráveis aos usuários. Mas, ao conectar o assistente diretamente ao usuário, há o perigo de erros ou interações ofensivas, como já foi visto acontecer.

É importante dizer que incorporamos proteções ao BlenderBot que ajudarão a reduzir ocorrências de respostas ofensivas. Também estamos criando uma tecnologia de assistentes levando em conta a privacidade. Por exemplo, com os Ray-Ban Stories e o Portal, o uso de comandos de voz é opcional, é possível ver e excluir as transcrições de seus comandos de voz, e você sempre tem a opção de desativar o armazenamento de voz.

Para reduzir o risco de gerar respostas censuráveis para os usuários, o primeiro marco do Projeto CAIRaoke foi a geração de uma ação de diálogo e de uma linguagem natural. No curto prazo, geramos ações de diálogo e contamos com um sistema de NLG testado e bastante limitado para fornecer a resposta ao usuário. No longo prazo, vamos revelar as sentenças geradas depois de assegurar a integridade completa do nosso modelo.

Outro problema, compartilhado por outros tipos de sistemas de NLP, é o que chamamos de hallucination (alucinação, na tradução livre para português), que ocorre quando um modelo afirma, com confiança, informações incorretas. Isso é um grande desafio para técnicas de ponta a ponta, já que os modelos podem tender a introduzir ou alterar entidades no diálogo com base nos dados de treinamento. Por exemplo, se você pedir a um assistente que “defina um lembrete para ligar para a Ankita”, talvez ele defina um lembrete para ligar para Anita, já que Ankita é um nome menos comum. Usamos diversas técnicas de aumento de dados e redes de atenção para tornar o Projeto CAIRaoke mais robusto e aproveitamos o nosso trabalho com o BlenderBot 2.0 a fim de reduzir a alucinação.

Usando a voz para inúmeras tarefas diárias

Embora nossa implementação de curto prazo do modelo do Projeto CAIRaoke seja para lembretes no Portal, esperamos usá-lo em breve em domínios muito maiores para ajudar a personalizar as experiências de compra das pessoas, permitir que os assistentes mantenham o contexto em diversas conversas e possibilitar que as pessoas conduzam o fluxo da conversa.

Também achamos que esse avanço é particularmente útil para a criação de recursos de diálogo conduzido por IA para realidade aumentada. Num futuro não muito distante, as pessoas usarão regularmente os assistentes de voz nos óculos de realidade aumentada da mesma maneira que usam atualmente alto-falantes, relógios e outros dispositivos inteligentes. Pensando nisso, estamos trabalhando para reduzir o tamanho de modelos completos como esse para incluí-los no dispositivo, já que os modelos no dispositivo também oferecem mais benefícios de segurança, privacidade e desempenho. Também estamos trabalhando para facilitar a depuração do modelo — um desafio complicado, pois, nessa nova estrutura, as informações são representadas no espaço de incorporação, enquanto, no modelo convencional, elas ficam explícitas. Para alcançar totalmente a nossa visão do Projeto CAIRaoke, também precisaremos dimensioná-la para muitos idiomas e encontrar maneiras de usar o modelo com eficiência numa escala de bilhão.

Podemos imaginar que, em alguns anos, a tecnologia do Projeto CAIRaoke será a base da próxima geração de interação entre pessoas e dispositivos. Em dispositivos como headsets de realidade virtual e óculos de realidade aumentada, acreditamos que esse tipo de comunicação se tornará o método onipresente e contínuo de navegação e interação, da mesma maneira que as telas sensíveis ao toque substituíram os teclados em smartphones. Nosso modelo atual é um avanço importante, mas temos mais trabalho a fazer para alcançarmos plenamente essa visão. Estamos empolgados com o progresso que fizemos até o momento e os desafios que temos pela frente.