Usar nossos aplicativos para prejudicar crianças é abominável e inaceitável. Nossos esforços, líderes na indústria, para combater a exploração infantil se concentram na prevenção de abusos, detecção e denúncia de conteúdos que violam nossas políticas e também no trabalho com especialistas e autoridades para manter as crianças seguras. Hoje, anunciamos novas ferramentas que estamos testando para impedir que as pessoas compartilhem conteúdo que vitimizam as crianças, assim como melhorias recentes que fizemos em nossas ferramentas de detecção e denúncia.

Foco na prevenção

Para entender como e porquê as pessoas compartilham conteúdo de exploração infantil em nossos aplicativos, conduzimos uma análise detalhada do conteúdo ilegal de exploração infantil que reportamos ao Centro Nacional para Crianças Desaparecidas e Exploradas (NCMEC), em outubro e novembro de 2020. Descobrimos que 90% deste conteúdo é igual, ou quase idêntico, ao conteúdo que já foi compartilhado. E as cópias de apenas seis vídeos foram responsáveis por mais da metade do conteúdo de exploração infantil que reportamos naquele período. Esses dados indicam que o número de peças de conteúdo não é igual ao número de vítimas, e que o mesmo conteúdo, potencialmente alterado superficialmente, está sendo compartilhado repetidamente. Mas sabemos que mesmo que seja uma vítima desse crime horrível, já é muito.

Dado que apenas algumas peças de conteúdo foram responsáveis por muitas denúncias, isso sugere que um maior entendimento da intenção pode nos ajudar a prevenir essa revitimização. Trabalhamos com os principais especialistas em exploração infantil, incluindo o NCMEC, para desenvolver uma taxonomia baseada em pesquisa para categorizar a aparente intenção de uma pessoa em compartilhar este conteúdo. Com base nessa taxonomia, avaliamos 150 contas que relatamos ao NCMEC pelo envio de CSAM em julho e agosto de 2020 e janeiro de 2021, e estimamos que mais de 75% delas não exibiram intenção maliciosa (ou seja, não tinham a intenção de prejudicar uma criança), mas pareciam compartilhar por outros motivos, como indignação ou tentativa de humor. Embora este estudo represente nosso melhor entendimento, essas descobertas não devem ser consideradas uma medida precisa do ecossistema de segurança infantil. Nosso trabalho para entender intenções é contínuo.

Com base em nossas descobertas, estamos desenvolvendo soluções direcionadas, incluindo novas ferramentas e políticas para reduzir o compartilhamento desse tipo de conteúdo.

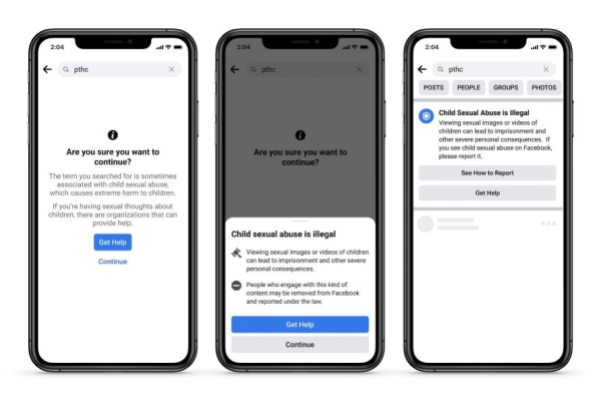

Começamos testando duas novas ferramentas — uma voltada para a busca potencialmente maliciosa por este conteúdo e outra voltada para o compartilhamento não malicioso desse conteúdo. A primeira ferramenta é um pop-up que é mostrado às pessoas que buscam por termos em nossos aplicativos associados à exploração infantil. O pop-up oferece maneiras de obter ajuda de organizações para suporte de ofensores sexuais e compartilha informações sobre as consequências da visualização de conteúdo ilegal.

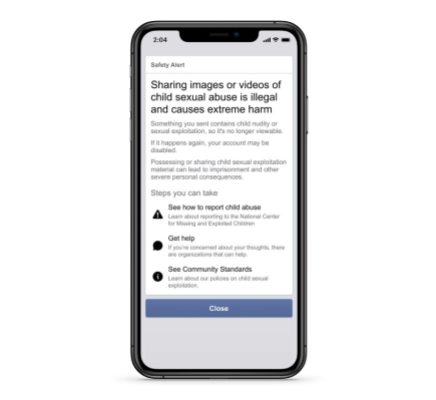

A segunda é um alerta de segurança que informa as pessoas que compartilharam conteúdo viral de exploração infantil sobre os danos que isso pode causar, e avisa que isso é contra nossas políticas e que há consequências legais para o compartilhamento desse material.

Estamos usando percepções desta nova ferramenta para nos ajudar a identificar sinais de comportamento daqueles que podem estar em iminência de compartilhar este material, para que também possamos educá-los sobre o por quê isso é prejudicial e incentivá-los a não compartilhá-lo em qualquer plataforma — pública ou privada.

Melhorando nossas capacidades de detecção

Por anos usamos tecnologia para encontrar conteúdo de exploração infantil e detectar possíveis interações inapropriadas com crianças ou aliciamento infantil. Porém, expandimos nosso trabalho para detectar proativamente e remover redes que violam nossas políticas de exploração infantil, de forma semelhante aos nossos esforços contra o comportamento inautêntico coordenado e organizações perigosas.

Adicionalmente, atualizamos nossas políticas de segurança infantil para esclarecer que removeremos Perfis, Páginas e Grupos do Facebook e contas do Instagram que se dedicam a compartilhar imagens de crianças, de forma que não seja inocente, com legendas, hashtags ou comentários que contenham sinais inapropriados de afeto ou comentários sobre as crianças retratadas na imagem. Sempre removemos conteúdo que sexualiza explicitamente as crianças, mas o conteúdo que não é explícito e não retrata nudez infantil é mais difícil de definir. Sob esta nova política, embora as imagens por si só possam não violar nossas regras, o texto que acompanha pode nos ajudar a determinar melhor se o conteúdo está sexualizando crianças e se o Perfil, Página, Grupo ou conta associados deve ser removido.

Atualizando nossas ferramentas de denúncia

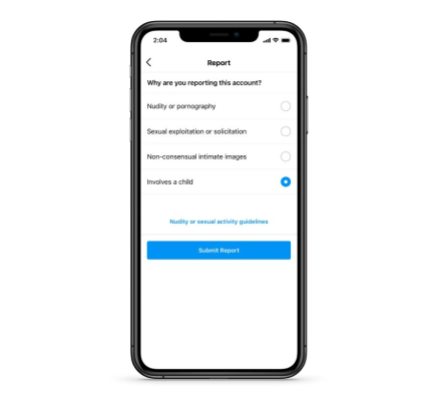

Após consultas com especialistas e organizações em segurança infantil, tornamos mais fácil denunciar um conteúdo por violar nossas políticas de exploração infantil. Para fazer isso, adicionamos a opção de escolher “envolve uma criança” na categoria de denúncia “Nudez e atividade sexual” em mais lugares no Facebook e Instagram. Essas denúncias serão priorizadas para revisão. Também começamos a usar a API Content Safety do Google para nos ajudar a priorizar melhor o conteúdo que pode conter exploração infantil para nossos revisores de conteúdo avaliarem.

Para saber mais sobre nossos esforços contínuos para proteger as crianças em espaços públicos e privados em nossos aplicativos, visite facebook.com/safety/onlinechildprotection.