Por Guy Rosen

As pessoas só se sentirão à vontade para compartilhar no Facebook se sentirem-se seguras. Assim, nos últimos dois anos, investimos pesadamente em tecnologia e em pessoas para remover com mais eficácia conteúdos ruins de nossos serviços. No começo do ano, pela primeira vez publicamos as diretrizes internas que nossas equipes de revisão usam para reforçar nossos Padrões da Comunidade – para que nossa comunidade possa entender melhor o que é permitido no Facebook e por quê. Em maio, publicamos números mostrando quanto conteúdo abusivo foi detectado em nossos serviços, assim as pessoas poderiam julgar por si próprias como estamos indo bem.

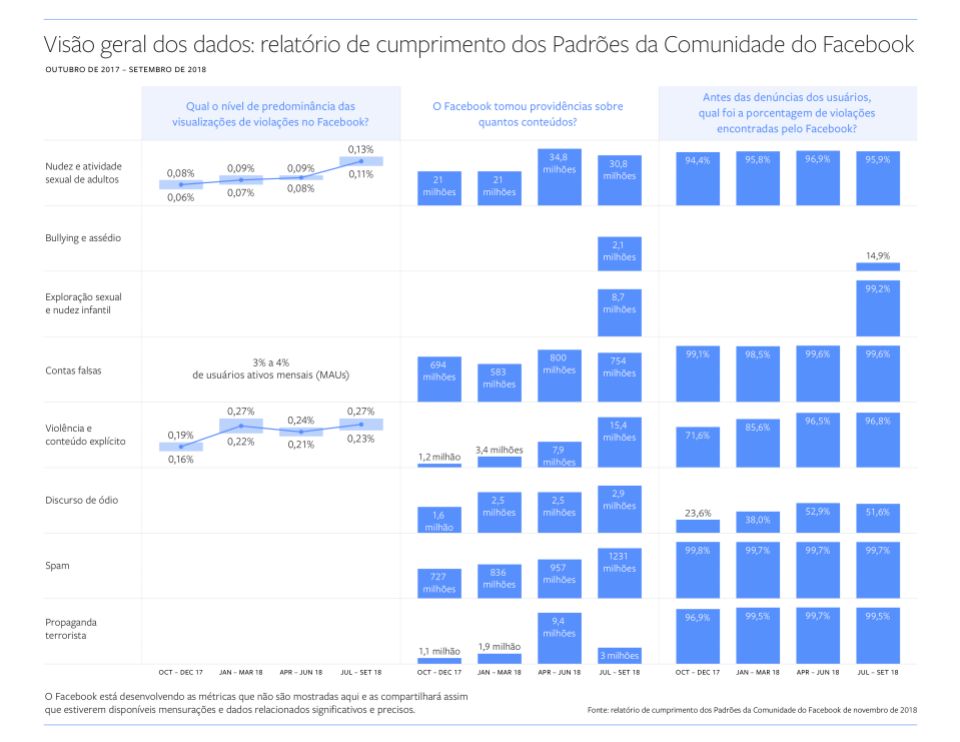

Hoje, estamos publicando nosso segundo Relatório de Transparência dos Padrões da Comunidade. Este segundo relatório mostra nossos esforços de aplicação das políticas contra Violência Gráfica, Nudez Adulta e Atividade Sexual, Propaganda Terrorista, Discurso de Ódio, Spam e Contas Falsas, durante os seis meses entre abril e setembro de 2018. O relatório também inclui duas novas categorias de dados – Bullying e Assédio, e Nudez Infantil e Exploração Sexual de Crianças.

Encontrando conteúdo abusivo

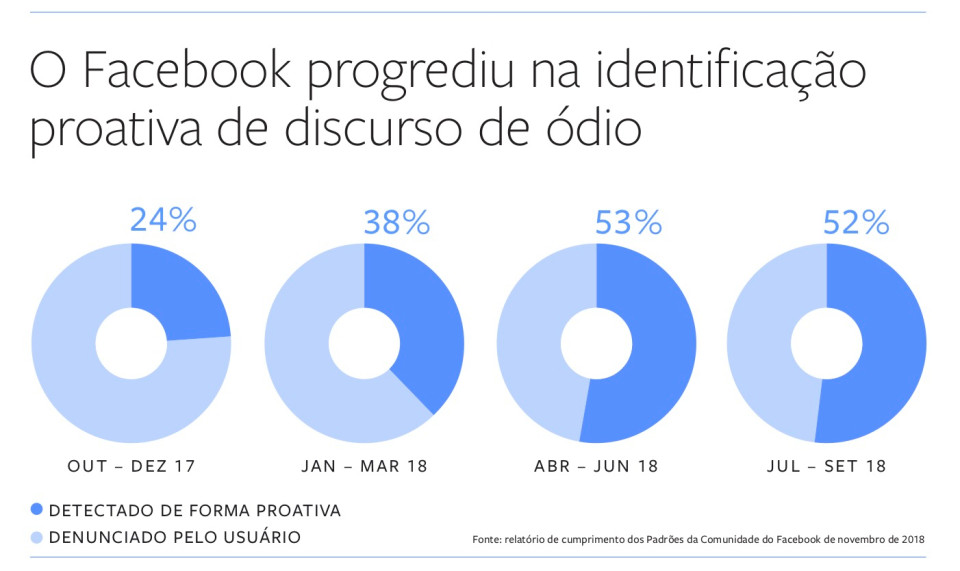

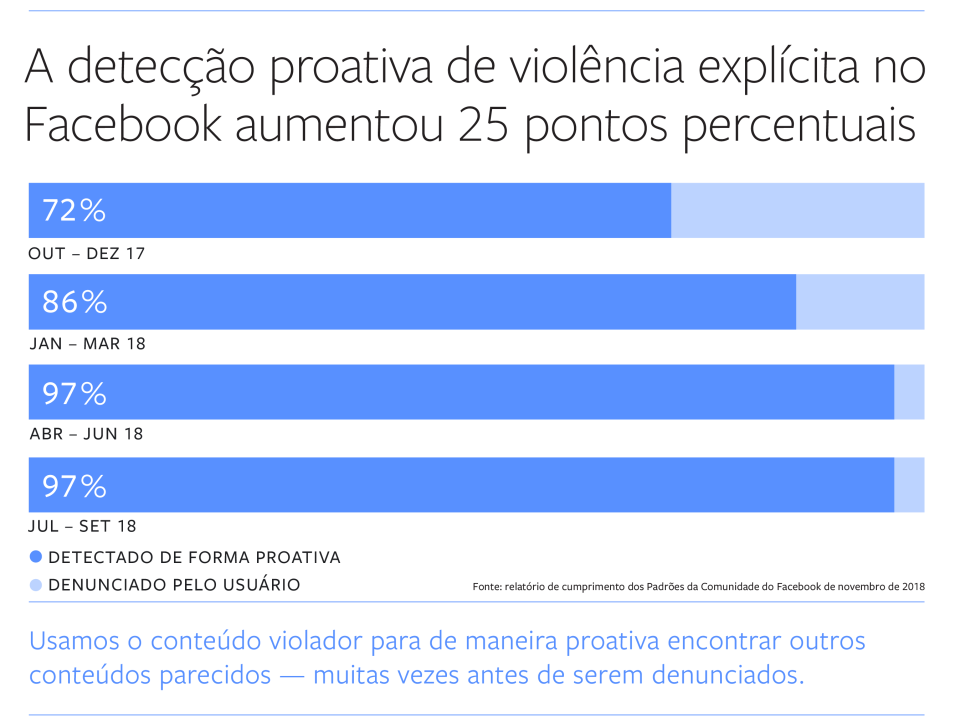

Estamos melhorando em identificar proativamente conteúdo abusivo antes mesmo que alguém denuncie, especificamente nos casos de Discurso de Ódio e Violência Gráfica. Mas ainda há áreas em que temos mais trabalho a fazer.

- Desde o nosso último relatório, a quantidade de discurso de ódio que detectamos de forma proativa, antes de qualquer pessoa denunciar, mais do que dobrou – de 24% para 52%. A maioria das postagens que retiramos por discurso de ódio são conteúdos que encontramos antes que alguém os denuncie. Este é um trabalho incrivelmente importante e continuamos investindo muito nos casos em que nosso trabalho ainda está em estágios iniciais e nos casos em que precisamos melhorar nosso desempenho em idiomas menos utilizados.

- Nossa taxa detecção proativa de violência gráfica aumentou 25 pontos percentuais – de 72% para 97%.

(Gráfico acima atualizado em 19 de novembro de 2018, às 19h, para corrigir o percentual de discurso de ódio identificado proativamente entre janeiro e março de 2018)

Remoção de contas e de conteúdo abusivo

Não estamos apenas melhorando em encontrar conteúdos de baixa qualidade, também estamos ficando melhores em derrubá-lo. No terceiro trimestre de 2018, acionamos 15,4 milhões de conteúdos contendo violência gráfica – mais de 10 vezes a quantidade do quarto trimestre de 2017. Esse aumento foi devido a melhorias contínuas em nossa tecnologia que nos permite aplicar automaticamente a mesma ação em conteúdos extremamente semelhantes ou idênticos. Além disso, como anunciamos na semana passada, houve um aumento significativo na quantidade de conteúdo terrorista que removemos no segundo trimestre de 2018. Expandimos o uso de nosso sistema de media matching – tecnologia que pode detectar proativamente fotos que são extremamente semelhantes a violações de conteúdo já existentes em nosso banco de dados – para excluir imagens antigas de propaganda terrorista. Parte desse aumento também se deve à correção de um bug que nos impediu de remover alguns conteúdos que violavam nossas políticas.

Também retiramos mais contas falsas no segundo e terceiro trimestres do que em trimestres anteriores, 800,4 milhões e 753,7 milhões, respectivamente. A maioria dessas contas falsas foi o resultado de ataques de spam motivados financeiramente que tentavam criar contas falsas em massa. Como conseguimos remover a maioria dessas contas minutos após o cadastro, a prevalência de contas falsas no Facebook permaneceu estável em 3% a 4% dos usuários ativos mensais, conforme divulgado em nossos resultados do terceiro trimestre.

Adicionando novas categorias

Para as duas novas categorias que adicionamos a este relatório – Bullying e Assédio, e Nudez Infantil e Exploração Sexual de Crianças – os dados servirão como ponto de partida para que também possamos medir nosso progresso ao longo do tempo.

O bullying e o assédio moral tendem a ser pessoais e específicos a algum determinado contexto, portanto, em muitos casos, precisamos que uma pessoa nos denuncie esse comportamento antes que possamos identificá-lo ou removê-lo. Isso resulta em uma taxa de detecção proativa mais baixa do que outros tipos de violações. No último trimestre, agimos em 2,1 milhões de conteúdos que violaram nossas políticas de bullying e assédio moral – removendo 15% desse total antes de ser denunciado. Descobrimos proativamente esse conteúdo enquanto pesquisávamos outros tipos de violações. O fato de que as vítimas geralmente têm que denunciar esse conteúdo antes que possamos agir pode ser desagradável para elas. Estamos determinados a melhorar nossa compreensão desses tipos de abuso para que possamos melhorar a detecção proativa deles.

Nossos Padrões da Comunidade proíbem a exploração infantil. Mas, para evitar um potencial abuso, removemos também conteúdo não sexual, como por exemplo fotos inocentes de crianças no banho – o que, em outro contexto, poderia facilmente ser mal utilizado. Apenas no último trimestre removemos 8,7 milhões de conteúdos que violaram nossas políticas de nudez infantil ou exploração sexual de crianças – 99% foram identificados antes que alguém os denunciasse. Também anunciamos recentemente uma nova tecnologia para combater a exploração de crianças no Facebook, que acredito que nos ajudará a identificar mais conteúdo ilegal ainda mais rápido.

De forma geral, sabemos que temos muito mais trabalho a fazer quando se trata de evitar abusos no Facebook. Machine learning e inteligência artificial continuarão nos ajudando a detectar e remover conteúdos de baixa qualidade do Facebook. Medir nosso progresso também é crucial porque mantém nossas equipes focadas no desafio que essa tarefa representa. Para nos ajudar a avaliar nossos processos e metodologias de dados, trabalhamos com o Data Transparency Advisory Group (DTAG), um grupo de especialistas em medição e governança. Continuaremos aprimorando esses dados ao longo do tempo, para que sejam mais precisos e significativos.

Você pode ver o Relatório de Transparência dos Padrões da Comunidade e informações atualizadas sobre requisições de autoridades e remoções de IP aqui. Ambos os relatórios estarão disponíveis em mais de 15 idiomas no início de 2019.