Por Guy Rosen, vice-presidente de Gerenciamento de Produto

Muitas vezes nos perguntam como decidimos o que é permitido no Facebook – e quanto conteúdo ruim existe. Há anos temos nossos Padrões da Comunidade que explicam o que é permitido na plataforma. Há três semanas, publicamos pela primeira vez as diretrizes internas que usamos para analisar se um post infringe nossas políticas. Hoje, divulgamos números em um Relatório de Transparência dos Padrões da Comunidade para que você possa avaliar nosso trabalho para fazer valer nossas políticas de conteúdo.

Nosso vice-presidente de Análise de Dados, Alex Schultz, explica com mais detalhes como exatamente medimos o que está acontecendo no Facebook, tanto neste post de Questões Complexas como no nosso Guia para entender o Relatório de Transparência dos Padrões da Comunidade. Mas é importante ressaltar que esse é um trabalho em andamento e que provavelmente mudaremos nossa metodologia à medida que aprendermos mais sobre o que é importante e o que funciona.

O relatório abrange os nossos esforços de revisão de conteúdo em seis áreas: violência gráfica; nudez e atividade sexual de adultos; propaganda terrorista; discurso de ódio; spam; e contas falsas. Os números mostram:

- Quanto conteúdo que viola nossos padrões as pessoas viram;

- Quanto conteúdo removemos; e

- Quanto conteúdo detectamos proativamente usando nossa tecnologia – antes de as pessoas que usam o Facebook denunciarem.

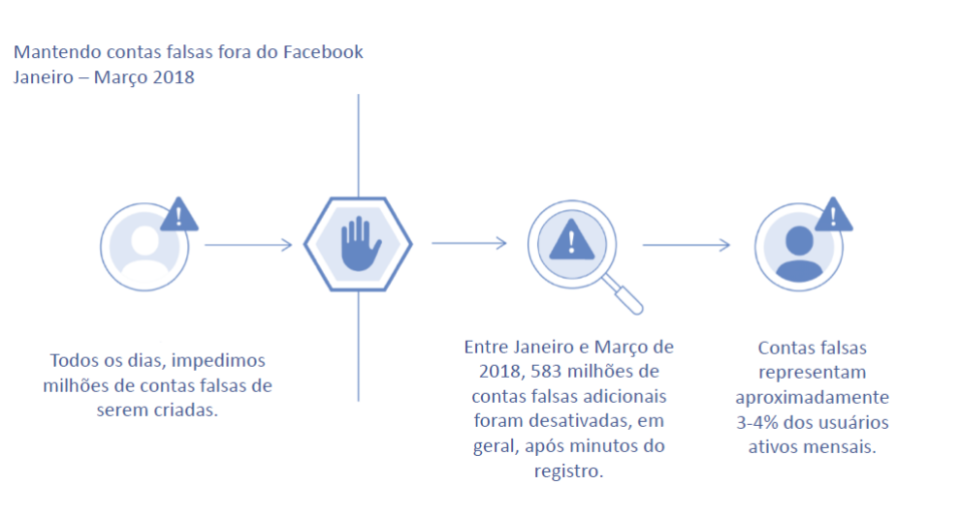

A maioria das ações que tomamos para remover conteúdo de baixa qualidade é em torno de contas falsas e da grande quantidade de spam gerada por elas. Por exemplo:

- Derrubamos 837 milhões de spams no primeiro trimestre de 2018 – quase 100% dos quais foram encontrados e sinalizados antes que alguém os denunciasse;

- A chave para combater spam é derrubar as contas falsas que espalham esses conteúdos. No primeiro trimestre, desativamos cerca de 583 milhões de contas falsas – a maioria delas dentro de minutos do registro. Isso é em acréscimo às milhões de tentativas de contas falsas que impedimos diariamente de se cadastrarem no Facebook. Ao todo, estimamos que entre três a quatro por cento das contas ativas do Facebook nesse período ainda eram falsas.

Em relação a outros tipos de conteúdo que violam nossos Padrões da Comunidade:

- Removemos 21 milhões de conteúdos de nudez ou pornografia adulta durante o primeiro trimestre de 2018 – 96% dos quais foram encontrados e sinalizados pela nossa tecnologia antes de serem denunciados. Ao todo, estimamos que de cada 10 mil itens de conteúdo visualizados no Facebook, de sete a nove visualizações eram conteúdos que violavam nossos padrões de nudez e pornografia adulta.

- Para assuntos como violência gráfica e discurso de ódio, nossa tecnologia ainda não funciona tão bem, então é necessária a verificação do conteúdo por nossas equipes de revisão. Removemos ou aplicamos notificações de aviso em cerca de três milhões e meio de conteúdos violentos no primeiro trimestre de 2018 – 86% deles foram inicialmente identificados pela nossa tecnologia antes de serem denunciados ao Facebook. Também removemos 2,5 milhões de conteúdos com discurso de ódio no primeiro trimestre de 2018 – 38% dos quais foram sinalizados por nossa tecnologia.

Como Mark disse na F8, ainda temos muito trabalho pela frente na prevenção de abusos. Tecnologias como a inteligência artificial, que embora seja promissora, ainda está longe de ser efetiva para a maioria dos conteúdos de baixa qualidade, ja que uma análise do contexto também é muito importante. Por exemplo, a inteligência artificial não é boa o suficiente para determinar se alguém está proclamando ódio ou se está descrevendo uma situação ocorrida consigo mesma para gerar conscientização sobre o assunto. Como expliquei na semana passada, a tecnologia precisa de um enorme treinamento de dados para reconhecer padrões de comportamento, que muitas vezes não temos em idiomas usados de maneira menos ampla, ou para casos que não são frequentemente denunciados. Além disso, em muitas áreas – seja spam, pornografia ou contas falsas – enfrentamos adversários sofisticados que mudam continuamente de tática para contornar nossos controles, o que significa que devemos desenvolver e adaptar nossos esforços continuamente também. É por isso que estamos investindo tanto em mais pessoas como em tecnologia para tornar o Facebook mais seguro para todos.

É também por isso que estamos publicando essas informações. Acreditamos que o aumento da transparência tende a levar a uma maior prestação de contas e responsabilidade ao longo do tempo, e publicar essas informações nos levará a melhorar mais rapidamente. Estes são os mesmos dados que usamos para medir nosso progresso internamente – e agora você pode ver isso para acompanhar nosso progresso. Estamos ansiosos pelo seu feedback.