Guy Rosen, Vice-presidente de Integridade do Facebook

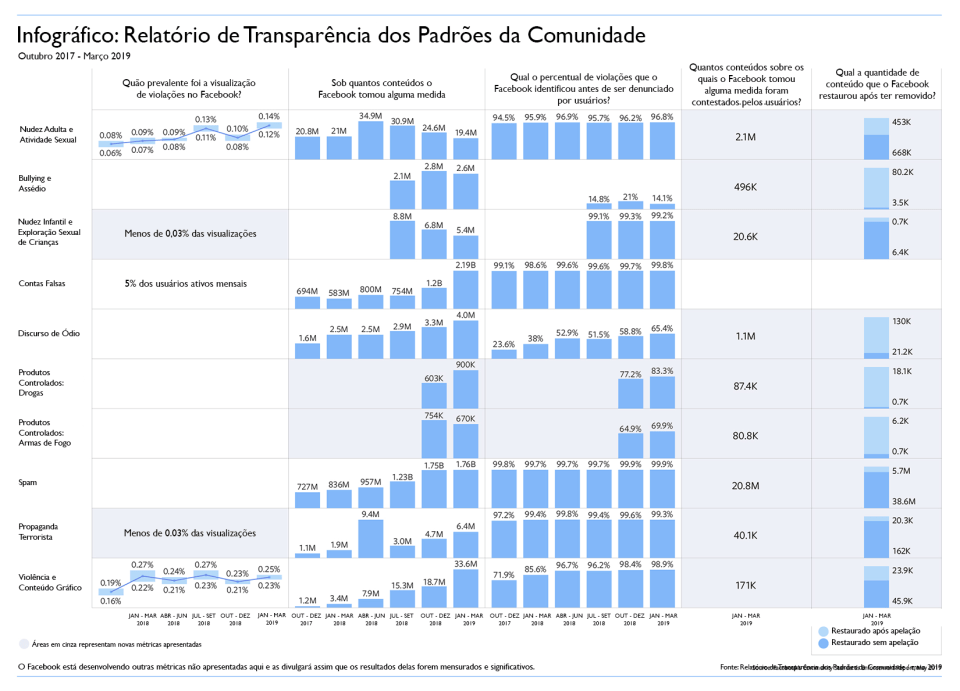

Hoje, estamos publicando nosso terceiro Relatório de Transparência dos Padrões da Comunidade, cobrindo o quarto trimestre de 2018 e o primeiro trimestre de 2019. Esse relatório inclui alguns dados adicionais:

O que há de novo na terceira edição

- Dados sobre apelações e conteúdo restaurado: pela primeira vez, incluímos a quantidade de conteúdos para os quais as pessoas fizeram uma apelação e a quantidade de conteúdo que foi restaurado após a ter sofrido sanção inicial.

- Dados sobre produtos controlados: Além das oito áreas de políticas abordadas na segunda edição do relatório (novembro de 2018), agora estamos detalhando o nosso trabalho de remoção de tentativas de vendas ilícitas de produtos controlados, especificamente armas de fogo e drogas.

No total, agora incluímos métricas sobre nove políticas que fazem parte dos nossos Padrões da Comunidade: nudez adulta e atividade sexual, bullying e assédio, nudez infantil e exploração sexual de crianças, contas falsas, discurso de ódio, produtos controlados, spam, propaganda terrorista e violência e conteúdo explícito.

Como entender os números

As principais métricas no nosso relatório, que permitem monitorar o nosso trabalho na aplicação dos Padrões da Comunidade, são:

Prevalência: a frequência com a qual um conteúdo que viola os nossos Padrões de Comunidade foi visualizado. Nós nos preocupamos com a frequência com que um conteúdo que viola as nossas políticas é visualizado por alguém. Enquanto a métrica de conteúdo que sofreu sanções descreve quantos itens removemos, a prevalência detalha a quantidade de conteúdos que ainda não identificamos e ainda podem ser vistos. Medimos a prevalência fazendo amostragens periódicas do conteúdo visualizado no Facebook e depois o analisando para ver o percentual que viola os nossos padrões.

Atualmente, essa métrica está disponível para nudez e atividade sexual de adultos, conteúdo violento e explícito e contas falsas:

- Estimamos que, para cada 10 mil vezes que as pessoas visualizaram conteúdo no Facebook, de 11 a 14 visualizações tinham conteúdo que violava a nossa política de nudez e atividade sexual de adultos.

- Estimamos que, para cada 10 mil vezes que as pessoas visualizaram conteúdo no Facebook, 25 visualizações tinham conteúdo que violava a nossa política de conteúdo violento e explícito.

- Em relação a contas falsas, estimamos que 5% das contas ativas mensais se encaixem nessa categoria.

Nesse relatório, também estamos compartilhando uma métrica de prevalência relativa a terrorismo global e nudez infantil e exploração sexual de crianças pela primeira vez. A prevalência para ambas as áreas é baixa demais para ser medida com os nosso mecanismo padrão, mas estimamos que, no primeiro trimestre de 2019, para cada 10 mil vezes que as pessoas visualizaram conteúdo no Facebook, menos de três visualizações tinham conteúdo que violava cada uma dessas políticas.

Continuamos desenvolvendo métricas de prevalência para as políticas que incluímos no relatório. Saiba mais sobre como mensuramos a prevalência aqui.

Conteúdo que sofreu sanções: a quantidade de conteúdos que acionamos porque violavam os nossos Padrões da Comunidade. As nossas sanções incluem remover o conteúdo, inserir uma tela de aviso no conteúdo ou desativar contas. Esta métrica reflete a quantidade de conteúdos publicados que violam as nossas políticas e com quanta precisão podemos identificá-los.

Em relação a contas falsas, o número de contas que removemos aumentou devido a ataques automatizados feitos por indivíduos que tentaram criar grandes volumes de contas de uma vez. Desativamos 1,2 bilhão de contas no último trimestre de 2018 e 2,19 bilhões no primeiro trimestre de 2019 – a maioria dessas contas foi bloqueada dentro de minutos de sua criação, antes que pudessem causar algum dano, e foram removidas tão rápido que nunca foram consideradas ativas. Continuaremos a encontrar maneiras de combater tentativas de violar nossas políticas, e nosso VP de Analytics, Alex Schultz, explica mais sobre como lidamos com contas falsas em nosso blog de Questões Complexas.

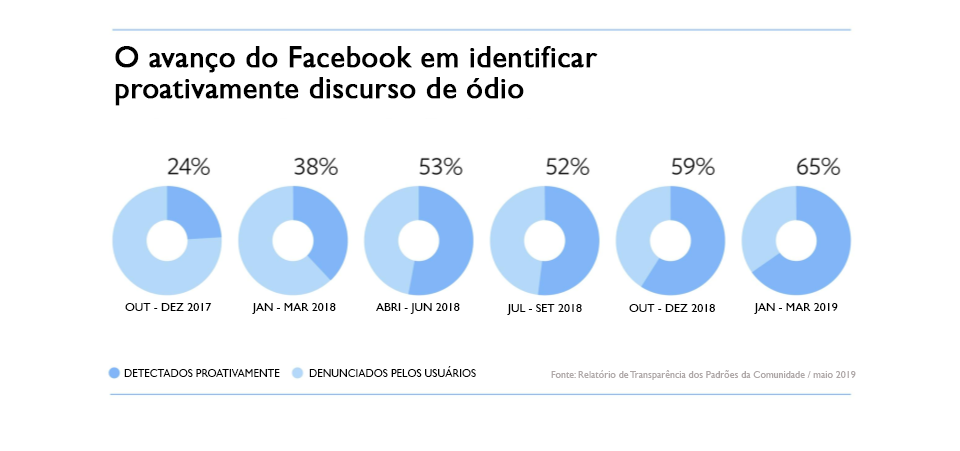

Taxa proativa: dos conteúdos que removemos, quanto foi detectado pelos nossos sistemas antes que alguém fizesse uma denúncia. Essa métrica normalmente reflete a eficácia da Inteligência Artificial em determinada área.

Em seis das políticas que incluímos no relatório, detectamos proativamente mais de 95% do conteúdo que removemos antes mesmo de uma denúncia ser necessária. Quanto a discurso de ódio, detectamos 65% do conteúdo que removemos. Há pouco mais de um ano, na primeira vez que apresentamos essas estatísticas, esse percentual era de 24%. No primeiro trimestre de 2019, removemos 4 milhões de publicações de discurso de ódio, e continuamos investindo nessa tecnologia para expandir a nossa capacidade de detectar esse tipo de conteúdo em vários idiomas e regiões.

Novo neste relatório: apelações e correção dos nossos erros

Quando removemos um conteúdo, notificamos quem o publicou e, na maioria dos casos, oferecemos à pessoa a opção de dizer se acha que cometemos um erro. Nesta terceira edição do relatório, começamos a publicar dados sobre a quantidade de conteúdos para os quais as pessoas fizeram uma apelação e quantos conteúdos foram restaurados após realizarmos sanções iniciais.

A nossa aplicação não é perfeita, mas assim que identificamos um erro nos esforçamos para corrigi-lo. É por isso que estamos incluindo a quantidade de conteúdos que foram restaurados após uma apelação e a quantidade de conteúdos que restauramos por conta própria, mesmo que nossa decisão não tenha sido contestada diretamente. Restauramos conteúdos sem apelação por alguns motivos, como:

- Quando cometemos um erro por removermos várias publicações do mesmo conteúdo, podemos usar a apelação de uma pessoa sobre nossa decisão para restaurar todas as publicações.

- Às vezes, identificamos um erro na nossa avaliação e restauramos o conteúdo antes de a pessoa que o publicou fazer uma apelação.

- Em outras ocasiões, especialmente em casos de spam nos quais removemos publicações com links que identificamos como mal-intencionados, poderemos restaurar as publicações se descobrirmos que o link não é mais prejudicial.

Estamos incluindo essas informações sobre o primeiro trimestre de 2019 em cada área de política no relatório, exceto as contas falsas:

Não é possível comparar a quantidade de conteúdos que receberam apelações em um trimestre com a quantidade de conteúdos restaurados no mesmo trimestre, visto que os conteúdos restaurados no primeiro trimestre de 2019 podem ter recebido apelações no último trimestre de 2018. Da mesma forma, os conteúdos que receberam apelações no primeiro trimestre de 2019 podem ter sofrido sanções no último trimestre de 2018.

* Vale ressaltar que a soma da quantidade de conteúdos restaurados após uma apelação e com aqueles restaurados sem apelação pode não resultar no valor exato da quantidade total de conteúdos restaurados devido ao arredondamento.

Saiba mais sobre como o processo de apelação funciona aqui.

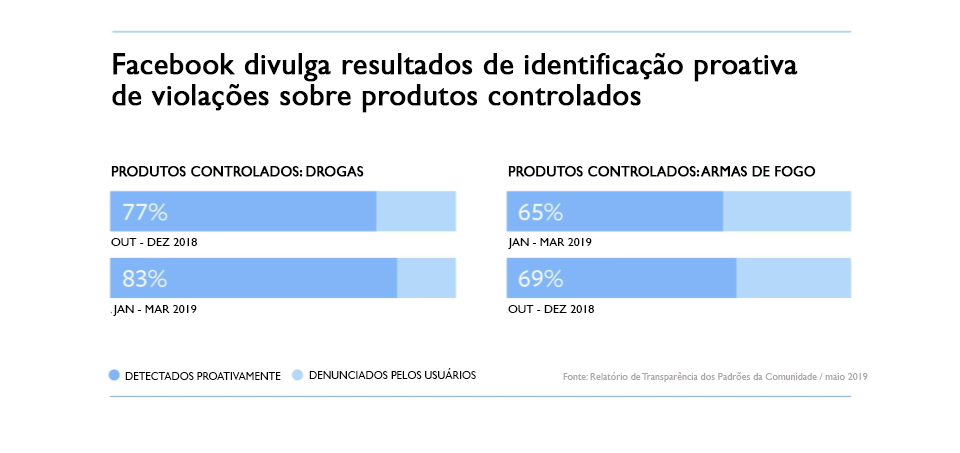

Novo neste relatório: dados sobre produtos controlados

Faz muito tempo que temos políticas contra venda de drogas ilícitas e armas de fogo. Há anos, usamos várias abordagens para aplicar a nossa política, como: investigar perfis, Páginas, grupos, hashtags e contas associadas a conteúdo impróprio que já removemos; bloquear e filtrar centenas de termos relativos à venda de drogas; e trabalhar com especialistas para nos mantermos atualizados quanto às táticas mais recentes que indivíduos mal-intencionados usam para mascarar a própria atividade, como novos nomes informais de drogas.

No meio do ano de 2018, começamos a usar Inteligência Artificial para identificar conteúdo que viola as nossas políticas de produtos controlados. Esse investimento nos permitiu remover um número maior de conteúdos e, na maioria dos casos, fazer isso antes de recebermos denúncias. No primeiro trimestre de 2019, removemos cerca de 900 mil conteúdos de venda de drogas e detectamos 83,3% deles proativamente. No mesmo período, removemos cerca de 670 mil conteúdos de venda de armas de fogo e detectamos 69,9% deles proativamente.

Ao capturar mais publicações impróprias proativamente, essa tecnologia permite que a nossa equipe se concentre na identificação de novas técnicas usadas por indivíduos mal-intencionados para burlar a detecção.

O nosso compromisso com a transparência

Ao longo ano passado, adotamos várias medidas para trazer mais transparência à maneira como desenvolvemos nossas políticas e como mensuramos nossos trabalho de aplicá-las. Em relação às políticas, começamos a compartilhar as atas da nossa reunião quinzenal na qual definimos atualizações nas nossas políticas. Agora, fornecemos um registro de alterações no site dos Padrões da Comunidade para que, a cada mês, todos vejam exatamente em quais pontos das políticas fizemos alterações. Além disso, como parte dos nossos esforços para incentivar a pesquisa acadêmica, estamos concedendo bolsas a 19 propostas de pesquisa em todo o mundo para estudar as nossas políticas de conteúdo e como o conteúdo online influencia eventos offline.

Avaliações e feedbacks externos e independentes são um componente essencial do nosso aprimoramento. Com isso em mente, criamos o Data Transparency Advisory Group (DTAG) para fazer uma avaliação pública e independente e saber se as métricas que compartilhamos no Relatório de Aplicação dos Padrões da Comunidade são significativas e refletem de forma precisa o nosso trabalho. Essa organização independente, composta por especialistas internacionais em mensuração, estatísticas, criminologia e governança, avaliará a nossa metodologia. Demos ao grupo de consultoria informações detalhadas e confidenciais sobre os nossos processos de aplicação e metodologias de mensuração. Nesta semana, a organização publicou a sua avaliação independente. No documento, ela afirmou que o Relatório de Aplicação dos Padrões da Comunidade é um exercício importante de transparência e que considerou nossa abordagem e metodologia sensatas. O grupo também destacou outras áreas nas quais podemos ser mais abertos para criar um maior senso de responsabilidade e capacidade de resposta junto às pessoas que usam a nossa plataforma. Essas informações contribuirão de forma relevante para nossos trabalhos futuros.

Continuaremos trazendo mais transparência ao nosso trabalho e incluiremos mais informações sobre os nossos esforços, para que as pessoas vejam o nosso progresso e cobrem melhorias que se fizerem necessárias.

Downloads: